L’Organizzazione europea per la ricerca nucleare di Ginevra, più nota come CERN, è una delle istituzioni più rinomate al mondo per la ricerca sulla fisica e gestisce il più grande laboratorio delle particelle del mondo.

Al suo interno, nel 2001, nasce openLab, un progetto che vuole coinvolgere in particolare le aziende che operano nel mondo Ict abilitando collaborazioni mirate al raggiungimento di nuovi traguardi scientifici.

Sono attualmente oltre 20 i progetti openLab CERN attivi, distribuiti su quattro temi di ricerca e sviluppo: tecnologia e infrastruttura del data center, prestazioni di calcolo e software, apprendimento automatico e analisi dei dati, applicazioni interdisciplinari.

A questi progetti, se ne aggiunge oggi uno di grande rilevanza. Entra a far parte di OpenLab anche Google, che firma un accordo e avvia una collaborazione con il CERN per creare nuovi strumenti computazionali e supportare la comunità scientifica nell’espandere le frontiere della tecnologia.

Il legame tra le due realtà è molto stretto e nasce da lontato; oltre ad essere uno dei più importanti istituti di ricerca per la fisica nel mondo, il CERN è stato infatti anche la culla del World Wide Web, quando Tim Berners-Lee e Robert Cailliau del CERN inventarono l’HTTP e crearono il primo sito web nel 1991 come mezzo per consentire la condivisione e l’analisi collaborativa dei dati sperimentali.

Tornando ai giorni nostri, Google e CERN collaboreranno in particolare per esplorare le possibilità di progetti congiunti di ricerca e sviluppo nel mondo del cloud computing, dell’apprendimento automatico e dell’informatica quantistica.

LHC, stare al passo con la crescita dei dati

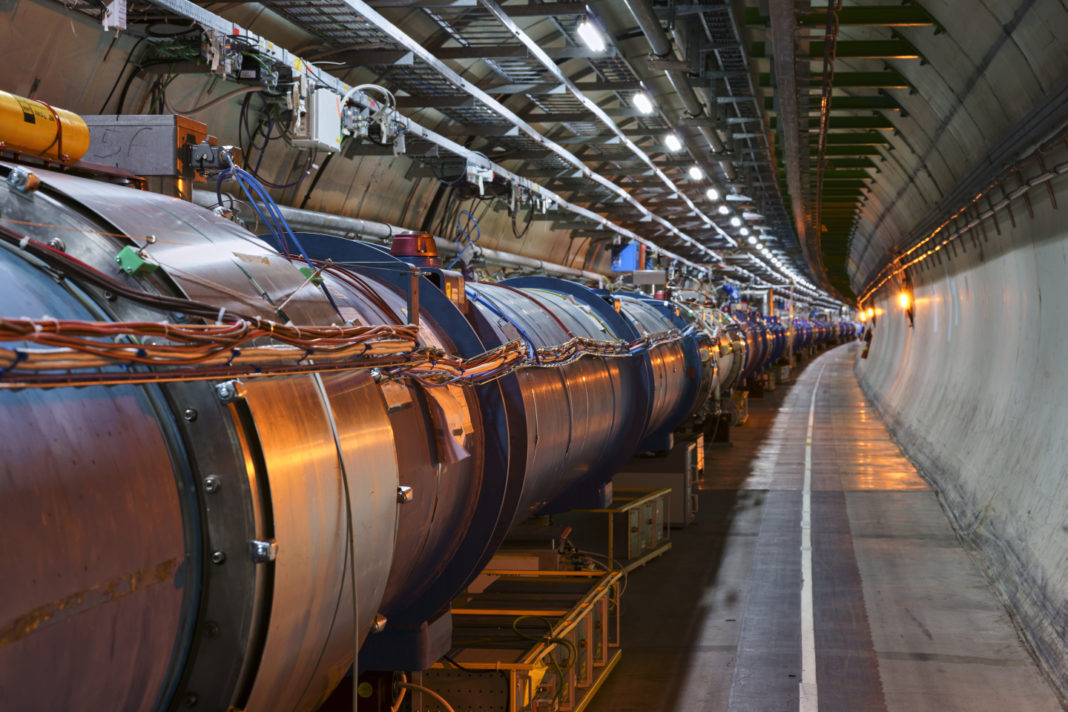

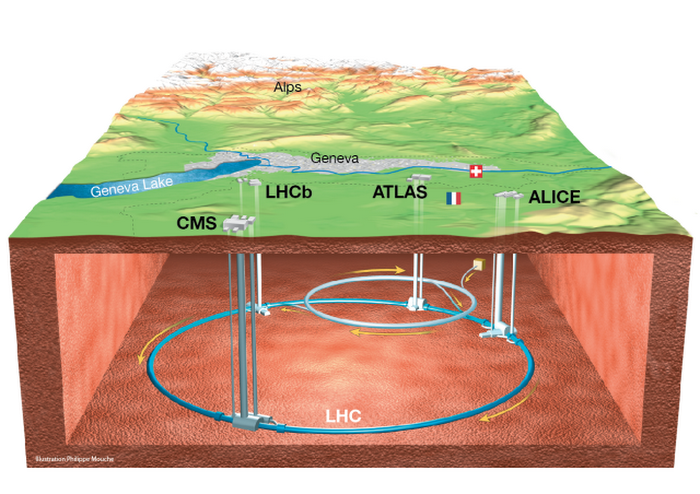

L’attività del CERN è oggi legata in modo particolare al Large Hadron Collider, o LHC, il più grande e potente collisore di particelle del mondo, utilizzato per scoprire la particella del bosone di Higgs, a lungo ipotizzata nel 2012.

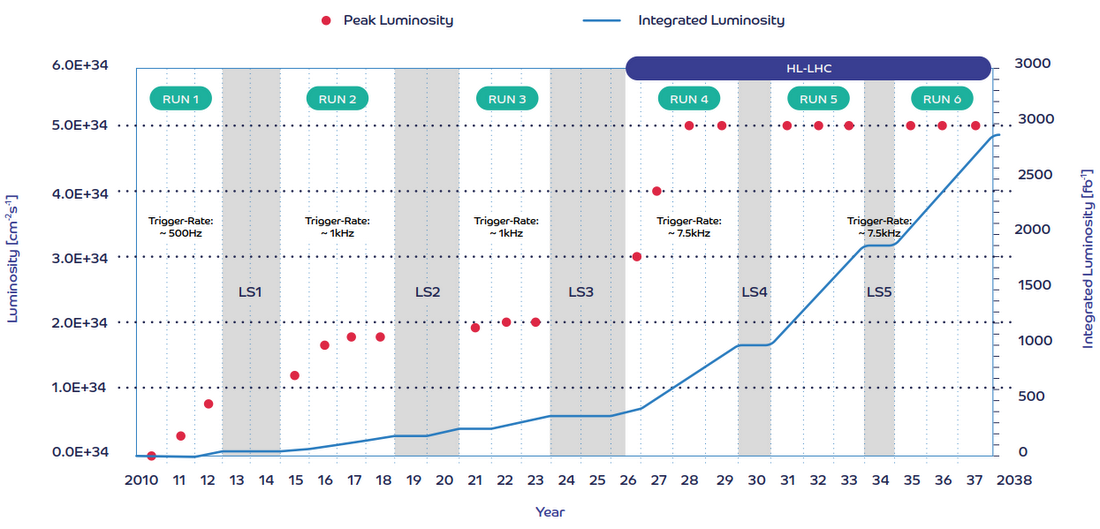

L’LHC subirà nei prossimi anni una serie di aggiornamenti che aumenteranno enormemente la visibilità dei ricercatori sulla natura fondamentale della materia, aumentando la “luminosità” e generando più collisioni di particelle. Il progetto, noto come “LHC ad alta luminosità”, o HL-LHC, dovrebbe concretizzarsi intorno al 2026.

Le sfide per la gestione dei dati nei prossimi decenni dovranno essere indirizzare all’interno del sistema LHC da capacità computazionali in grado di scalare e da servizi automatizzati e replicabili.

Supportare la gestione, l’analisi e l’elaborazione di tali dati, è il compito che spetta oggi a Google. Big G aderisce a openLab, per collaborare con la comunità del CERN per espandere le frontiere di ciò che è possibile nel calcolo, nello storage, nell’apprendimento automatico e nel calcolo quantico.

Si stima infatti che utilizzando gli attuali software, hardware e tecniche di analisi, la capacità di elaborazione richiesta sarà circa 50-100 volte superiore rispetto ad oggi e che le esigenze di archiviazione dei dati avranno di conseguenza una grandezza estremamente superiore rispetto ad oggi, quantificabile nell’ordine degli exabyte.

“Il CERN ha un ambizioso programma di aggiornamento per Large Hadron Collider, che si tradurrà in una vasta gamma di nuove sfide informatiche – afferma Alberto Di Meglio, responsabile del CERN openLab -. Il superamento di questi avrà un ruolo chiave nel garantire che i fisici siano in grado di fare nuove scoperte rivoluzionarie sul nostro universo. Riteniamo che lavorare con Google possa aiutarci ad affrontare con successo alcune di queste sfide, oltre a produrre scoperte tecniche che possono avere un impatto oltre la nostra comunità di ricerca. Siamo fiduciosi che questo sforzo congiunto porterà un grande significativo vantaggio ad entrambe le parti e in generale alla ricerca scientifica”.

Google, esperienza sul campo negli Usa

Google mette a fattor comune l’esperienza acquisita in questo contesto. L’internet company è infatti già stata coinvolta in passato nel Fermilab e Brookhaven National Laboratory (BNL), i due siti “Tier 1” statunitensi nella griglia di calcolo globale utilizzata per archiviare e analizzare i dati dagli esperimenti LHC. Nel 2016, lavorando con Fermilab, il gruppo ha dimostrato la capacità di utilizzare Google Compute Engine alla scala di centinaia di migliaia di core per elaborare i dati dal rilevatore CMS su LHC.

© RIPRODUZIONE RISERVATA