Al Museo della Scienza e della Tecnica di Milano, oltre 300 persone (tra CxO e manager) affollano lo Spazio Polene in occasione di Informatica Data Talks 2019. Scoprire e comprendere come intelligenza artificiale e machine learning trasformano l’enterprise data management è il primo obiettivo di una giornata (Inno3 media partner) che ha come valore aggiunto la possibilità di confrontarsi con le aziende che hanno intrapreso già il percorso di valorizzazione delle informazioni. Esperienze reali, così da consentire a tutti di mettere in campo progetti di customer engagement, attraverso gli analytics, innescare processi di analisi funzionali al business, con un pieno controllo della governance sia dal punto di vista normativo che dei processi interni.

Claudio Bastia, managing director di Informatica Italia: “AI e ML sono gli abilitatori digitali che permettono ai dati di generare valore e semplificano la vita ai data analyst. Informatica investe in ricerca e sviluppo su questi temi 200 milioni di dollari all’anno, ma vale molto di più constatare che gli investimenti consentono poi alle aziende che mettono a terra i progetti, di diventare davvero ‘data driven’ e fare business”.

E sulla gestione del dato e sull’Enterprise Data Platform Greg Hanson, Vp Emea e Latam Sales Specialists Informatica, imposta il keynote di apertura: “Gartner sottolinea come disporre di dati di qualità rappresenti la pietra miliare per continuare a competere nel futuro più immediato. Lo hanno già compreso le aziende che li sfruttano per migliorare e indirizzare la customer experience, consapevoli che gli strumenti di AI, non solo in termini predittivi ma per ottenere informazioni di valore, ci sono già e indirizzeranno un volume di business superiore ai 50 miliardi di dollari nei prossimi dieci anni”.

L’AI non è una black box. Banking, retail, health la sfruttano, con il machine learning, in settori sfidanti con risultati concreti, e la stessa Gartner riconosce la bontà dell’approccio di Informatica nel mettere a disposizione quanto serve per il “data management 3.0” e ridurre in modo significativo, e proficuo, il lavoro umano di “pulizia delle informazioni”.

Gli analisti sottolineano che ci si trova ad un punto di svolta: l’80% delle aziende leader di mercato si sta orientando verso un’architettura multicloud, e da qui a due anni punterà sulla customer experience abilitata dai servizi di business intelligence, data defined. Tuttavia ammette ancora oggi di sapere troppo poco sui propri clienti.

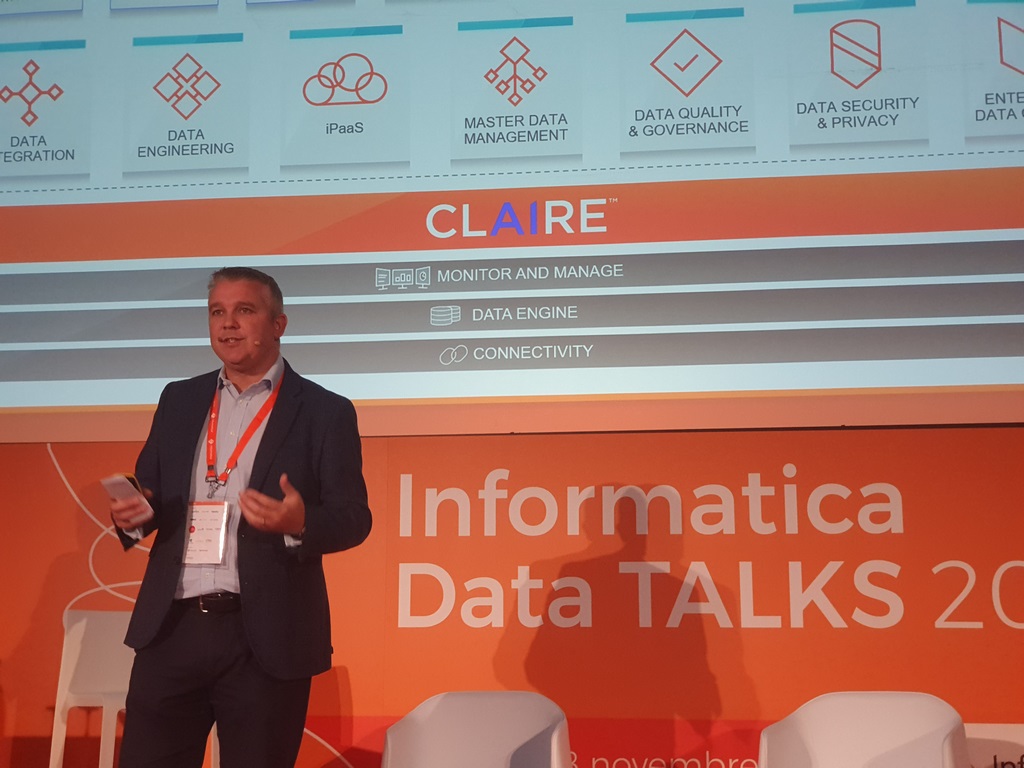

Informatica mette a disposizione per raggiungere questi obiettivi l‘Intelligent Data Platform, “metadata driven” per colmare i gap generati da datawarehouse a silos che non sono in grado di fornire valore alle aziende. Al cuore l’engine Claire (Cloud Scaled, AI-powered Realtime-Engine).

Hanson riprende: “Lo dicono i numeri. Non sono le tecnologie il problema: data security, data privacy, i silos, dirty data, e un approccio culturale scorretto ai temi legati all’AI costituiscono problemi ben più grandi, da rimuovere”. E prosegue: “I dati crescono al ritmo di 20,6 Zettabyte ogni anno, sono informazioni su cui lavorano 750 milioni di utenti (in crescita), con un traffico che per il 94% si svolge in cloud. Una piattaforma che possa indirizzare correttamente analisi e generare valore deve poter intercettare tutte le architetture, permettere l’integrazione delle informazioni, offrire strumenti di data quality e governance, consentire di fare master data management, e alle aziende enterprise di generare data catalog, in uno scenario sicuro”.

Data Talks 2019, le esperienze dei clienti

Sul campo a Data Talks 2019 parlano le esperienze dei clienti e dei partner in grado di mettere a terra i progetti di customer experience a 360 gradi, in uno scenario in cui data governance e rispetto della compliance, indirizzano alcune scelte – ma sono anche funzionali al business – e big data & analytics di prossima generazione aprono prospettive di mercato non immaginabili prima della trasformazione digitale.

Danilo Melzi, head of Data Competence Center Digital Solution Italy di Enel: “E’ più corretto parlare di percorso, che di singoli progetti. Il nostro è durato sette anni e non può dirsi concluso. Bisogna rimanere reattivi al cambiamento, tenere la barra a dritta sulla sicurezza e, per questo, capire quando serve parcellizzare i servizi, ma l’obiettivo deve essere conoscere sempre di più i clienti per servirli meglio. Abbiamo lasciato un’infrastruttura on-premise per il cloud in modo da poter crescere verticalmente e orizzontalmente”.

Con Ntt Data, Enel ha abbracciato la proposta Data Platform di Informatica. Prima ogni sistema gestionale sfruttava un proprio “modello dati”, sono stati resi coerenti per condividere le informazioni. Enel ha compreso che oltre ai dati gestionali si sarebbe potuto spremere valore dai big data, e arrivare a sfruttare modelli di forecasting ma basati su dati oggettivi. Chiude Melzi: “Un percorso possibile alla base del quale restano però le competenze e le volontà umane. Oggi possiamo definirci una data driven company e gestiamo oltre 100 Terabyte di dati al giorno”.

Oltre a Enel, significative anche le storie di Gft con Maximiliano Barberi, client unit insurance delivery manager della realtà che fornisce servizi di consulenza business e architetture IT specializzati nell’ambito insurance, e Carlo Visani, Chief Digital Advisor Lutech (progettazione di sistemi digitali e servizi end-to-end market driven). Da queste esperienze emergono alcuni temi chiave trasversali alle diverse industry: gli approcci deterministici sullo storico delle informazioni non sono sufficienti, l’analisi dei clienti in quanto esseri umani con un proprio percorso storico è indispensabile al mondo assicurativo come per le altre industry, permette di generare pattern di ricorrenza, e di formulare proposte mirate, ma bisogna disporre di dati all’altezza per farlo e lavorare su tutta la catena.

Informatica indirizza questo bisogno con le soluzioni di Master Data Management che operano in modo tale da collegare i sistemi e le informazioni e sottolinea come un tassello chiave sia il controllo sul prodotto, per esempio Mdm – Product 360 soluzione di Product Information Management basata su Dati Master. Può gestire contenuti complessi relativi ai prodotti e fornire una customer experience all’altezza. Da qui sarà possibile partire per indirizzare la trasformazione digitale basata sui dati, su fonti affidabili in grado di orientare le attività di marketing e di vendita, il retail omnicanale, l’ottimizzazione della supply chain, l’impegno di governance, le iniziative di conformità.

Task impegnativi questi ultimi che impegnano anche realtà come Dedagroup sui progetti retail (per esempio quello di Brunello Cucinelli in ambito fashion) con l’intento di approdare, attraverso l’analisi dei dati (anche da fonti molto eterogenee tra loro) a identificare il cosiddetto golden record del cliente cioè la possibilità di rappresentare in un’unica vista un insieme di dati significativi e affidabili da più sistemi.

Vista idealmente più accurata, più completa e più vera dei dati di ogni singola fonte. Si tratta di una possibilità abilitata dall’approccio Master Data management centrico della piattaforma Informatica. Spiega Luca Santoro, leader of data analytics and visualization per Capgemini: “Governare i dati in questi casa non significa solo automatizzare compiti sfruttando l’AI, quanto piuttosto cambiare alla base i modelli di business, il modo in cui si interagisce con i clienti, che rappresentano ‘singole persone’, ben oltre le logiche del semplice Crm, rispettando regole e privacy”.

Data governance, le prospettive

Compliance e data governance, appunto. Rappresentano il secondo pilastro fondativo dei lavori a Informatica Data Talks 2019 su cui business e IT delle aziende devono rapportarsi “e dialogare tra loro”.

Ne parla Fabio Schiera, responsabile servizio data governance e reporting management, Banca Monte dei Paschi di Siena con Laura Baiano, responsabile area applicazioni governo, consorzio operativo del Gruppo Montepaschi: “Il peso della governance nel mondo banking è impegnativo, si tratta di un committment importante. Se il dato deve essere trattato nel rispetto dei regolamenti e Psd2 pone nuove sfide, è chiaro anche che non si può rinunciare ai bilanci, ed è doveroso misurare il ritorno sugli investimenti di questi progetti”.

Per farlo è oggi possibile inserire Kpi sulla data governance nelle diverse unità di business, ma anche prepararsi a integrare correttamente le fonti esterne e a imparare a prendere decisioni su dati di terze parti integrati, nel rispetto delle normative sui processi. Baiano: “Certo è così, coscienti del fatto che gestire l’innovazione nello scenario normativo esistente richiede da un lato di essere reattivi, ma anche di formulare mappe applicative precise, per riuscire ad orientarsi su percorsi a medio e lungo termine. Senza queste si fa poca strada”.

Gdpr, privacy, Psd2 (in ambito fintech) hanno avuto il merito di portare le realtà organizzative e le aziende a ripensare al trattamento dei dati. Non è rinunciabile comprendere le distinzioni tra dati di produzione e pre-produzione, vincolare i processi alla possibilità di controllarli, inventariare le applicazioni utilizzate, procedere alle valutazioni relative ai rischi, anche con un’attenta stima delle conseguenze che eventi indesiderabili potrebbero avere e quindi con un’opportuna strategia di data masking, secondo linee di condotta per cui la sicurezza del dato.

Costa Crociere, Fca Bank (con Target Reply), Angelini (con Nodes), ognuna nel proprio ambito, hanno raccolto queste sfide sfruttando anche le soluzioni di Informatica. Per esempio, utilizzando tool come Secure@Source soluzione di intelligence e analytics di sicurezza dei dati per identificare i rischi e permetterne la mitigazione, e Tdm (Test Data Management Tools) come strumento di provisioning sicuro e automatizzato di dataset non di produzione per soddisfare le esigenze di sviluppo e testing preservando la sicurezza delle informazioni.

In questo contesto, Fca Bank ha utilizzato le soluzioni Tdm di Informatica e dato vita ad una best practice su un percorso tra il 2015 e oggi impostato sulle fasi tipiche progettuali di assessment, discover, apply, analyze and measurement, e infine monitoring. Alessandro Lunaschi, information security e governance di Fca Bank con il partner Target Reply mette in evidenza i benefici più immediati a partire dal “consolidamento di uno scenario applicativo complesso, la connettività tra sistemi eterogenei (per ottenere con l’ordine maggiore sicurezza), l’attenzione alle risorse su cui sui fa data masking con l’identificazione delle chiavi di coerenza”.

Angelini (medicinali) rappresentata da Matteo Orsini, research & Development & BI analyst individua in “standardizzazione, ottimizzazione dei processi attraverso la riduzione degli interventi manuali, guadagno in consistenza, e gestione granulare del prodotto come dei dati” alcuni passaggi chiave funzionali alla valorizzazione “compliant” dei dati”. Mentre Alberto Storace, managing director Digital Applied Intelligence di Accenture, sottolinea: “Chi ha iniziato prima il percorso di applicazione di un framework di data governance ha speso meno. Ora si tratta di ingegnerizzare il metodo e rendere i framework efficienti. Il cambiamento culturale stesso in azienda si è rivelato avere costi molto elevati”.

Big data, next generation

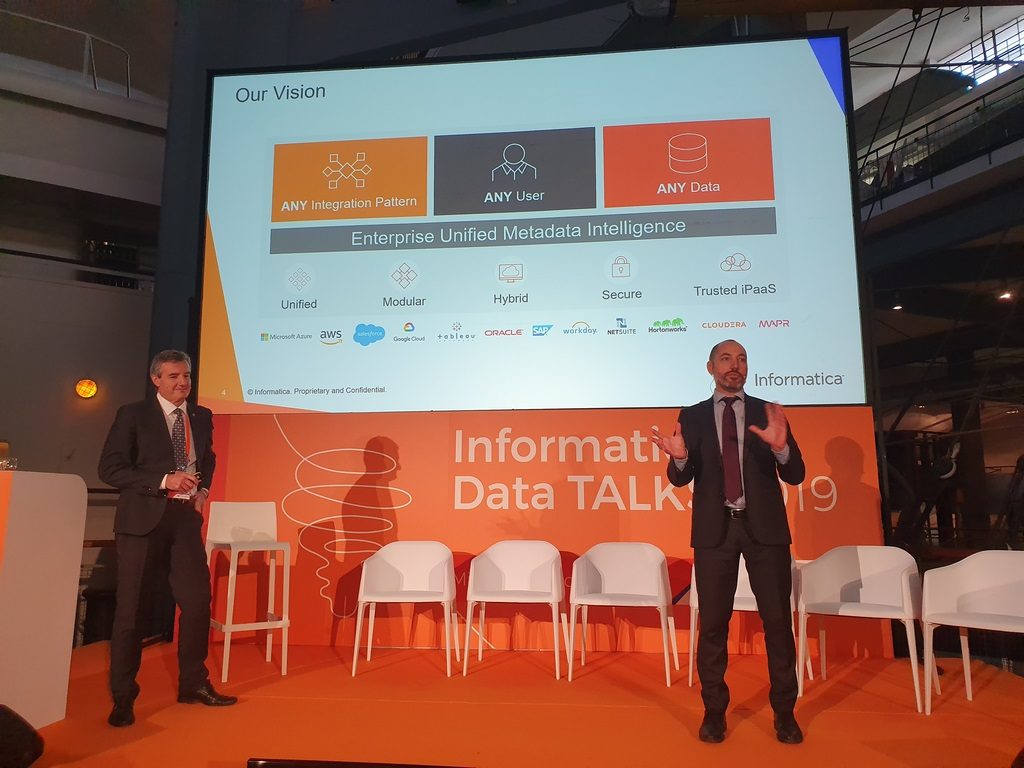

Portare il dato a generare valore in modo sistematico è la prossima sfida. Un’opportunità abilitata, secondo Informatica, attraverso la Data Architecture Modernization e le possibilità offerte dalla piattaforma di Informatica che come Integration Platform as a Service erogata come SaaS si caratterizza per tre elementi: la possibilità di soddisfare ogni pattern di integrazione, tutti gli utenti (industry) e qualsiasi tipologia di dati, anche quelli eterogenei e non strutturati caratterizzanti i data lake 3.0.

A nostro avviso due i casi più interessanti. Il primo, quello di Crédit Agricole, nel racconto di Alessandro Allini, responsabile data management: “Il piano industriale del gruppo per la prima volta mette in evidenza il concetto di architettura datacentrica, in un contesto che ha vissuto la sua storia di stratificazione di dati e sistemi in silos isolati e ora sceglie per ragioni di compliance e sicurezza di voler tenere le proprie informazioni nei data center aziendali”.

Ecco, in questo contesto Informatica ha permesso di “smarcare l’architettura dei dati dalla tecnologia sottostante”, e di “automatizzare una serie di processi, sfruttando al massimo le possibilità offerte da una gestione a 360 gradi dei metadati, indispensabile per poter parlare di governance”. Il secondo caso è quello di Engie con il partner Aubay. Spiega Giorgio Jacchini, senior project manager di Aubay: “Nell’ambito delle utility, oltre alla gestione corretta del dato cliente, a partire dai consumi, è inevitabile pensare al prossimo futuro di raccolta dei dati dai sensori e quindi alle opportunità offerte dai tool di predictive maintenance”.

In questi casi l’interazione diretta con il dato vivo innalza il livello di complessità, perché non è possibile agire rallentando i sistemi. Aubay ha quindi aiutato Engi a riformulare la propria data strategy a partire dall’attività di assessment (focalizzare gli obiettivi, definire certificazioni delle fonti di alimentazione, mettere sotto attenzione i dati freschi e disponibili, utilizzare i dati con strumenti evoluti di data analysis), quindi si è formulata un’idea di architettura consistente, per avviare poi le attività di sviluppo in modalità Agile, con sviluppo interattivo e pianificazione adattiva e con il continuo e costante coinvolgimento di Engie.

L’architettura finale ha previsto la creazione di un Big Data Hub (sfruttando le soluzioni Big Data Management di Informatica) on-premise con Hadoop di Cloudera e quattro “zone”: l’atterraggio dati su un unico punto, una sorta di “aeroporto per i dati” (1), una trusted data zone dove il dato viene elaborato, certificato e in cui viene gestita la politica di storicizzazione delle informazioni (2), l’area innovativa (Data Zone) dove sono presenti tutte le informazioni a livello di dettaglio ad uso e consumo dei data scientist e dove applicare le tecnologie di data science (3) e infine la zona che predispone i dati pre-lavorati all’utilizzo di front-end.

Tutti percorsi possibili, questi raccontati a Informatica Data Talks 2019, e in alcuni casi anche esportati all’estero, pur consapevoli che, soprattutto in Italia c’è tantissimo da fare. Un “dato certo” però è che i buoni esempi non mancano.

© RIPRODUZIONE RISERVATA