Le aziende riconoscono che la capacità di raccogliere da fonti eterogenee le informazioni, per valorizzarle, nei prossimi anni richiederà disponibilità di competenze verticali oggi difficili da trovare e da formare. Non ci si improvvisa data scientist ma è proprio a queste figure professionali che le aziende devono guardare per trovare la via di spremere valore dalle informazioni, a partire dall’organizzazione dei data lake.

Tante realtà poi devono ancora orientarsi tra le normative (per esempio già solo quelle relative alla privacy), modelli di business in divenire, e fonti dati da “addomesticare”. Ecco che, in questi casi, è evidente come le capacità di analisi rappresentino solo un secondo step, da affrontare dopo aver risolto il problema di uno scenario frammentato e prima di poter effettivamente offrire una sintesi di risultato.

Per questi motivi, secondo Qlik, l’agenda dell’anno appena iniziato nell’ambito della data analytics è cadenzata dalla capacità di affrontare e comunque di confrontarsi con cinque trend.

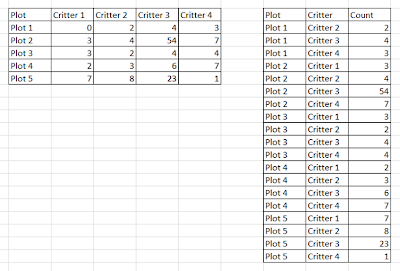

Di questi quello che meglio rappresenta la situazione attuale è proprio il primo, relativo ai wide data. Possiamo rappresentare la differenza tra wide data e long data con una tabella come quella della figura seguente, ma in questo caso è importante identificare il problema nell’ampissima varietà di dati nelle diverse tipologie di database, mentre infatti sono cresciute in modo virtuoso le possibilità di allocare le informazioni su risorse cloud adeguate, non altrettanto è avvenuto per quanto i riguarda i formati.

Qlik evidenzia come fossero 162 nel 2013 e siano 342 nel 2019, ma certo chi sarà in grado di convertire e riuscire a fare sintesi tra fonti di dati frammentate avrà un vantaggio competitivo reale.

Anche la possibilità di trovare soluzioni di analytics prêt-à-porter presenta un aspetto positivo e uno negativo. Da un lato si tratta di soluzioni accessibili ad un numero maggiore di realtà, dall’altro la gestione stessa dei dati non avrebbe l’agilità oggi possibile senza l’offerta di DataOps. Si tratta di una metodologia di trattamento sui dati, orientata ai processi utilizzata dai team di analytics per migliorare la qualità delle informazioni e ridurre quindi il ciclo di analisi del dato e oggi costituisce proprio un approccio specifico indipendente dall’analisi.

Così oggi l’80% dei dati può essere consegnato sistematicamente agli utenti, riservando la preparazione dei dati self-service a un ristretto numero di situazioni. E con gli analytics garantiscono fluidità lungo l’intera catena di valore delle informazioni.

Serve allo stesso tempo una serie di sforzi in ambito education, sulle persone, per aiutarle a diventare consapevoli nella lettura e nell’interpretazione dei dati. E’ atteso per il 2020 un innalzamento del livello di alfabetizzazione in questo ambito, da raggiungere affidandosi alle competenze dei partner all’altezza, identificati da Qlik tra coloro che sono in grado di combinare competenze tecnologiche con formazione e supporto (Data literacy as a Service).

Arriviamo così ad individuare gli ultimi due trend che dovrebbero caratterizzare l’anno. Il primo è relativo all’impiego di algoritmi in grado di aiutare gli analytics ad individuare tra le caratteristiche dei dati anomalie e a suggerire intuizioni, per esempio suggerendo anche set di dati da analizzare in parallelo (una sorta di funzionalità Shazam da applicare sui dati).

Il secondo legato strettamente alla crescita nell’utilizzo di cataloghi di metadati basati su AI, in grado di garantire un tessuto connettivo tra DataOps e analytics self-service. Queste soluzioni dovrebbero infatti semplificare la vita alle aziende che, in un contesto in cui cresce in modo significativo la richiesta di cataloghi di dati si trovano poi a gestire grandi moli di informazioni distribuite su più sorgenti.

© RIPRODUZIONE RISERVATA