Con gli annunci della scorsa estate Veritas riposiziona la propria offerta in modo coerente in relazione ai tre pillar strategici – Availability, Protection e Insight – collocati sotto l’ombrello della Enterprise Dataservice Platform. Una platform quindi che segna concretamente lo stacco dall’idea di una semplice suite – ovvero un insieme di prodotti che rispondono ad esigenze diverse – e prevede un’interoperabilità molto stretta grazie alla quale quando un prodotto “riconosce” che presso il data center di un cliente, o nei propri servizi in cloud, è presente un’altra tecnologia Veritas, aggiunge ulteriore valore.

Si tratta di approccio teso a portare astrazione e semplificazione in un contesto di evoluzione dei data center – sempre più sofisticati, distribuiti, complessi – con l’aggiunta di ulteriori challenge dell’IT derivanti dalla crescita esponenziale dei dati e dei rischi di attacchi informatici.

Entra nei dettagli della proposta tecnologica Carlo Viganò, Technical Sales Manager: “Sì, di fatto Veritas offre un livello di astrazione per le tematiche di data availability, protection e governance rispetto alla geolocalizzazione dell’informazione e alla tipologia dell’informazione stessa, tenendo conto sia delle direttive di compliance (Gdpr, analisi, auditing e indagini forensiche), sia delle richieste e sfide che arrivano quotidianamente ai CIO, impegnati ad attuare l’adozione di nuovi modelli informatici come il cloud, l’allineamento con gli SLA di Business, ed il contenimento dei costi e dei fattori rischio: uno su tutti, l’aumento della cybercrime“.

I Cto e i Cio si confrontano per questi motivi con Veritas che, con una solida storia nell’ambito della Data Protection e della Availability in Campus o per il Disaster Recovery, oggi porta ai clienti soluzioni d’avanguardia nell’ambito dei Big Data, l’adozione del Cloud, dei Container e degli ambienti Hyperconvergent, impostando nuovi paradigmi di offerta a valore e riaffermandosi leader riconosciuto per la capacità di innovazione proprio su queste tematiche.

Per intenderci, se negli anni ‘70 il mainframe “virtualizzava” hardware e sistema operativo per le applicazioni, e più tardi negli ambienti client/server si incominciavano a segmentare i servizi applicativi per renderli portabili, con una corsa alla standardizzazione delle architetture, dove il “virtualizzare” era legato ad una più semplice gestione di hardware differenti, OS differenti e tutte le dinamiche di alta affidabilità sui server On Prem ed in campus, oggi con Veritas è possibile parlare di astrazione totale delle infrastrutture e della mobilità di applicazioni e dati, per soddisfare gli SLA del servizio, dovunque esso sia, al costo più basso possibile, e secondo criteri di sicurezza condivisi e predefiniti.

In questa logica i primi pilastri di “astrazione” nell’offerta Veritas sono quindi Infoscale e VRP (Veritas Resiliency Platform). Il primo ha alle spalle una storia più che ventennale. Se in origine mediante le sue prime versioni era possibile virtualizzare volumi disco, la capacità di calcolo e di I/O, i canali di connessione ai server con le SAN, oggi è possibile virtualizzare qualsiasi hardware di Storage, più o meno veloce e sofisticato, su qualunque server ed hypervisor, in qualsiasi location, con una soluzione di Software Defined Storage che gode della più alta adozione di mercato per stabilità, astrazione, performance, resilienza, favorendo portabilità da-verso qualunque device e/o location. Carlo Viganò: “Essere affidabili oggi significa assicurare la ‘recovery’ in una logica che prescinda dall’ubicazione fisica di infrastrutture e applicazioni”: pensiamo a soluzioni “di cluster (Architecture in HA) per metà on premise e per metà in cloud – secondo policy di performance o di Long Term Retention dell’applicazione- così come a cluster cross cloud-region presso un cloud provider, piuttosto che soluzioni in HA o in DR cross-cloud providers differenti, così da eliminare anche qualunque timore di possibili lock-in. L’obiettivo è sempre “restituire al cliente la vera ownership sulle applicazioni e sulle informazioni”.

Veritas ha in corso business case importanti al riguardo. Per esempio è possibile permettere ai clienti di sfruttare le fasce temporali più vantaggiose presso un cloud provider, muovendo spplicazioni e i dati replativi, per accendere la stessa su un cloud o un altro all’occorrenza. Carlo Viganò: “il mercato Italiano da questo punto di vista ci sta dimostrando di aver ben assimilato queste logiche; fra gli ambiti più maturi ed aperti certamente troviamo il Finance, la PA, e l’industria”.

Performance, affidabilità e riduzione dei costi sugli storage primari sono quindi i bisogni indirizzati dalla proposta Infoscale: è possibile virtualizzare talmente bene applicazioni e relativi dataset grazie al machine learning della soluzione, tale per cui le tablespace o le share accedute, possono essere spostate dinamicamente e trasparentemente sullo storage più appropriato per costi e performance, in locale o in remoto, o nel cloud (per esempio bucket S3), ottimizzando cosi i costi dello storage primario.

Se da un lato Infoscale è il prodotto alla base per le soluzioni di Availability, VRP svolge invece la funzione dell’orchestratore. Mediante questa soluzione, è possibile correlare tutti gli stack e le interdipendenze di un servizio applicativo, in una sorta di “bolla autoconsistente”: l’utente definisce infatti il business group che, secondo gli SLA impostati, è possibile muovere da un data center ad un altro, dal data center al cloud e anche da cloud a cloud, in modo semplice e mantenendo l’ownership totale degli oggetti applicativi e dei loro dati. Viene inoltre evidenziato il vantaggio di poter testare in modo preliminare e non ivansivo, la recovery e ripartenza da una situazione disastro, con un single click.

NetBackup, protezione ransomware

Nata come azienda di infrastrutture IT, durante gli anni con Symantec, Veritas ha capitalizzato sensibilità, tecnologie ed esperienza sulle tematiche della security; capability che oggi ha focalizzato negli ambiti della Data Protection. Ciò significa implementare su tutte le nostre soluzioni criteri multi layer per aumentarne la sicurezza riducendo la superficie di attacco e minimizzando i rischi che potrebbero scaturire da ransomware e/o da altri attacchi informatici. Carlo Viganò: “Un tema – quella della protezione dei dati – che dopo la separazione da Symantec è cresciuto sulla scia di una chiara e forte strategia di product enhancement, con investimenti importanti, non solamente recuperando alcuni gap tecnologici ma andando a scrivere nuovi criteri di adozione”. Gli analisti di settore sono chiari: entro il 2021 il mercato della cybercrime varrà più di 20 miliardi di dollari e si parla di un attacco ogni circa 15 secondi. Gli utenti sanno bene come l’essere oggetto di attacco informatico sia una questione di pura probabilità statistica. Per Veritas quindi la parola d’ordine è prevenire, mitigare il più possibile il rischio, ed “offrire una pronta guarigione” – ripristino– in caso di attacco.

Da qui la proposta di Data Protection di Veritas, leader di mercato nel quadrante Gartner per base installata e maggior numero di macchine virtuali protette, per la protezione dei big data e dei data lake, per la adozione semplice di modelli cloud efficienti e sicuri sfruttando la deduplica permanente in tutte le fasi e l’encryption. Inquadriamo lo scenario. “I progetti di big data analytics, nello scorso decennio, nascevano all’interno delle aziende a “macchia di leopardo”, con budget e risorse limitate a cura del marketing e/o di nuove iniziative, oggi invece – spiega Viganò – è il business stesso che chiede la protezione dei Big Data, considerati ora business o mission critical, e con impatti rilevanti in fatturato ed immagine in caso di non disponibilità“. La proposta di Veritas per assicurare la disponibilità del dato è NetBackup, in grado di indirizzare in modo corretto le esigenze di scalabilità e performance di tutte le aree applicative, delle nuove aree Big Data ed anche le tematiche sicurezza per criticità come i Ransomware.

I vantaggi di NetBackup

Oggi gli attaccanti informatici prima cercano di bloccare/corrompere le immagini di backup e solo in un secondo momento bloccano i dati di produzione. Per cui quando il cliente se ne accorge è troppo tardi. NetBackup introduce un sistema multilayer con vari livelli di protezione. Prima di tutto si parla di un sistema di hardenizzazione del sistema operativo e del software (1). Attraverso una serie di operazioni e best practice specifiche di configurazione base e delle sue componenti, vengono minimizzati i possibili attacchi informatici che sfruttano potenziali vulnerabilità, migliorandone pertanto la sicurezza complessiva: Violare un sistema firmwareizzato non è semplice come violare un sistema operativo standard.

Con Netbackup, Veritas inoltre rilascia vulnerability test molto profondi e guideline relative alle best practice per la sicurezza (2). La soluzione permette una corretta limitazione agli aventi diritto di accesso alle immagini dei backup (3), e opera in una logica di broadcasting delle immagini di backup (gestione delle immagini anche in location diverse e su dispositivi diversi) per cui l’attaccante dovrebbe eludere tutti i livelli preliminari, i sistemi di encryption, locking e deduplica in locazioni su dispositivi differenti. Una vera ed importante minimizzazione della superficie di attacco a garanzia della integrità delle immagini di backup (4). Infine, ogni backup viene analizzato dai motori di cybersecurity interni, viene deduplicato e criptato e quindi mosso nelle destinazioni stabilite. NetBackup si pone quindi come piattaforma di data protection, massivamente parallela, ransomware proven e virtualizzata rispetto a tutte le dinamiche di modello di adozione e di deploy: è adottabile e fruibile come Appliance, come servizio nel Cloud, oppure come software only, BYOD.

Netbackup è sato totalmente rescritto in Html 5, è multi tenant, caratteristiche che piacciono in particolar modo ai service provider che operano su realtà per lo più virtualizzate e service oriented e si integra con i principali strumenti di automation e trouble ticketing. Con la nuova architettura di prodotto, Veritas ha rilasciato per prima i plugin (agent free) per gli ambienti Hadoop, Cloudera, MongoDB … e tutto il mondo dei NoSql, piuttosto che per realtà di Storage scale-out come Isilon, Nutanix, Pure Storage ad esempio. Dotato di motore di protezione, di un sistema operativo firmwarizzato e hardenizzato, offre plus di sicurezza e robustezza di assoluta rilevanza. La modularità dell’architettura che adotta i Containers e la scalabilità prestazionali rappresentano infine ulteriori differenze apprezzate dai nostri clienti.

Veritas, Data Insights con Aptare

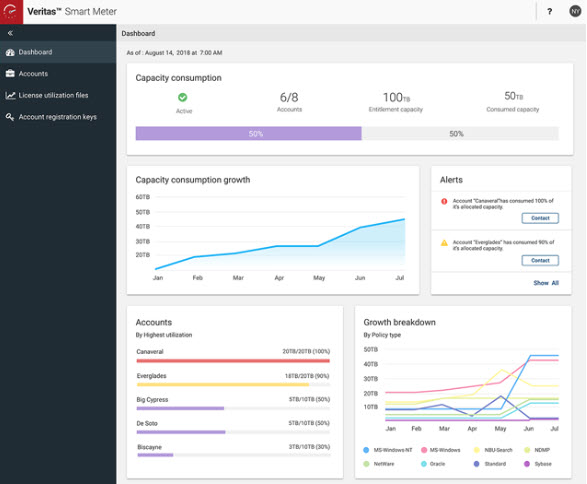

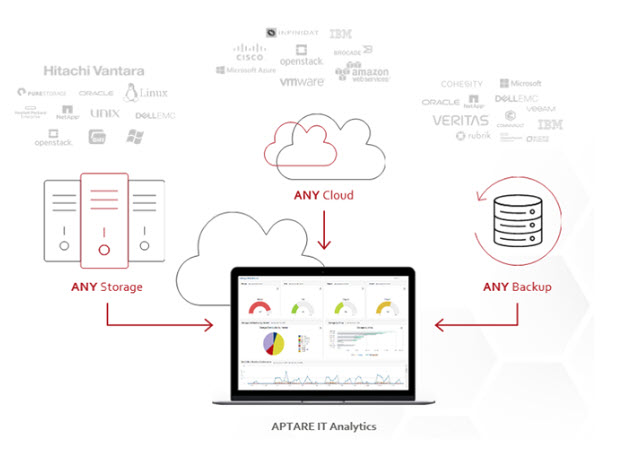

Aptare nasce tredici anni fa come software vendor indipendente per abilitare reportistiche di tipo analitico all’interno di NetBackup. Si è poi sviluppata con piattaforma di IT analytics vera e propria, raccogliendo e correlando le informazioni dei metadati provenienti da moltissime sorgenti di Storage, SAN, Cloud, ambienti di Backup, OS, Volume Manager, Hypervisor, DB … presenti sul mercato, con lo scopo di evidenziarne le dinamiche di Capacity Planning, Charge Back, criticità eventuali di performance o availability. Veritas acquisisce APTARE nel 2019. I clienti che chiedono una reportistica accurata, non solo sui backup, trovano in Aptare le informazioni più dettagliate sulla loro infrastruttura, per qualsiasi data source, in qualunque location. La soluzione adotta sin dalle sue origini techniche di AI e machine learning pertanto beneficia di algoritmi maturi oltre che di una base installata immensa quale campione per analisi veritiere.

In sintesi, oggi Aptare consente di fare IT Analytics di tutta l’infrastruttura. I clienti chiedono documentazioni conformi e informazioni dettagliate supplementari, al fine di poter costruire use case, documentare i capacity planning, così come per esigenze di cost/risk reduction; vogliono inoltre conoscere nel dettaglio le informazioni dei costi per il chargeback e fare correlazione di eventi su modelli di tipo What-If: determinare il costo di una applicazione ON-PREM, e simulare quanto costerebbe nel Cloud: Aptare soddisfa tutti questi bisogni.

Aptare, i vantaggi per il business

Non sono pochi i clienti che l’hanno già scelto ed implementato per la sua maturità, per le sue capacità pervasive, per la capacità di indirizzare reportistiche analitiche in scenari infrastrutturali ed applicativi eterogenei e per ogni esigenza di data governance. Aptare definisce e correla le informazioni delle infrastrutture degli ambiti applicativi del/dei data center – localizzati, distribuiti, o collocato presso Cloud/Service provider – estrapolando findings sui trend di crescita ed utilizzo, sulle criticità di performance o di availability dell’operatività quotidiana, agevolandone la gestione ed il controllo da un unico pannello centralizzato.

Aptare raccoglie i dati in modalità non invasiva, per mezzo di data collector distribuiti e convoglia su un cruscotto centralizzato il flusso dei metadati, correlandoli secondo criteri già predefiniti o customizzabili; ad esempio è in grado di evidenziare server “orfani”– che comunque hanno un valore di asset – oppure evidenzia eventuali point of failure dell’infrastruttura o una mancanza di backup su sever o applicazioni, eventuali livelli di saturazione (rischio) o di basso utilizzo (spreco).

Aptare permette l’assessment completo dell’infrastruttura distribuita – anche in cloud- e si propone laddove c’è un minimo di complessità infrastrutturale. Realtà con una SAN, con Storage differenti di Vendor diversi, con una o più soluzioni di backup, rappresentano il punto di partenza ideale dove poter apprezzare le sue caratteristiche.

Aptare è multitenant, ideale per i Service Provider o per aziende che intendono segregare gli ambiti applicativi anziendali ai fini del Chargeback, ad esempio: permette infatti la verifica degli SLA applicativi impostati, se questi stanno o meno rispettando il livello di risposta atteso. E’ possibile quindi associare ad una applicazione determinata la “fotografia” della sua infrastruttura con tutte le interdipendenze, in una vista Top-Down dall’applicazione all’infrastruttura, e vice versa.

Aptare offre metriche e report sugli economics, per vari scopi, quali il capacity planning, il risk/cost/performance assessment, il chargeback.

I bisogni di visibilità e controllo dei clienti in ambito IT sono molteplici; la suite indirizza tali i bisogni e supporta i vari stakeholder su questi loro challenge: uno dei valori riconosciuto di Aptare è proprio la capacità di correlazione; una “sentinella” di tutta l’infrastruttura, a disposiziopne di coloro che gestiscono il backup, i server, le SAN, il cloud, e son chiamati a rendere visibili, servizio per servizio, i trend di utilizzo, le aree a rischio, offrendo report fino alla più fine analisi sugli economics infrastrutturali.

Carlo Viganò: “In un ideale journey to cloud, Aptare consente di valutare gli impatti economici di una migrazione in cloud, ed in relazione ai modelli economici dei cloud provider, il cliente può capire come approntare al meglio la propria strategia di go-live sulla base di dati certi”.

Non perdere tutti gli approfondimenti sul tema e vai alla room Veritas Data Protection Senza Compromessi

© RIPRODUZIONE RISERVATA