In appena dodici mesi è triplicato nelle aziende l’utilizzo dell’intelligenza artificiale generativa. E tuttavia le organizzazioni faticano a comprendere, mettere a fuoco, coniugare possibilità di utilizzo sicure e gestione del rischio. Cloud and Threat Report: AI Apps in the Enterprise, ricerca dei Netskope Threat Labs, mette a fuoco proprio questi aspetti.

Lo studio si basa su dati di utilizzo anonimizzati, raccolti dalla piattaforma Netskope Security Cloud, relativi a un sottoinsieme di clienti Netskope previa autorizzazione. E le analisi del rapporto si basano su un periodo di osservazione di tredici mesi dal 1 giugno 2023 al 30 giugno 2024, su milioni di utenti in centinaia di organizzazioni (con oltre 1.000 utenti di AI app attivi) in tutto il mondo operative in diversi settori, tra cui servizi finanziari, sanità, produzione, telecomunicazioni e vendita al dettaglio.

I ricercatori osservano che il 96% delle aziende utilizza la GenAI, ed è proprio questo il dato triplicato negli ultimi mesi. Vengono utilizzate in media quasi 10 applicazioni di GenAI, rispetto alle 3 dell’anno scorso ma solo l’1% degli utenti utilizza una media di 80 applicazioni, in aumento rispetto alle 14 (effettivamente comunque tante, Ndr.).

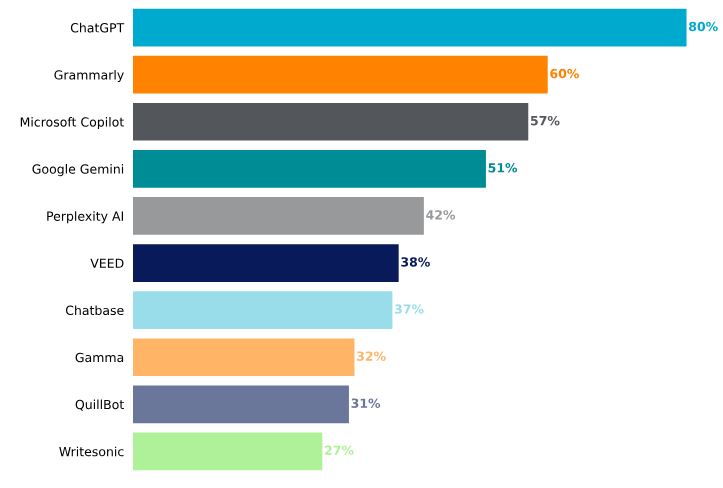

ChatGpt è l’applicazione più popolare, utilizzata da oltre l’80% delle aziende, con Microsoft Copilot che registra però la crescita più significativa nell’utilizzo dal lancio nel gennaio 2024, pari al 57%. Per quanto riguarda le modalità di utilizzo da parte degli utenti, mentre la percentuale complessiva di utilizzatori di app GenAI è ancora relativamente bassa, il tasso di crescita è significativo, passando dall’1,7% a giugno 2023 a oltre il 5% a giugno 2024, quasi triplicando in 12 mesi per l’organizzazione media. Anche le realtà con un numero di utenti al mese superiore alla media hanno registrato un’adozione di GenAI significativa anno su anno: il 25% delle organizzazioni cresce in questo senso dal 7% al 15% nell’utilizzo di app GenAI. La crescita, secondo gli analisti di Netskope, continuerà nel prossimo anno.

Quasi un’azienda su cinque però ha imposto un divieto totale su Github CoPilot. Spieghiamo ed entriamo nei dettagli: con l’incremento dell’utilizzo, le aziende registrano anche un incremento della condivisione del codice sorgente proprietario all’interno delle applicazioni GenAI, che rappresenta il 46% di tutte le violazioni documentate di policy Dlp (Data Loss Prevention). Per le aziende è quindi complicato controllare l’esposizione ai rischi. Anche perché la stessa ricerca evidenzia pure come i dati regolamentati (dati che le organizzazioni hanno il dovere legale di proteggere) costituiscano più di un terzo dei dati sensibili condivisi con applicazioni di intelligenza artificiale generativa (GenAI), un ulteriore rischio, per le aziende, di costose violazioni dei dati.

A fronte di un’effettiva complessità nel gestire l’esposizione, circa il 75% delle aziende intervistate ora blocca completamente almeno un’applicazione di GenAI. L’obiettivo è limitare il rischio di esfiltrazione di dati sensibili. Il metodo però non necessariamente è virtuoso perché meno della metà delle organizzazioni applica controlli incentrati sui dati per impedire la condivisione di informazioni sensibili nelle richieste di input degli utenti.

L’utilizzo di soluzioni avanzate di data loss prevention non è di fatto matura quanto dovrebbe, ma non mancano nemmeno le notizie positive al riguardo. Per esempio, la ricerca riporta che il 65% delle aziende implementa il coaching per gli utenti in tempo reale per guidare le interazioni degli utenti con le applicazioni GenAI. E la stessa ricerca verifica come il coaching degli utenti abbia un ruolo cruciale nel mitigare i rischi relativi ai dati, tanto che il 57% degli utenti modifica poi le proprie azioni dopo aver ricevuto degli alert. “Le aziende devono riconoscere che i risultati ottenuti dalla genAI possono inavvertitamente esporre informazioni sensibili, diffondere disinformazione o persino introdurre contenuti malevoli – commenta James Robinson, chief information security officer, Netskope – questo richiede un solido approccio alla gestione del rischio per salvaguardare i dati, la reputazione e la continuità aziendale”.

Il punto di partenza per modificare postura e approccio dovrebbe essere rivedere, adattare e personalizzare i propri framework di rischio, specificamente per l’intelligenza artificiale, a partire proprio da iniziative come il framework di gestione del rischio AI del Nist. Quattro i passaggi chiave: valutare gli usi esistenti dell’intelligenza artificiale e dell’apprendimento automatico, delle pipeline di dati e delle applicazioni GenAI ed identificare le vulnerabilità e le lacune nei controlli di sicurezza (fotografia dello stato attuale,1); stabilire misure di sicurezza fondamentali, come controlli di accesso, meccanismi di autenticazione e crittografia (implementazione di controlli avanzati, 2); sviluppare una tabella di marcia per controlli di sicurezza avanzati (3), a partire dall’analisi sulla modellazione delle minacce, il rilevamento delle anomalie, il monitoraggio continuo e il rilevamento comportamentale così da identificare i movimenti di dati sospetti negli ambienti cloud e verso le applicazioni genAI; ed infine valutare con regolarità l’efficacia delle misure adottate (4).

© RIPRODUZIONE RISERVATA