La Commissione Tecnologie Future di CTI Liguria ha organizzato lo scorso 24 settembre presso le Cisterne di Palazzo Ducale in Genova un evento dal titolo: “Intelligenze artificiali – Approcci e metodi a confronto”.

L’incontro ha visto una folta partecipazione di imprenditori e IT Manager interessati ad approfondire il tema proposto, in considerazione del fatto che la comunicazione main stream sottolinea spesso l’importanza e la straordinaria crescita dell’Intelligenza Artificiale, utilizzando questo termine in modo generale, senza alcun approfondimento sui diversi approcci che possono essere utilizzati nei diversi ambiti applicativi.

L’evento ha messo in luce alcune differenze importanti tra le tecnologie utilizzabili, confrontando tecnologie black box organizzate in ecosistemi, in cui non sempre il funzionamento degli algoritmi di risoluzione dei problemi appare chiaro, e sistemi trasparenti, in cui, invece, la tecnologia mostra l’insieme delle regole applicate.

Il primo intervento è stato tenuto dal Dottor Paolo Dell’Aversana, responsabile in Eni di sviluppo di tecnologie geofisiche innovative e Machine Learning, autore di vari brevetti, di oltre cento articoli scientifici e di sei libri, che ha mostrato l’importanza di utilizzare i diversi metodi messi a disposizione dalle tecnologie contemporanee per costruire veri e propri ecosistemi in grado di analizzare e classificare miliardi di dati provenienti dalle più disparate fonti.

Il secondo intervento è stato tenuto dall’Ingegner Marco Muselli, primo ricercatore del CNR, autore o coautore di più di 100 pubblicazioni scientifiche, cofondatore e CTO di Rulex, azienda specializzata in Explainable Artificial, che ha descritto l’approccio applicato nella sua azienda, grazie al quale il sistema è in grado di determinare autonomamente l’insieme delle regole che governano un data set.

I relatori e gli interventi

Trasformazine Digitale e Machine Learning

Paolo Dell’Aversana – Manager

La mente di homo sapiens sta sperimentando una nuova esplosiva evoluzione attraverso la sua inarrestabile “espansione artificiale”.

Ma cosa vuol dire davvero “mente artificiale”? Quali sono le effettive potenzialità del Machine Learning e delle “Deep Neural Networks”, e quali sono invece i falsi miti da sfatare? Quanto la tecnologia è in grado di emulare, riprodurre, assistere l’uomo nelle sue attività cognitive e pratiche? Quali sono le prerogative della mente naturale che non possono, al momento, essere sostituite da nessun tipo di algoritmo?

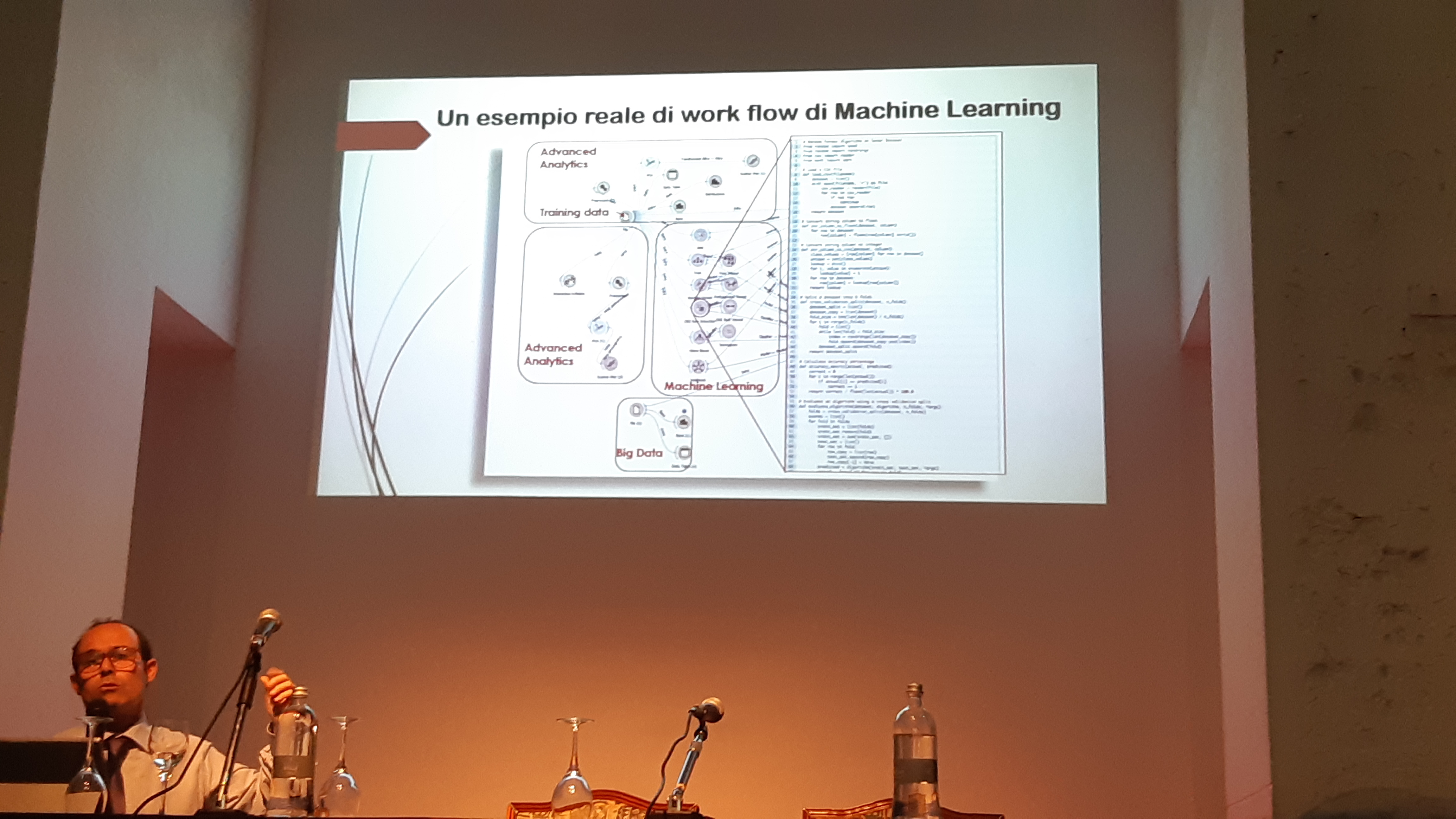

Partendo dalla sua esperienza sul campo, Paolo Dell’Aversana propone queste difficili questioni. Comincia con l’introdurre, sinteticamente, i fondamenti delle nuove tecniche di Machine Learning, soprattutto attraverso esempi concreti. Mostra come l’efficacia di queste tecniche aumenta a dismisura quando gli algoritmi di Data Science e Machine Learning vengono concatenati e integrati all’interno di un vero e proprio ecosistema di analisi e calcolo. Attraverso esempi reali, appare chiaro come non è il singolo algoritmo a risolvere difficili problemi di classificazione o di predizione, quanto piuttosto complessi work flow di librerie di calcolo collegate tra loro.

Al di là degli aspetti meramente tecnici, l’obiettivo della presentazione è soprattutto quello di contribuire al dibattito sulle relazioni complesse tra le nuove tecnologie di intelligenza artificiale e le scienze del cervello, l’epistemologia e le discipline umanistiche.

Lo scopo finale della presentazione è, quindi, proporre e condividere un nuovo modello di conoscenza, basato sul concetto di “Umanesimo Tecnologico” e di “Human-Machine Learning”. Secondo questa impostazione, la mente artificiale è importante, ma di certo non sufficiente per lo sviluppo della conoscenza. Essa rappresenta uno strumento attraverso cui potenziare abilità e attitudini che restano intrinsecamente umane.

Explainable AI: un valido aiuto per le decisioni

Marco Muselli

Negli ultimi anni si è assistito ad un’esplosione di interesse nei confronti dell’Artificial Intelligence (AI) e più specificamente del Machine Learning (ML), che persegue l’obiettivo, centrale per l’AI, di emulare il ragionamento (induttivo) proprio del cervello umano. Nonostante i risultati ottenuti grazie alle tecniche più innovative (ad es. Deep Learning) siano molto promettenti, il loro impiego nei processi decisionali è fortemente limitato dall’impossibilità di comprendere le motivazioni in base alle quali il modello (black-box) di ML effettua le sue scelte. La branca dell’explainable AI ha lo scopo di ovviare a questo problema realizzando sistemi clear-box, capaci di consentire la cooperazione tra l’uomo, che solo conosce la semantica del dato, e la macchina.

L’intervento analizza gli attuali sviluppi dell’explainable AI focalizzandosi sugli aspetti applicativi che lo rendono vantaggioso rispetto alle tecniche di AI più consolidate.

Per maggiori informazioni: [email protected]

© RIPRODUZIONE RISERVATA