Esperti, partner e clienti si ritrovano per esplorare con Amazon Web Services (Aws) le novità in ambito cloud, sull’intelligenza artificiale, e vivere gli eventi scanditi da una fitta agenda di keynote, workshop e momenti di net-working. re:Invent 2024, riesce così a catturare e a portare a Las Vegas, anche quest’anno decine di migliaia di “attendee” (oltre 60mila i presenti) che considerano l’evento un momento ideale per approfondire le proprie competenze e scoprire come sfruttare le soluzioni Aws per guidare la trasformazione digitale. La passione per la tecnologia, condivisa dagli addetti ai lavori, è centrale in tutti e cinque i giorni di lavoro.

Non per nulla, dopo la prima giornata di sessioni apre i lavori, a sera, il keynote di Peter DeSantis, senior vice president di Aws Utility Computing con un’immagine significativa: “Aws è come un albero, le cui radici profonde e interconnesse sostengono e alimentano oggi la crescita. Gli alberi più robusti mostrano tronchi e chiome straordinari, ma il vero segreto della loro forza risiede nelle radici. Queste per noi rappresentano il lavoro invisibile ma cruciale che Aws compie per sostenere le sue innovazioni”. E’ l’idea del “Wood Wide Web” e come le connessioni delle radici permettono agli alberi di condividere risorse e informazioni, così Aws costruisce infrastrutture interconnesse per i clienti. Al centro vi sono innovazione, sicurezza e performance.

E’ un attimo però e subito lo scenario tecnologico prende il sopravvento.

Aws ha compiuto un significativo viaggio nello “sviluppo del silicio”. A partire dall’evoluzione dei processori Graviton, dalla prima generazione fino all’ultima, Graviton 4. Progettati per garantire prestazioni su misura per il cloud computing. Con il sistema di hypervisoring Nitro System, l’azienda è riuscita ad eliminare i colli di bottiglia della virtualizzazione tradizionale e introdurre un nuovo paradigma di sicurezza. Grazie alla verifica crittografica e alla protezione hardware integrata, Nitro consente oggi ai clienti di Aws di operare su infrastrutture affidabili.

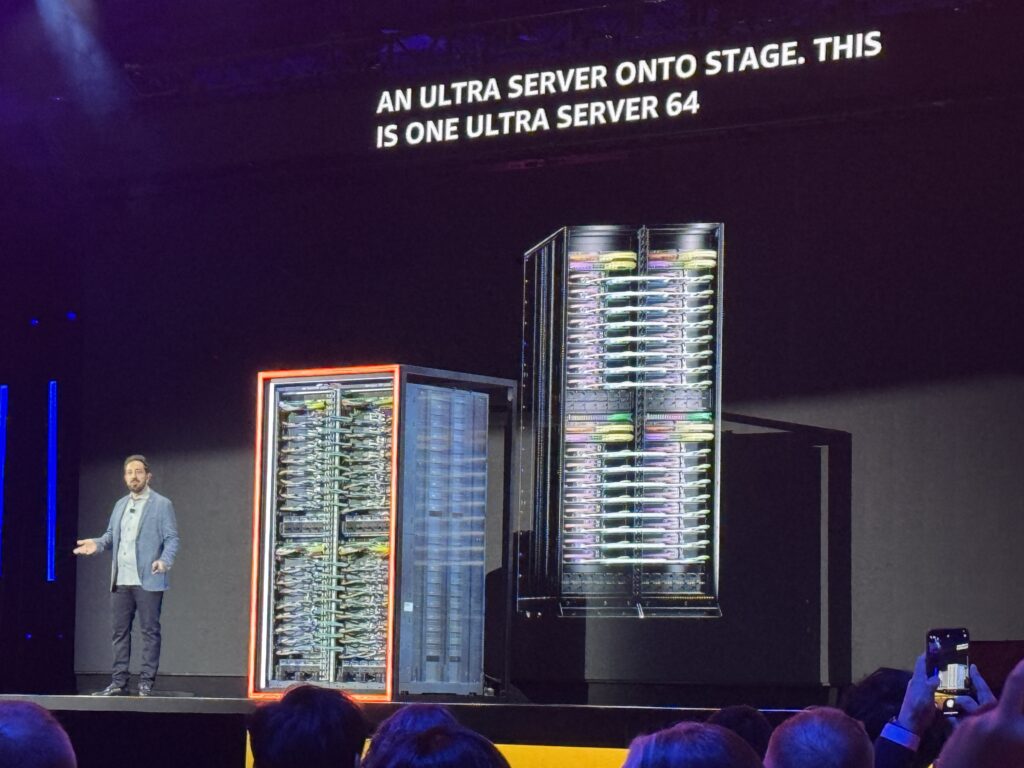

Per l’intelligenza artificiale l’azienda ha deciso di lavorare su due binari di sfide infrastrutturali: la necessità di costruire sistemi di calcolo sempre più potenti, come Trainium 2, ottimizzato per gestire carichi di lavoro AI intensivi ed il bisogno di creare cluster interconnessi, ma anche la capacità di combinare innovazioni hardware, come i pacchetti di chip avanzati, con soluzioni di rete come NeuronLink a latenza ultra-bassa, per garantire le prestazioni necessarie anche ai modelli AI più esigenti. Da qui la “nascita” di Aws Trainium2 UltraServer, ovvero un sistema di due rack, quattro server e 64 acceleratori Trainium2 collegati insieme.

A valle di questa evoluzione infrastrutturale ecco l’idea allora di progetto Rainier come “ultra-cluster” per l’AI del futuro. Alla base l’utilizzo massivo di Trainium 2 e collaborazioni accademiche strategiche come quella con UC Berkeley e Oxford per esplorare nuove frontiere dell’AI e l’integrazione con il cloud.

Il tema di una base infrastrutturale adeguata per cloud e AI deve però essere coniugato con quello dell’efficienza. Per questo Aws propone una serie di novità relative anche a nuove componenti per data center progettate per sostenere la prossima generazione di innovazione nell’intelligenza artificiale e rispondere alle esigenze in evoluzione dei clienti.

Queste innovazioni, combinano progressi nel design hardware, avanzamenti nel design elettrico, nei sistemi di raffreddamento e nella distribuzione dell’energia e sono progettate per soddisfare la crescente domanda di potenza di calcolo derivante dall’uso di AI generativa. Grazie a un incremento della densità di potenza nei rack, Aws prevede quindi di aumentare di sei volte la densità nei prossimi due anni. Questa flessibilità consente di ottimizzare l’energia utilizzata e ridurre il numero di data center necessari per le operazioni. Si parla di implementazioni che riguarderanno i data center Aws in tutto il mondo, quindi per oltre 34 regioni e 108 zone di disponibilità, a partire dai DC negli Stati Uniti nel 2025.

Aws e i pilastri della proposta

Spetta però a Matt Garman, Ceo di Aws, in Day 2 – per il manager primo keynote a re:Invent – innestare la proposizione evoluta nell’ambito del computing nella dinamica dell’offerta di servizi di piattaforma, sulla base di ulteriori annunci. L’approccio si basa su un modello “building block”. E su una proposta che fa delle esigenze dell’ecosistema la ragione dello sviluppo. Computing e storage (protagonisti anche nel primo keynote), database, inference, GenAI Experience sono i building block principali entro cui si snodano gli annunci della mattina. Tanti, fitti.

Per questo vogliamo fare riferimento a quelli a nostro avviso più interessanti. Aws in particolare lavora per ridefinire lo standard del settore tecnologico combinando “ascolto del mercato, innovazione tecnologica e attenzione alla sicurezza”, spiega Garman. Dalla comunità globale di sviluppatori ai processori personalizzati e alle piattaforme AI all’avanguardia, vuole “essere un partner indispensabile per le aziende di ogni dimensione e con lo sguardo al futuro, l’azienda vuole plasmare il panorama tecnologico per gli anni a venire”.

Se per quanto riguarda il computing con le P6 Instances per i nuovi chip Nvidia Blackwell, si vuole offrire un incremento di performance fino a 2,5 volte rispetto alla generazione precedente, ideali per applicazioni AI generativa, ma arrivano anche le istanze di nuova generazione basate su Trainium 2 per EC2, e attraverso lo sviluppo del Trainium 3, annunciato nel keynote e previsto per il 2025, si arriverà a una capacità di calcolo doppia rispetto a Trainium 2.

Il paradigma dello storage già trasformato con l’introduzione di Amazon S3 nel 2006. Oggi, S3 gestisce oltre 400 trilioni di oggetti, garantendo scalabilità e affidabilità. Ora con i buckets Amazon S3 Table si migliorano le prestazioni delle tabelle Iceberg, triplicando la velocità di query e incrementando di 10 volte le transazioni al secondo, mentre S3 Metadata è proposto come sistema che aggiorna automaticamente i metadati degli oggetti, semplificando la gestione dei dati su larga scala. Lato DB Aws prosegue nella mission di migliorare l’esperienza di gestione dei database, introducendo soluzioni innovative come Aurora Dsql come database Sql distribuito che offre scalabilità illimitata multi-region, latenza minima e gestione serverless e DynamoDB per estendere alte prestazioni anche per le applicazioni NoSQL critiche. Si tratta di aggiornamenti che costituiscono un passo avanti nell’ottimizzazione delle applicazioni moderne, rispondendo alle esigenze di scalabilità e bassa latenza.

L’intelligenza artificiale è destinata a diventare una componente essenziale di qualsiasi applicazione (Inference). E Aws risponde a questa esigenza con le evoluzioni legate ad Amazon Bedrock, piattaforma che semplifica l’integrazione dell’AI generativa in applicazioni di produzione. Le innovazioni chiave includono Model Distillation che permette di ridurre i costi e migliorare le prestazioni dei modelli AI grazie alla distillazione automatizzata e Automated Reasoning Checks: uno strumento unico che verifica l’accuratezza delle risposte dei modelli, evitando errori dovuti a allucinazioni. “Aws in questo senso punta a fare in modo che l’AI generativa sia implementata in modo sicuro ed efficiente, trasformando ogni workflow aziendale”.

Ancora, lato sviluppo, sempre nell’ambito delle proposte AI, l’evoluzione di Amazon Q Developer oggi punta su tre aspetti centrali: l’automazione dei test quindi una funzionalità che consente di generare automaticamente test unitari, riducendo il carico di lavoro manuale, ma anche la trasformazione del codice con strumenti per migrare rapidamente applicazioni legacy, come le trasformazioni .Net verso Linux e la modernizzazione delle applicazioni Vmware e di quelle dei mainframe, accelerando i processi di migrazione, mentre in Amazon Q Business vengono innestate funzionalità in grado di sfruttare l’AI generativa per automatizzare processi complessi, aumentando la resilienza dei flussi di lavoro aziendali.

Un ulteriore punto a nostro avviso importante proprio in relazione anche a Amazon Bedrock è la nuova evoluzione di Amazon Sagemaker, un punto di svolta nell’analisi dei dati. Sagemaker Unified Studio in un’unica piattaforma combina strumenti di analisi e machine learning, semplificando la collaborazione tra team, ma arriva anche la possibilità di eliminare parzialmente le pipeline di dati permettendo analisi dirette dai sistemi operativi e dai data lake. Ci piace indugiare sui rapporti tra le due proposte che negli anni abbiamo visto in continua evoluzione. E per farlo attingiamo al contributo di Swami Sivasubrabamian, VP AI and data di Aws, che nel suo keynote (in Day3) spiega che Amazon Bedrock è ideale per sviluppatori e aziende che desiderano integrare rapidamente capacità AI nelle loro applicazioni utilizzando modelli pre-addestrati.

Offre un servizio completamente gestito che supporta modelli fondamentali popolari, tra cui quelli di Anthropic, Cohere, AI21 Labs, Meta, Mistral AI, Stable Diffusion XL e Amazon Titan. Bedrock fornisce un accesso unificato tramite Api a questi modelli, permettendo l’aggiornamento a versioni più recenti con modifiche minime al codice. Inoltre, supporta la personalizzazione dei modelli attraverso il fine-tuning e l’importazione di modelli personalizzati, rendendolo adatto a chi ha competenze limitate nel ML ma necessita di soluzioni AI efficaci.

Amazon SageMaker, invece, è destinato a data scientist, ingegneri del machine learning e sviluppatori con una conoscenza approfondita del ML. È un servizio completamente gestito che consente di costruire, addestrare e distribuire modelli ML su larga scala, offrendo strumenti come notebook, debugger, profiler, pipeline e MLOps. SageMaker fornisce un ambiente di sviluppo integrato per creare modelli personalizzati e offre accesso a centinaia di modelli pre-addestrati, inclusi quelli pubblicamente disponibili.

È particolarmente utile quando sono necessarie personalizzazioni estese e un controllo dettagliato sull’architettura e il processo di addestramento del modello. In sintesi, Amazon Bedrock è più adatto per l’integrazione rapida di funzionalità AI tramite modelli pre-addestrati con personalizzazione limitata, mentre Amazon Sagemaker offre una piattaforma completa per lo sviluppo e la distribuzione di modelli ML personalizzati, richiedendo una maggiore competenza nel machine learning.

Ruba infine la scena a Garman, e sale sul palco, Andy Jassy, presidente e Ceo di Amazon per catturare l’attenzione sull’annuncio clou della giornata. Amazon Nova. Nova è una nuova generazione di foundation model all’avanguardia che offre intelligenza di frontiera per Amazon Bedrock. Amazon Nova include tre modelli di comprensione e due di generazione di contenuti creativi. Questi modelli, esclusivamente disponibili su Amazon Bedrock, promettono di offrire un’intelligenza avanzata unita a prestazioni che rimodulano il rapporto in termini di costo ed efficienza.

Grazie a Amazon Nova, sarà possibile abbattere i costi e ridurre la latenza in quasi tutte le applicazioni di intelligenza artificiale generativa. Dalla comprensione di documenti complessi e video all’analisi di grafici e diagrammi, fino alla creazione di contenuti multimediali coinvolgenti e alla costruzione di agenti intelligenti avanzati, Amazon Nova nasce quindi per rappresentare una piattaforma versatile e ottimizzata per le esigenze aziendali. I modelli Amazon Nova previsti al momento sono Amazon Nova Micro, modello text-to-text veloce; Amazon Nova Lite, Amazon Nova Pro e Amazon Nova Premier come modelli multimodali in grado di elaborare testo, immagini e video e ri-generare testo (è possibile, per esempio, chiedere all’AI la descrizione di un video ed ottenere come output un testo che racconta cosa accade nella scena). Ma Amazon ha anche lanciato due modelli aggiuntivi: Amazon Nova Canvas che genera immagini di qualità da studio e Amazon Nova Reel che dà origine a video di qualità da studio. In arrivo per il 2025 Amazon Nova speech-to-speech. Il modello è progettato per trasformare le applicazioni AI conversazionali comprendendo l’input vocale in streaming in linguaggio naturale, interpretando segnali verbali e non verbali (come tono e cadenza) e offrendo interazioni naturali simili a quelle umane, avanti e indietro con bassa latenza.

© RIPRODUZIONE RISERVATA