L’espansione degli ambienti multicloud, l’adozione di architetture distribuite e la pressione dei bord sull’ottimizzazione delle risorse e dei costi hanno portato i team IT, ed in particolare i Cio, ad esprimere il bisogno di evolvere le modalità di governance dei sistemi. Tra le modalità di gestione ancora poco esplorate, ma dal potenziale trasformativo si fa strada in questo contesto l’approccio PromptOps che promette un cambio di passo nelle possibilità di interazione dei professionisti IT con i sistemi operativi, sfruttando il potenziale dell’intelligenza artificiale generativa e conversazionale.

Non si parla tanto o solo di una tecnologia promettente quanto piuttosto di un modello operativo che permette di ridurre le barriere tecniche all’automazione, incrementare l’efficienza operativa dei team e democratizzare l’accesso ai processi IT complessi. In un contesto in cui è fondamentale attrarre talenti con competenze ibride e accelerare il rilascio di servizi digitali, la possibilità di “parlare” con l’infrastruttura attraverso il linguaggio naturale rappresenta, è facile intuirlo, una leva competitiva vantaggiosa.

PromptOps, cos’è e quali sono i vantaggi

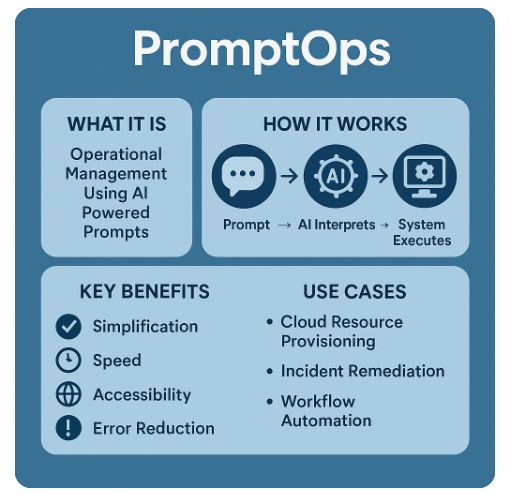

Con il termine PromptOps si intende l’uso dell’intelligenza artificiale generativa — in particolare dei modelli linguistici avanzati — per gestire operazioni IT tramite comandi in linguaggio naturale. Non si tratta di semplici chatbot o assistenti vocali, ma di veri e propri sistemi intelligenti in grado di comprendere, tradurre e attuare istruzioni operative anche complesse. Il cambiamento è sostanziale. Se fino ad oggi la gestione di una risorsa cloud, la configurazione di una rete o il rilascio di una pipeline CI/CD hanno richiesto skill tecnici avanzati, oggi questi task possono essere descritti con frasi molto semplici come: “Crea un cluster Kubernetes con replica automatica su tre zone” oppure “Monitora il traffico sulla rete est-ovest e segnala le anomalie di latenza superiori a 200 ms”, lasciando all’AI interpretare, validare, orchestrare e in alcuni casi anche ottimizzare il comando. Il valore per i team IT è triplice. Primo, l’accessibilità: non serve più conoscere ogni dettaglio della sintassi a linea di comando o delle Api dei vari provider. Secondo, la velocità: i tempi di esecuzione operativa si riducono sensibilmente. Terzo, la standardizzazione: i prompt possono essere riutilizzati, condivisi, versionati e adattati in modo coerente tra i team.

I trend

Nonostante si trovi ancora in una fase di adozione iniziale, PromptOps è già oggetto di crescente attenzione da parte degli analisti. L’intelligenza artificiale conversazionale applicata alle operations IT si colloca all’interno di un trend più ampio che, in particolare, cattura l’attenzione proprio di Cio e responsabili infrastrutturali. Gartner, nel report Emerging Tech Impact Radar: Artificial Intelligence (2024), evidenzia come le AI-powered conversational interfaces siano considerate una delle tecnologie emergenti a medio termine (entro 3-5 anni) in grado di cambiare il modo anche in cui i team IT interagiscono con le infrastrutture operative. Nello stesso studio, Gartner stima anche che entro il 2026 oltre il 30% dei team IT adotterà interfacce conversazionali basate su AI per la gestione di operazioni complesse, soprattutto in ambienti cloud-native e DevOps. Idc, nel report Future of Digital Infrastructure (2024) prevede che entro il 2027 circa il 40% delle aziende globali integrerà sistemi di automazione guidati da AI nei propri flussi di gestione IT, incluse modalità operative basate su linguaggio naturale. La crescita di soluzioni AIOps evolute che incorporano capacità conversazionali (entro cui si colloca il trend PromptOps) è stimata con un Cagr superiore al 30% nel quinquennio 2023-2028, guidata dalla necessità di ridurre la complessità operativa e migliorare la resilienza dei sistemi. E infine Forrester, nel suo Predictions 2025: AI Drives a New Era of Productivity, evidenzia che l’utilizzo di AI conversazionale non si limiterà alle funzioni customer-facing, ma si estenderà rapidamente alle funzioni interne di gestione IT, contribuendo a una maggiore efficienza operativa e a un’accelerazione nella delivery dei servizi digitali. Forrester prevede che entro il 2027 il 25% delle operazioni quotidiane nei cloud pubblici sarà avviato o supportato tramite interfacce conversazionali intelligenti.

Guardando al futuro, il trend atteso è quindi quello di una progressiva integrazione di PromptOps non solo nei contesti cloud-native, ma anche nelle operations ibride e legacy. Tornano al riguardo le stime di Gartner secondo cui, entro il 2028, le piattaforme di gestione multicloud di nuova generazione incorporeranno nativamente assistenti AI conversazionali, e si prevede che le capacità di orchestrazione tramite prompt diventeranno uno standard competitivo nei principali cloud provider. In prospettiva, la gestione conversazionale promette di spostare l’interazione IT verso modelli sempre più naturali, adattivi e accessibili, riducendo la distanza tra intenzione umana e esecuzione tecnica.

PromptOps, gli attori del mercato

Sebbene il concetto di PromptOps sia ancora in fase embrionale, diversi player tecnologici stanno lavorando su componenti e piattaforme che costituiscono le basi per una gestione operativa conversazionale dell’IT. Aws ha introdotto Amazon Q, il suo assistente AI generativo per ambienti Aws, annunciato nel 2023 e ampliato nel 2024. Amazon Q consente già di interagire in linguaggio naturale per attività come la configurazione di servizi cloud, la ricerca di documentazione tecnica o il supporto nel troubleshooting. Sebbene non sia ancora possibile parlare di un sistema PromptOps strutturato, rappresenta un passo concreto verso la possibilità di orchestrare ambienti cloud complessi tramite comandi conversazionali. Tra gli hyperscaler pure Microsoft, con Copilot, ha già integrato funzionalità di supporto AI-based direttamente all’interno di Azure Portal. Azure Copilot aiuta gli utenti a configurare ambienti, creare risorse e monitorare carichi di lavoro cloud utilizzando richieste in linguaggio naturale. Le funzionalità conversazionali sono in fase di rapida espansione, ma una gestione operativa completamente orchestrabile via prompt è attesa solo nei prossimi cicli di aggiornamento. Google Cloud, con Vertex AI Search and Conversation, ha avviato a sua volta sperimentazioni che prevedono l’uso di AI generativa per semplificare la gestione di risorse di machine learning e applicazioni cloud. Anche in questo caso, le capacità attuali sono più focalizzate sull’ambito MLops che sulle operation IT generaliste, ma il percorso evolutivo punta chiaramente verso una maggiore estensione delle interfacce conversazionali all’intero ecosistema cloud.

Sul fronte Infrastructure as Code, Pulumi ha invece già introdotto Pulumi AI come piattaforma in beta che permette di generare automaticamente codici di infrastruttura cloud descrivendo gli obiettivi in linguaggio naturale.

È uno degli esempi più concreti di adozione reale del paradigma PromptOps, seppur oggi limitato alla fase di creazione dell’infrastruttura e non ancora esteso alla gestione operativa continua. E così anche HashiCorp, conosciuta per strumenti come Terraform e Consul, ha avviato collaborazioni tecnologiche con OpenAI e sta esplorando l’integrazione di funzionalità AI conversazionali nei propri strumenti. Tuttavia non sono ancora disponibili soluzioni commerciali pienamente operative basate su prompt AI, anche se roadmap interne prevedono i primi prototipi tra fine 2025 e il 2026.

Infine l’analisi del mercato richiede di evidenziare realtà giovani e agili come Humanitec e Relay.app che stanno lavorando per semplificare l’automazione delle operation tramite interfacce user-friendly e moduli AI-assistiti, oppure attraverso lo sviluppo di vere e proprie piattaforme dedicate, come quella proposta da MechCloud. Sebbene al momento non si possa parlare di vere e proprie soluzioni nativamente conversazionali, il loro approccio modulare e orientato alla semplificazione rende queste proposte candidati naturali alla prima proposizione di modelli PromptOps nel medio termine. L’ecosistema si sta quindi preparando a integrare le funzionalità di gestione conversazionale nei prossimi due o tre anni, seguendo una roadmap che va dall’assistenza generativa al comando operativo diretto.

I casi d’uso

La tecnologia PromptOps, abbiamo visto, è ancora in fase di sviluppo, ma alcune implementazioni sono già osservabili in ambienti aziendali, pur solo in fase sperimentale. Come spesso accade nei progetti basati sull’AI sono proprio le aziende che propongono le tecnologie a contribuire a tratteggiare i casi di utilizzo nei progetti. Per esempio, Aws attraverso il suo assistente AI Amazon Q, sta progressivamente integrando capacità conversazionali per supportare il provisioning e la gestione di ambienti cloud. Sebbene non si possa parlare di un utilizzo interno sistematico di tutti i paradigmi PromptOps, diverse demo (cui abbiamo assistito, per esempio in occasione di Re:Invent 2024) e programmi pilota suggeriscono che i team tecnici stanno esplorando modalità operative di questo tipo sempre più basate su linguaggio naturale. Anche Microsoft, con Copilot, ha avviato programmi di adozione con l’obiettivo di semplificare le operazioni cloud attraverso richieste conversazionali, riducendo tempi e complessità nella gestione delle risorse Azure. Un esempio del tutto concreto arriva poi da una delle aziende più giovani citate che con Pulumi AI, già in fase beta, consente ai team di descrivere in linguaggio naturale infrastrutture cloud da creare. E non mancano le startup cloud-native che sperimentano l’uso di Pulumi AI per accelerare il provisioning senza la necessità di scrivere manualmente codice Infrastructure-as-Code, segnando uno dei primi casi pratici di automazione operativa basata su prompt AI.

Prospettive e orizzonti temporali

Il percorso verso una diffusione ampia di PromptOps è iniziato e, secondo la roadmap tracciata da analisti e vendor, è in questo biennio che assisteremo a una crescente integrazione di prompt AI nelle principali piattaforme di gestione cloud e DevOps. Soprattutto è importante notare che l’approccio PromptOps sarà adottato da organizzazioni con forte orientamento all’automazione, e già entro il 2027 si prevede una standardizzazione delle Api di interpretazione linguistica, che renderà il modello più robusto e interoperabile. Sarà nel 2028 che ci si potrà attendere l’estensione di PromptOps anche agli ambienti legacy e ibridi, dove i vantaggi di una gestione conversazionale potranno incidere in modo significativo sulla modernizzazione.

Infine, entro il 2030, si stima che anche le medie imprese adotteranno interfacce PromptOps, spinte da esigenze di semplificazione e mancanza di competenze tecniche interne. Sul fronte evolutivo, si lavorerà in particolare sull’auditability dei prompt — ovvero la possibilità di tracciare chi ha dato quali istruzioni e quando —, sull’ottimizzazione automatica dei comandi (AI che migliora i prompt per massimizzare l’efficacia) e sull’integrazione con framework normativi e di governance IT.

© RIPRODUZIONE RISERVATA