Il valore dei dati è oggi riconosciuto dalle aziende di ogni verticale, indipendentemente dalle dimensioni e dal comparto. Per indirizzare le scelte di business anche la piccola azienda italiana ha bisogno di conoscere a fondo i clienti, le performance delle proprie iniziative, la reale efficienza di supply chain e processi. Più difficile è capire cosa sia necessario fare per proteggere le informazioni, per trattarle nel modo corretto, per valorizzarle. Anche perché oggi le infrastrutture digitali con cui “si opera” con i dati non sono più monolitiche, ma diffuse. Ed il cloud, in questo senso, ha contribuito a rendere più complesse le operazioni, anche se più produttive, perché allo stesso tempo frammenta la gestione del dato, rendendone più difficoltosa la protezione. Non è un caso se i “data day” si sono moltiplicati, tanto che solo nei primi tre mesi di quest’anno abbiamo già celebrato il 28 gennaio il Privacy/Protection Day, un Open Data Day il 4 marzo e ora a fine marzo cade il World Backup Day.

Dati da conoscere, per valorizzarli, ma dati da proteggere quindi. Come evidenziano i ricercatori Clusit ed emerge anche dal Barometro Cybersecurity di NetConsulting cube gli attacchi oggi prendono di mira le aziende in modo trasversale con più facilità quando le organizzazioni sono meno strutturate e più impreparate a far fronte ad emergenze cyber, per scarsa consapevolezza o mancanza di risorse. Con le tematiche di disaster recovery e di business continuity su cui, finalmente, si sta focalizzando l’attenzione.

Vogliamo ricordare che oltre agli attacchi malware e al ransomware, la perdita dei dati può essere banalmente causata da guasti hardware, corruzione del software, cancellazione accidentale, disastri naturali, come un allagamento o un incendio, ma si possono perdere dati anche semplicemente per “esfiltrazione“ da parte dei dipendenti, come per azioni di spionaggio, mentre la regolamentazione vigente – soprattutto quando i dati non riguardano solo l’azienda, ma anche clienti e persone (e quindi si parla di dati sensibili) – richiede ad ogni organizzazione di “essere in grado di rendere conto oltre che del trattamento del dato, anche di dove si trova quel dato e chi ne ha accesso”.

Backup Day, lo scenario

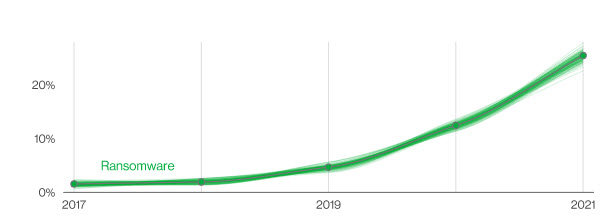

Per questi motivi World Backup Day 2023 rappresenta un’opportunità per adottare un approccio più pragmatico ai consigli e ripensare le best practice per ridurre al minimo il rischio, proteggere i dati e trasformarli in analytics utili. Lo evidenziano anche i numeri di Veeam. Il suo Ransomware Trends Report 2022 indica che “la maggior parte (85%) delle aziende ha subito almeno un attacco ransomware nell’ultimo anno”, mentre il Barometro NetConsulting cube rileva che “il 33% delle aziende ha rilevato un incremento degli attacchi ransomware nel corso del 2022”. Interessanti numeri di Verizon (fonte: Data Breach Investigations Report, Dbir, 2022) aggiungono a questi rilievi che “gli attacchi di questo tipo sono aumentati con una crescita maggiore rispetto agli ultimi 5 anni messi insieme: il 40% degli incidenti ransomware coinvolge l’uso di software di condivisione del desktop, mentre il 35% è legato all’email”. Seguono applicazioni Web (15%) e l’installazione diretta del virus sul proprio device da parte dell’utente (8%). Per questo, oltre al backup, l’adozione di politiche di patching, filtri e asset management, non solo a livello locale, ma proprio a livello infrastrutturale per prevenire le vulnerabilità, si rivela essenziale.

Le 5 criticità sfruttate dagli hacker

Contesti specifici e modalità di utilizzo dei dati non correttamente monitorate favoriscono l’attività degli hacker. Per esempio, Barracuda Networks ne evidenzia come particolarmente critici cinque. Il primo riguarda il numero di persone che possono accedere a set e software di backup, più alto è questo numero, maggiore anche il rischio che gli aggressori usino credenziali rubate sfruttando elevati privilegi amministrativi per infiltrarsi (1). Ma anche la mancata segmentazione della rete rappresenta un evidente aiuto, perché favorisce i movimenti laterali. Così, a partire dall’endpoint compromesso, chi attacca può per individuare e ottenere l’accesso al software di backup e infine disattivare, rimuovere o eliminare i file salvati (2). E negli accessi da remoto ai backup disponibili – per esempio i set di dati in cloud – un approccio poco rigoroso all’autenticazione delle password espone i sistemi protetti nel caso in cui le credenziali vengano rubate o scoperte (3). Ultime due modalità “preferite”: sfruttare la scarsa frequenza dei backup, per cui in caso di necessità improvvisa di ripristino si dispone solo di copie “antiche”, mentre chi attacca si ritrova con la disponibilità di dati freschi (4) ed ancora, se chi attacca è consapevole delle strategie di backup aziendale, ed ha svolto una buona attività di espionage prima dell’attacco, può più facilmente costringere l’azienda a dover scendere a compromessi per tornare operativa dopo un attacco, proprio contando sulla scarsa esperienza dell’organizzazione nelle capacità di ripristino (5).

4 principi chiave per la protezione del dato

Dal punto di vista squisitamente tecnologico, cloud e applicazioni native in cloud e containerizzate hanno contributo alla crescita dello storage ad oggetti per scalabilità, durevolezza e disponibilità. Per questo alcuni dei principi chiave del backup file storage devono oggi essere presi in considerazione anche per l’object storage.

Senza dubbio il primo di questi è il tema dell’immutabilità del dato (1). Caro a diversi vendor (per esempio Cohesity), ma non ancora indirizzato da tutte le proposte. Si tratta di poter disporre di strumenti per memorizzare i dati senza sovrascrivere i vecchi elementi quando sono disponibili nuove informazioni e quindi di sfruttare diverse tecniche per preservare i valori storici e attuali dei dati (immutabilità del backup), per esempio a fini di auditing e di debug. E’ necessario, in senso più ampio, dotarsi quindi di un piano completo per la continuità operativa (2), tenerlo aggiornato, lasciarlo evolvere e crescere con le esigenze dell’organizzazione. Serve quindi implementare un piano di disaster recovery “esteso” nel senso di definire procedure e modalità di recupero puntuali comprensive di tutti gli asset/dati ovunque essi siano e oggi si presume che questo sia possibile farlo solo sfruttando le potenzialità del cloud (3). Serve in ultimo, ma mandatorio, per non vanificare tutto il lavoro sino a questo punto compiuto, dimostrare di essere davvero in grado di tornare operativi con i backup disponibili (4). Un “momento” quest’ultimo, delicato tanto e forse anche più del backup stesso.

Il riferimento ai vantaggi del cloud in relazione ad una strategia di backup efficiente non è secondario. Come spiega Vem Sistemi, da una parte “machine Learning e intelligenza artificiale permettono, a monte, di ridurre gli impatti di un attacco e di accelerare i tempi di ripristino del servizio”. Ma a valle serve “prevedere la conservazione delle copie di backup su una soluzione con file system immutabile, che lavori in modalità append-only e che non esponga protocolli di rete aperti”. Serve sfruttare sistemi di multi-factor authentication, per poter garantire solo gli accessi sicuri al dato, e preservare poi i dati in storage, appunto, immutabili e isolati.

E da questo punto di vista il mercato è già in grado di offrire modalità di air-gapping per l’object storage sia ibride sia SaaS. Nel primo caso quindi si parla di storage ad oggetti on-premise che possa scalare infinitamente in termini di spazio/performance, e verso il public cloud, ma mantenendo il controllo dei dati su tutto lo stack, mentre la modalità solo cloud prevede l’utilizzo di servizi SaaS, con il sistema SaaS però in grado di isolarsi, realizzando di fatto un air gap logico che non espone dati se non al solo sistema di backup durante la fase di archiviazione.

La regola del 3-2-1, si può fare di più?

La regola del 3-2-1 resta il principio base per la gestione dei dati. In estrema sintesi, prevede la presenza di 3 (o più) copie dei dati su 2 (o più) supporti diversi, di cui almeno una copia del tutto isolata, off-site. La regola come si vede, non indica una specifica tecnologia hardware ma proprio per questo si adatta a tutti gli scenari. Chiaramente i supporti meno capienti come dischi fissi on-premise e unità ottiche da soli oggi non riescono più a soddisfare in tanti casi nemmeno l’utenza privata che ha imparato a ricorrere ai servizi cloud (Dropbox e le risorse offerte degli hyperscaler Google, Microsoft, Aws (soprattutto con S3), etc.). Le aziende dovrebbero invece preferire un approccio ibrido al backup e al ripristino con Sla garantiti, e sistemi di protezione a 360 gradi per il controllo su accesso ai dati e tempi di ripristino. Non solo, il modello 3-2-1 potrebbe non essere più sufficiente.

Articolare ulteriormente la strategia anche su questo punto, sfruttando il cloud, sarà un ulteriore vantaggio. Per esempio si può decidere di tenere due copie aggiuntive su dispositivi di archiviazione diversi online e due copie off-site. Ma le sfide ransomware portano anche a valutare la necessaria dislocazione geografica necessaria. Acronis per questo fa riferimento agli approcci 3-2-1-1-0 e 4-3-2. Li spieghiamo. Il primo mette in evidenza proprio l’idea di una copia offline (air-gapped). Può trattarsi di una copia su nastro per i dati più freddi ma anche di storage immutabile nel cloud. L’approccio 4-3-2, prevede addirittura la disponibilità di quattro copie di dati archiviati in tre sedi. La prima è in sede, la seconda presso un managed service provider e la terza presso un provider di cloud storage. L’idea, in questo senso è di disporre di due copie in due sedi esterne alla propria, garantendo una maggiore protezione dei dati contro disastri e attacchi mirati.

© RIPRODUZIONE RISERVATA

Immagine di svstudioart

Immagine di svstudioart