Red Hat ha ufficializzato gli accordi con Amd, Intel e Nvidia tutti all’insegna dell’intelligenza artificiale, a valle dell’evento mondiale di inizio maggio – Red Hat Summit, a Denver – che delinea roadmap e partnership a livello globale.

Le tre aziende di chip, ognuna con la propria offerta, collaboreranno con Red Hat per definire soluzioni AI per le imprese, dal momento che le Gpu Amd, gli acceleratori Intel Gaudi AI e i microservizi della piattaforma Nvidia AI Enterprise potenzieranno le applicazioni aziendali su Red Hat OpenShift AI, riducendo le barriere all’ingresso per le imprese che desiderano integrare carichi di lavoro AI.

Le tre partnership permetteranno di fornire potenza di elaborazione e prestazioni, gestendo la complessità dell’adozione dell’intelligenza artificiale nel cloud ibrido che Red Hat sposa da sempre, per orchestrare carichi di lavoro AI ovunque sia necessario, dal data center all’edge.

Ma accelerare il viaggio verso l’AI nelle aziende non è banale.

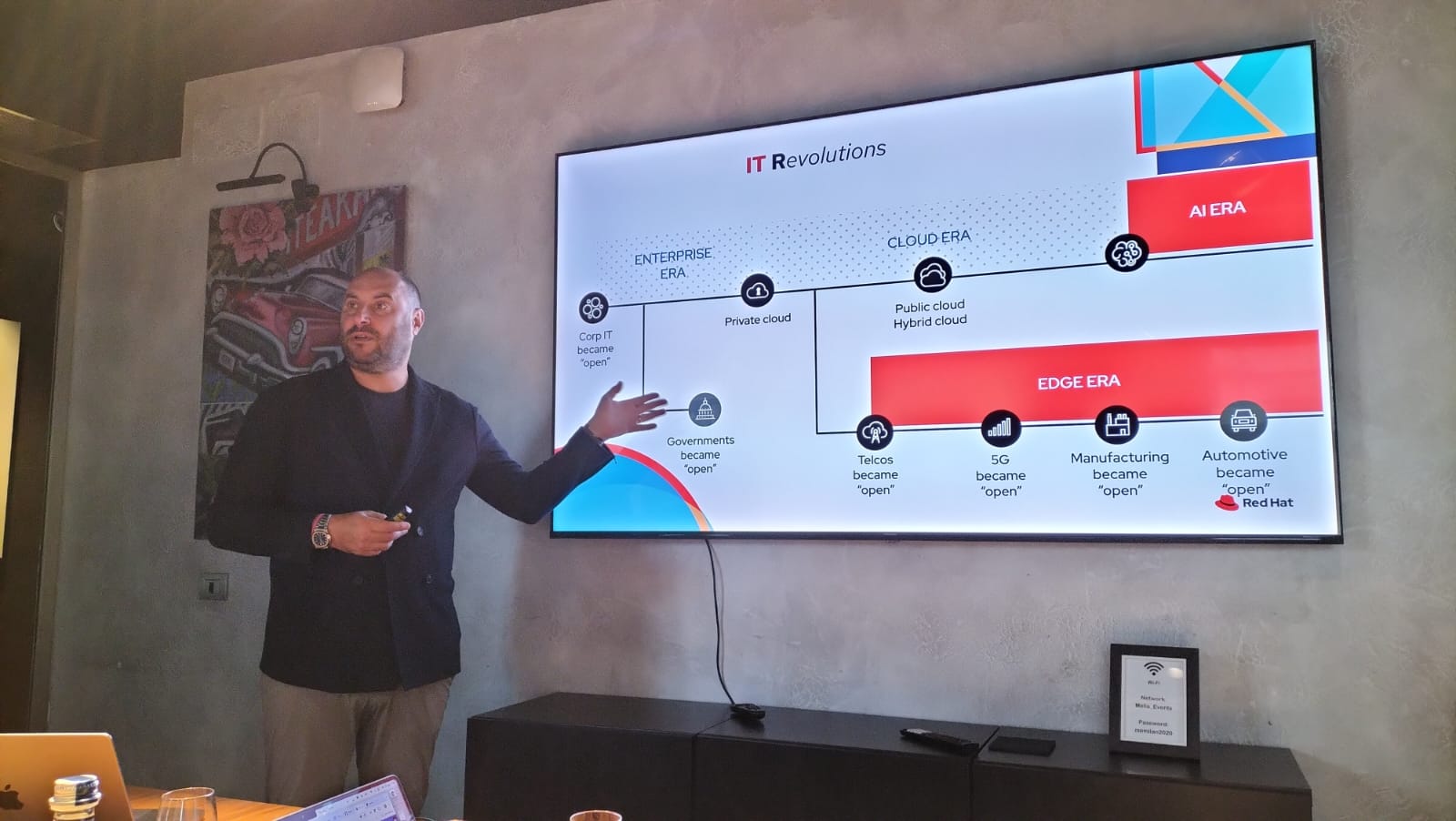

E’ il punto di arrivo di una percorso che Gianni Anguilletti, vice president Med region di Red Hat, analizza partendo dall’evoluzione continua indotta dalla tecnologia.

Ricorda la pervasività del software (citando l’espressione coniata da Marc Andreessen, co-fondatore di Netscape, “il software si sta mangiando il mondo”), l’affermarsi del modello open source (riformulando la frase “il software open source si sta mangiando il mondo”) fino all’accelerata impressa dalla pandemia e dalla necessità di protezione dei dati. “Ci siamo trovati tutti insieme catapultati nell’era del cloud. Aveva ragione il nostro storico Ceo, Paul Cormier (ritiratosi ad aprile dopo 24 anni in Red Hat, Ndr) nell’affermare: every Cio is a cloud operator. E oggi siamo nell’era dell’AI, un trend confermato dal molte ricerche”.

Strategia duale

L’82% delle aziende prevede di aumentare il workload AI nei prossimi 2 anni, il 65% sta già investendo in AI, a tal punto che il 40% delle aziende Fortune 2000 sta allocando fondi significativi da qui al 2025, nonostante il 52% riconosca una mancanza di tool adeguati. Il mercato dell’intelligenza artificiale crescerà sfiorando gli 800 miliardi di dollari entro il 2026, con crescita del 18% anno su anno, secondo Idc.

In questo scenario la strategia di Red Hat è “duale, simmetrica”, precisa Anguilletti.

Da una parte mira a rafforzare la proposizione corrente in termini di servizi e tecnologia, dall’altra parallelamente vuole fornire ai clienti metodologie, nuove best practice, per sviluppare applicazioni AI enabled o AI powered, in modo tale che si possa ridurre al massimo il tempo tra la fase di sperimentazione e l’effettivo utilizzo delle applicazioni di intelligenza artificiale.

L’offerta tecnologia si basa su un framework per lo sviluppo di applicazioni cloud native (AI, ML, microservizi, container, serveless computing, edge computing) e su strumenti per l’automazione di infrastrutture informatiche che possono rendere le applicazioni più affidabili grazie all’integrazione di algoritmi di AI.

Le best practice, invece, poggiano su modelli di AI che serviranno alle aziende per impostare il loro viaggio verso l’AI. “E rilevante sottolineare come il nostro Cto, Chris Wright, preveda che entro tre anni il 50% del mondo IT sarà governato da applicazioni e il restante 50% da modelli di AI. Dobbiamo fare in modo che le piattaforme che rilasciamo ai nostri partner e clienti siano in grado di sfruttare questi modelli. Per questo, volendo predicare bene e razzolare bene, stiamo iniettando AI nella famiglia di prodotti e tecnologie che rilasciamo ai nostri clienti”.

E incalza Anguilletti: “Così come il cloud è ibrido e aperto, lo stesso deve valere per l’AI che deve essere ibrida e aperta. Da qui lo sforzo per rendere open source i modelli: in questo ambito andremo a ripetere ciò che è stato realizzato negli ultimi 30 anni nel mondo dello sviluppo applicativo facendo leva sulla collaborazione con le comunità di cui facciamo parte. Mettiamo al centro il cliente con il dovuto ecosistema attorno, seguendo il principio customer first partner always”. Dal momento che nessun vendor è in grado di fornire le funzionalità end-to-end richieste da un ambiente AI, Red Hat conta su un vasto sistema di partner (Isv e system integratori) con competenze approfondite su Red Hat Enterprise Linux, Red Hat OpenShift e Red Hat Ansible Automation Platform.

“La rivoluzione dell’intelligenza artificiale non sarebbe possibile senza una profonda integrazione con l’hybrid cloud: dallo sviluppo di applicazioni cloud-native, all’implementazione di soluzioni di edge computing, dall’automazione fino alla collaborazione tra le community open source. Saranno cloud e AI a plasmare l’evoluzione dell’enterprise IT – precisa Rodolfo Falcone, country manager Red Hat Italia -. Ho visto in questi anni uno sprint incredibile anche da parte della pubblica amministrazione verso il modello open source, e la realtà di oggi è quella di hybrid cloud in qualsiasi realtà pubblica e privata. Il tutto con una spolverata di AI sopra che facilita tutti i processi, li rende più intelligenti. Ma non esiste una AI perfetta, esistono i dati perfetti che do da gestire all’AI per creare i modelli di intelligenza artificiale. La strategia di Red Hat è quella di usare lo stesso rigore adottato per DevOps e SecDevOps anche nell’ambito dell’AI, aiutando i clienti ad automatizzare, abbatte i costi, facilitare i compiti”.

Il progetto InstructLab

Tutti gli annunci fanno riferimento al tema dell’AI – sottolinea Giorgio Galli, senior manager solution architect di Red Hat – e l’infrastruttura disaccoppiata dalla parte applicativa sovrastante poggia su tre pillar: il sistema operativo Linux che ha esteso le proprie funzionalità grazie all’AI (Red Hat Enteprise Linux AI), Red Hat Ansible Automation Platform e Red Hat OpenShift AI.

Per poter migliorare i modelli, Red Hat ha presentato il progetto open source InstructLab, che permette a tutta la community di contribuire a migliorare i modelli, secondo un metodo approvato da Ibm e dal Mit di Boston.

InstructLab è un progetto open source che mette a disposizione tool e metodologia per migliorare i Llm attraverso idee validate per far si che diventino patrimonio di tutti. “C’è un vero e proprio processo sotto a InstructLab – precisa Galli – perché prevede una fase di valutazione da parte della community ogni volta che viene apportata una miglioria al modello. Se i cambiamenti vengono validati, solo allora viene fatto il training del modello stesso. In pratica, vogliamo ripetere in ambito AI quello che abbiamo fatto nei precedenti 30 anni sulle altre nostre tecnologie open source. Perché l’AI generativa non è appannaggio degli hyperscaler e si può fare in modalità ibrida. L’apertura dei modelli Llm è un ulteriore passaggio verso questa modalità. Il lavoro fatto con Ibm, per fornire metodologie e creare use case, porta a modelli aperti”.

Ma i modelli saranno personalizzati in futuro? “Red hat è una società orizzontale, non ha un’applicazione sensibile che automatizza in modo diverso il manifatturiero dal sanitario – conclude Anguilletti -. Non facciamo differenze per vertical di mercato: seppure abbiamo realizzato bibliografie per diversi ambiti, questo non ha influenzato il codice che rilasciamo. In proiezione non escludo che metteremo a disposizione dei nostri clienti delle informazioni per tarare modelli su diversi verticali, ma non saremo noi a realizzarli, lo faremo in collaborazione con terze parti”.

L’ecosistema dei partner di Red Hat lavora per complementare la proposizione di Red Hat in termini geografici e di verticalizzazione. “System integrator e Isv indipendenti sono entità di riferimento per i nostri clienti. Con loro mi aspetto una forte collaborazione perché ci siano delle verticalizzazioni”.

A Denver – oltre alle partnership con Nvidia, Amd e Intel – annunciate le collaborazioni con Run:ai (per portare le capacità di allocazione delle risorse di Run:ai in Red Hat OpenShift AI), con Stability AI (per integrare modelli di GenAI aperti all’interno di Red Hat OpenShift AI e accedere a modelli linguistici di grandi dimensioni open source con una varietà di casi d’uso con immagini, video, audio, 3D, codice e linguaggio), con Elastic per supportare modelli di retrieval augmented generation in Red Hat OpenShift AI.

© RIPRODUZIONE RISERVATA