Il tema della sostenibilità suscita nelle aziende e nella PA interesse non solo per sensibilità effettiva verso le problematiche ambientali ma anche perché proprio le valutazioni su quanto le organizzazioni stanno facendo a questo proposito contribuiscono a valorizzarle e a migliorare o meno la percezione del brand presso i clienti e il pubblico. L’introduzione di team dedicati, soprattutto nelle grandi aziende, gli obblighi di misurazione dei consumi, quelli di certificazione, e il coordinamento nell’utilizzo dei dati IT e dei dati aziendali tout court, di fatto ha sollecitato anche i fornitori di soluzioni Ict ad offrire strumenti e piattaforme di misurazione e analisi che dovrebbero aiutare le imprese a soddisfare i loro bisogni e soprattutto a poterlo fare in tempi più brevi, con risultati certi.

Un tema importante, da rileggere anche in relazione alle pratiche di greenwashing delle aziende che presentano come ecosostenibili le proprie attività, cercando di occultarne il reale impatto ambientale negativo, una modalità di presentarsi “sostenibili” che non avrebbe più ragione d’essere a fronte di un approccio serio.

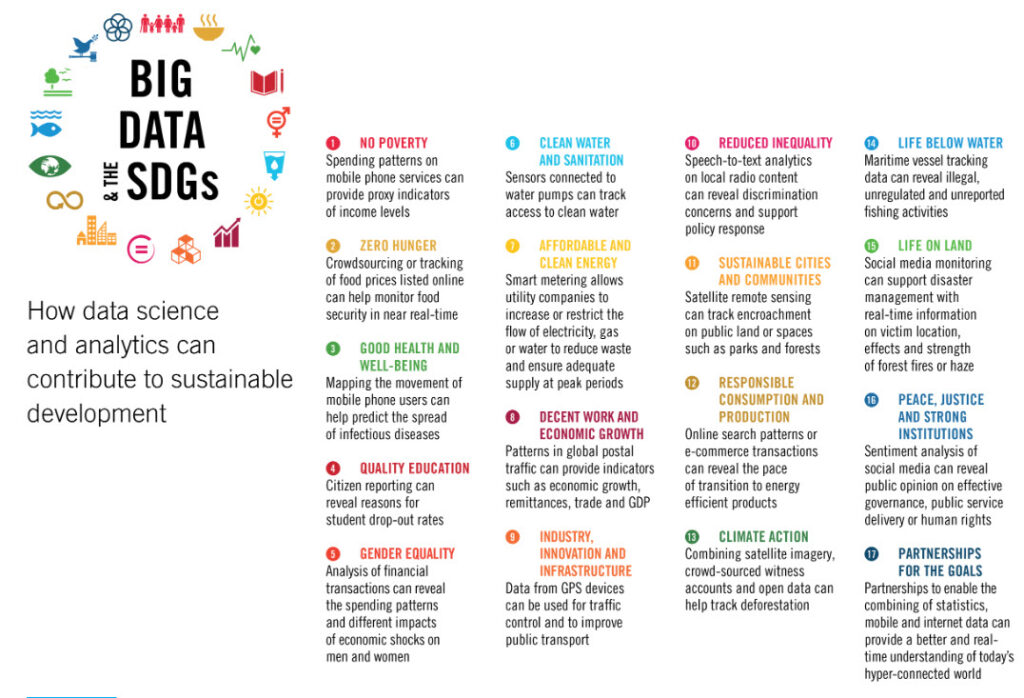

E’ chiaro come sensori, big data e analytics rappresentino pilastri tecnologici chiave per indirizzare i diversi problemi. Solo grazie alla disponibilità di misurazioni certe, infatti, si può capire cosa fare. E questo in uno scenario, fotografato da un report del Global Compact delle Nazioni Unite – Climate Leadership in the Eleventh Hour del Global Compact – curato da Accenture, che rileva come il 63% dei Ceo ritiene che la difficoltà nel misurare l’Esg/Dsg lungo la catena del valore sia un ostacolo alla sostenibilità nel proprio settore.

Giusto un paio di numeri di riferimento: secondo le stime di Research and markets, fanno capo a progetti per la sostenibilità già oltre 5 miliardi di dispositivi connessi all’IoT, che rappresentano quasi il 17% di tutti i sensori utilizzati. Le aziende che allineano i propri obiettivi ambientali, sociali e di governance (Esg) con gli Obiettivi di sviluppo della sostenibilità delle Nazioni Unite (Sdg), adottano infatti sempre più le tecnologie Internet of Things (IoT) e i big data per migliorare le proprie prestazioni. E proprio dall‘integrazione dell’IoT con altre tecnologie, come blockchain, analisi dei dati, intelligenza artificiale, machine learning e cloud, sono fondamentali soddisfare le priorità Esg e Sdg.

Il mercato globale dei software di analisi dei big data, proprio riguardo a test e misurazioni, cresce oggi con un Cagr vicino all’8% e sarà così fino al 2026. Una “nicchia” che vale da sola oltre 70 milioni di dollari. Questo all’interno di un mercato complessivo – quello dei big data e degli analytics – che Allied Market Research documenta crescere dai 198 miliardi di dollari del 2020 agli oltre 684 miliardi di dollari nel 2030 e che Accenture fotografa come in cima alla lista delle tecnologie per le value chain sostenibili.

I modelli operativi

Le aziende stanno inoltre prendendo atto del fatto che essere sostenibili può riflettersi in un vantaggio di business, ma si tratta di integrare il concetto in tutti i processi e nella filiera, quindi di sfruttare big data e analytics anche a valle, per raccogliere dal basso i feedback dei clienti sulle politiche di sostenibilità adottate – non solo per misurare “i consumi” – e concretamente aiutare a “informare” il processo decisionale in modo da gestire il rischio reputazionale relativo ai temi Esg/Sdg.

Purtroppo ancora oggi non si riesce a parlare di metriche comuni e diffuse trasversali e lo “spazio metrico Esg/Dsg” nel suo complesso è quanto di più soggettivo – e suscettibile di cambiamenti a seconda dei contesti che si misurano – che si possa trovare, anche a seconda dei Paesi di riferimento. Le aziende sul mercato che invece di scappare da questa complessità si presentano con una proposizione tecnologica in grado di “abbracciarla” per questo saranno di riferimento. In questi casi gli insight dovrebbero proprio servire come “connettori” tra i dati primari e comportamentali e le pratiche aziendali.

Anche dal punto di vista tecnologico modellizzare sistemi di questo tipo non è facile.

E per questo la sfida chiave, per quanto concerne le metriche Esg/Dsg, è riuscire a cogliere e riutilizzare i dati che si trovano sull’intera supply chain, che non riguardano solo l’organizzazione, ma anche i fornitori, e i fornitori dei fornitori. Si tratta poi di consolidarli e di riuscire ad ottenere una vista unica. Saranno gli algoritmi di intelligenza artificiale a migliorare il qualità, quantità e affidabilità dei dati raccolti per migliorare di conseguenza l’accuratezza complessiva e la rendicontazione “sostenibile” dei dati.

Dal punto di vista della realizzazione pratica è questo un ambito in cui entrano in gioco non solo le tecnologie query ed i percorsi multi-hop, ma quelle che per esempio portano a disporre di dati di training efficaci, e della capacità di trasformare la disponibilità di grafici di dati in veri “alberi della conoscenza” in grado di simulare e integrare più prontamente più dati grezzi e comprendere davvero il contesto.

In parole più semplici: è facile immaginare i vantaggi che si avrebbero se ogni nodo cui afferiscono dei sensori fosse in grado di provvedere sì al rilevamento dei dati dalla propria origine, ma anche alla propagazione delle informazioni che arrivano dai altri nodi fino eventualmente ad aggregare le informazioni prima ancora di propagarle.

McKinsey parla, non a caso, anche di “mappatura” e “smontabilità” dei processi, dei prodotti e dei servizi. Un approccio che andrebbe esteso proprio al campo di analisi dei dati.

Si distingueranno come lungimiranti le aziende che riconoscono che non è possibile fare bene perseguendo “complessivamente”, a 360 gradi, ogni iniziativa Esg/Sdg. Al contrario, sulla base di una chiara comprensione della propria strategia – nonché dei propri punti di forza e delle proprie lacune – è proficuo concentrarsi sull’identificazione delle iniziative che contano di più per i propri modelli di business. E per quelle sviluppare uno specifico approccio nell’utilizzo di big data e e analytics. Si tratta di misurare, e imparare a misurare, ciò che conta, anche con l’utilizzo di metriche a breve termine, ma con una solida metodologia di analisi volta all’aggiornamento e all’integrazione rapida delle informazioni, step in cui l’AI può imprimere la giusta accelerazione.

© RIPRODUZIONE RISERVATA