E’ un taglio concreto e pragmatico quello che Tibco ha scelto di dare al suo evento globale Tibco Analytics Forum 2022 (Taf 2022), una tre giorni ancora del tutto virtuale che vede protagonista, all’insegna del claim Analytics nel Tempo e nello Spazio, la proposta e gli esempi di utilizzo delle tecnologie più recenti che accompagnano il panorama degli analytics e del data management. Insieme ai top manager Tibco, infatti, sono proprio i clienti e partner, a introdurre e trattare i temi caldi a partire dagli esempi sul campo.

Ci pensa Michael O’Connell, Cao (Chief Analytics Officer) di Tibco ad aprire i lavori, evidenziando il potenziale dei dati “vivi e davvero utilizzabili quando sono disponibili anche gli strumenti di analisi visiva nel tempo e nello spazio“, in grado di evidenziare trend temporali e geospaziali.

Ma sono le esperienze sul campo di Nadieh Bremer, guru di Dataviz, a rubare subito la scena. Nadieh Bremer, infatti, dopo la laurea in astronomia, ha lavorato come data scientist per poi seguire la sua passione per la data visualization. Crea visuali per gli analytics uniche, che mescolano scienza e arte, ma sono anche molto concrete ed “utilizzabili”. Un aspetto importante sottolineato anche da O’Connell, a partire dall’assunto secondo cui “analytics e dati sono ovunque nel business digitale. E i dati che scorrono nel tempo e attraverso lo spazio sono fondamentali per ottenere insight e avviare azioni nel momento giusto e nei luoghi in cui servono”. Si tratta quindi di “prendere possesso dei propri analytic journey” e sbloccare il potenziale dei dati per decisioni rapide e smart”.

Non un problema da poco, anche perché se da una parte la scarsa qualità dei dati rappresenta un ostacolo concreto, il principale per i data scientist e gli analisti, quello che porta ad un’analisi condizionata dalla “qualità” del dato – è pure vero che profilazione, pulizia, standardizzazione – attività base per fare in modo che il dato riacquisti il suo vero potenziale – non rappresentano ancora “l’ultima tappa”, perché il dato alla fine di ogni processo deve essere realmente consumabile per produrre valore.

Da qui l’importanza della “visualization“.

Per tutti i passaggi sottolineati, Tibco propone le specifiche soluzioni che costituiscono un portafoglio completo per il data management e gli analytics con risorse per l’analisi visiva “self-service”, la data science ed il reporting.

Ne parla Tobias Lehtipalo, senior director Product Management di Tibco Software.

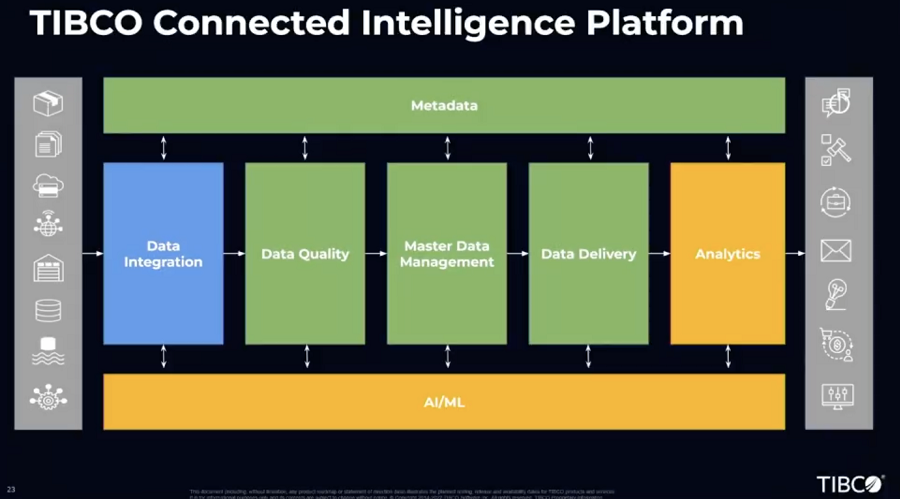

Alla base della proposta c’è Tibco Connected Intelligence Platform. Sulla scorta del mantra Connect, Unify e Predict. Identifica la possibilità di collegare potenzialmente alla platform qualsiasi device, applicazione e fonte dati (Connect, con l’architettura event-driven e l’integrazione basata sulla gestione delle Api); quella di unificare i dati in modo intelligente per quanto riguarda accesso, controllo e affidabilità (Unify, con le soluzioni Mdm e per la data virtualization); ed infine la possibilità di fare previsioni sulla scorta della “data-driven intelligence” di Tibco (Predict, con le soluzioni di visual analytics data science e streaming).

E’ all’interno della platform che si snodano quindi i passaggi chiave necessari per la valorizzazione del dato. Ovvero l’integrazione, il vaglio qualitativo, i processi di master data management, la data delivery e gli analytics. Gli elementi differenzianti della proposta sono le capacità di sfruttare in queste fasi l’intelligenza artificiale/ML e metadati.

La proposta di Tibco deve in realtà la sua forza alla capacità lato IT di fare leva sui concetti di “consistency/compliance e sulle best practice” e, attraverso l’automazione ed una user experience semplificata, innestare i meccanismi di collaborazione e la disponibilità self-service di analisi così da “assicurare al business l’autonomia e l’agilità richieste per passare dall’analisi dei dati alle decisioni”.

Scendendo appena di un livello in profondità, spiega Lehtipalo, si snodano quindi le soluzioni Tibco Cloud Integration per assicurare la facile integrazione dei dati da qualsiasi risorsa anche in cloud, grazie alla disponibilità di oltre 350 connettori pronti all’utilizzo e all’approccio low-code per accelerare lo sviluppo delle possibilità di integrazione e quelle per la Data Quality, per semplificare la profilazione, la pulizia e l’enrichment del dato, sfruttando l’AI, e sulla base di strumenti accessibili e attraverso servizi “riutilizzabili” a favorire la “consistency” anche a livello di processo. Con Tibco Ebx, come soluzione di master data management, a evitare i silos grazie a un approccio all-in-one per gestire gli asset di dati in tutta l’azienda.

E’ il sistema di data virtualization, nella “tattica” Tibco, a determinare a nostro avviso un ulteriore cambio di passo. “Rappresenta una sorta di ponte tra fonti dati multiple e diverse – spiega Lethipalo – combinando i dati decisionali critici in un luogo virtuale a favore degli analytics”. Di fatto è un layer che consente di accedere e combinare set di dati in velocità a tutti i dati in azienda, che siano DB tradizionali come big data, riducendo però tempi e costi di accesso/conservazione. In questo modo è possibile anche sfruttare una più ampia gamma di analisi (per esempio proprio quelle basate su visualizzazione, predittive, etc.) su dati nuovi e aggiornati al minuto. Gli utenti, grazie alla data virtualization, guadagnano la certezza di disporre di dati coerenti ma possono anche davvero procedere con le analisi di business volute.

Tibco Data Science invece interviene nel processo di valorizzazione del dato consentendo alle imprese di automatizzare le attività ordinarie e creare soluzioni aziendali basate su algoritmi di machine learning (ML) per risolvere problemi reali. E’ possibile così “accelerare lo sviluppo applicativo di analisi dei dati con modelli preconfigurati“, per poi eseguire i flussi di lavoro con Spotfire Analytics per riunire apprendimento automatico, dati, processi e persone e disporre di soluzioni subito operative, anche grazie a Tibco Model Ops. Di fatto annulla la “distanza” tra chi sviluppa i modelli di analisi e gli sviluppatori IT che devono implementarli in produzione, mentre Tibco Streaming, concepito per il cloud, consente di creare rapidamente applicazioni in tempo reale a una frazione del costo e del rischio di altre soluzioni alternative abilitando le potenzialità della business intelligence realtime.

Siamo agli ultimi passaggi dell’esposizione di Lethipalo con Webfocus che consente di esplorare, creare, analizzare, pubblicare e collaborare sui contenuti analitici, e rende possibile creare documenti di qualità per sale riunioni, rapporti finanziari e schede informative subito condivisibili, così come sulla base di un modello guidato sostituire ed aggiornare tutti i report correlati. E’ compito invece di Tibco Jaspersoft come strumento di enterprise reporting consentire di progettare e rilasciare importanti volumi di report in modo agile, e senza lavorazioni ripetitive.

L’ultimo passaggio è abilitato dalla proposta Spotfire. Tibco Spotfire è presentata come piattaforma di analisi basata sull’intelligenza artificiale. Prima di essere acquisita da Tibco nel 2007, Spotfire era una società di business intelligence con sede a Somerville, Massachusetts. L’evoluzione della proposta rappresenta oggi una soluzione chiave all’interno del portafoglio Tibco, perché consente a tutti di esplorare e individuare importanti evidenze tra i dati attraverso dashboard immersive e analisi avanzate.

L’analisi con Spotfire offre funzionalità su larga scala, tra cui analisi predittiva, analisi di geolocalizzazione e analisi in streaming, mentre con Spotfire Mods, è possibile generare app analitiche personalizzate in modo rapido, ripetuto e scalabile. Spotfire è vicino oramai alla versione 12 che aggiungerà alle altre caratteristiche il supporto per tutti i container Linux e una serie di miglioramenti per i ModelOps basati su AI e ML.

© RIPRODUZIONE RISERVATA