I numeri degli analisti relativi alla riuscita degli attacchi continuano a destare un allarme crescente. Questo vale nonostante sia più alto il livello di sensibilità sul tema cybersecurity da parte delle organizzazioni, come mostrano anche le ricerche più recenti.

Oggi, ad accrescere le preoccupazioni si aggiunge il tema dell’intelligenza artificiale (non solo di quella generativa) considerata un’arma sì a disposizione dei team di sicurezza ma anche al cybercrime che è avvantaggiato dalla rapidità con cui può utilizzare sul campo i vantaggi dell’AI. In due numeri: secondo McKinsey Global Institute il mercato della GenAI “aggiungerà valore all’economia globale ogni anno per un importo tra i 2,6 e i 4,4mila miliardi di dollari, ma si tratta di opportunità che comportano insieme rischi e compromessi proprio nel campo della sicurezza informatica”, tanto che l’impatto sulle aziende in media pesa per 5,34 milioni di dollari all’anno solo in relazione a eventuali interruzioni prolungate delle operations e ai relativi gravi danni reputazionali (fonte: Cybernomics 101, Barracuda, gennaio 2024).

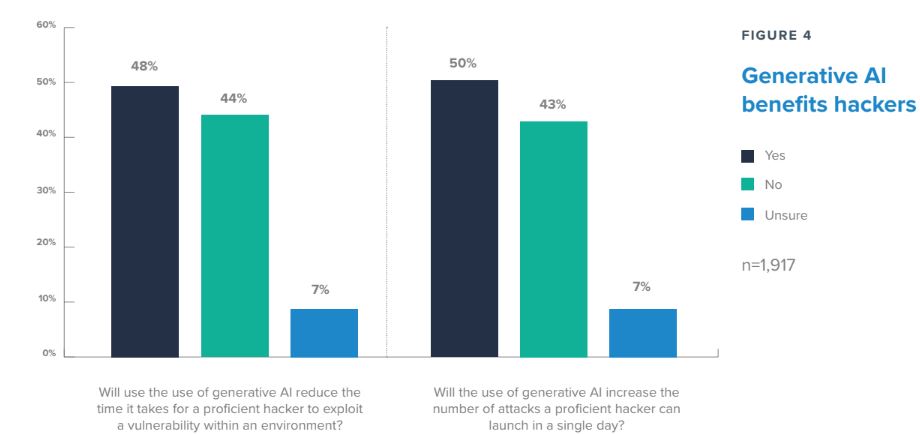

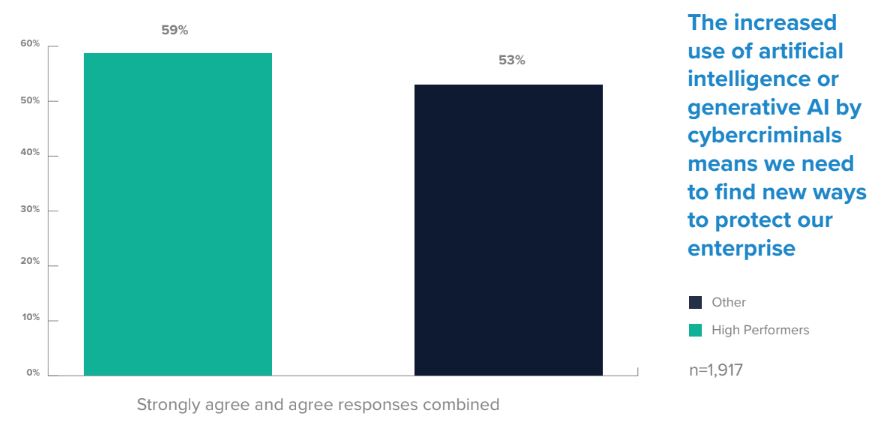

Oltre a questo è importante considerare che le applicazioni malevole possono essere create già in grado di utilizzare l’AI; possono consentire a chi attacca di apprendere proprio a partire dallo studio delle difese e adattarsi di conseguenza. Solo il 39% delle aziende intervistate oggi ritiene che la propria infrastruttura di sicurezza sia adeguatamente preparata a rispondere alle minacce automatizzate e potenziate grazie all’intelligenza artificiale. E’ quindi ancora più importante conoscere a fondo gli strumenti e le tattiche di cui gli hacker possono servirsi e su questo tema Barracuda propone un’analisi per evidenziare come già ora gli hacker utilizzino gli strumenti di intelligenza artificiale per rendere sempre più difficili e vane le strategie di difesa. Entriamo nell’analisi su sei punti.

Come sottolineano i report, l’email resta un mezzo sempre efficace per superare le barriere aziendali; ecco allora che la principale applicazione dell’AI riguarda proprio gli attacchi di phishing (1), spear phishing e business email compromise (Bec) per cui si insiste nell’imitazione di modelli comunicativi per la creazione automatizzata di messaggi ancor più precisi, verosimili e personalizzati.

Si parla di tecnologie che favoriscono un elevato livello di contestualizzazione linguistica, culturale e anche settoriale, rendendo l’individuazione delle e-mail fraudolente molto più difficile da parte delle misure di sicurezza tradizionali. WormGpt e EvilGpt sono poi un esempio di strumenti malevoli basati sull’AI che permettono di automatizzare la ricerca delle vulnerabilità delle vittime (2) e che hanno come immediata conseguenza la possibilità di incrementare il numero degli attacchi zero-day. Grazie all’AI poi il malware sviluppato può assumere la connotazione di essere anche “adattivo” e quindi modificare il proprio comportamento per eludere il rilevamento ed aggirare gli strumenti di analisi statica.

Nell’ultimo report di Clusit emerge come gli attacchi DDoS, in Italia, hanno superato nel 2023 il malware, e questo non accadeva da anni. E’ un dato che è possibile mettere in relazione con la creazione di botnet sempre più grandi, perché grazie all’AI è possibile gestire ancora meglio il coordinamento e l’automazione delle reti di botnet in grado di evitare sistematicamente gli strumenti Captcha e i meccanismi proof of work, oltre a evolversi per evitare gli algoritmi tradizionali che si basano su serie storiche di dati per identificare i bot (3).

Arriviamo al quarto punto che ha un impatto ancora più stretto con le esperienze digitali di tutti i giorni. I deepfake: sono video e audio falsi generati grazie all’AI a partire da contenuti reali. Chiunque abbia accesso a filmati e registrazioni audio, infatti, può utilizzare strumenti basati su AI per creare imitazioni estremamente realistiche e inserirle nei messaggi di phishing per ingannare i destinatari (4). Nessuno si deve sentire sufficientemente protetto considerata, per esempio, la facilità con cui è possibile procedere anche con le falsificazioni vocali fino a simulare non solo personaggi famosi e influenti ma anche la voce di un C-level catturata ad un convegno, per esempio per riutilizzarla poi ai danni dei dipendenti dell’azienda presso cui egli lavora per indurli a compiere determinate operazioni convinti che la provenienza dei messaggi sia legittima.

Gli ultimi analizzati probabilmente rappresentano i punti più critici. Il primo è relativo al furto di credenziali ed ai tentativi di accesso automatizzati (5) ed il secondo alla manipolazione dei modelli di addestramento AI (6). Nel primo caso evidenziamo come spesso gli attacchi informatici partano dal furto delle credenziali che consentono agli aggressori di accedere a un account e/o a una rete. Ecco, l’AI in questi casi può consentire di esperire diverse vie per accelerare il raggiungimento dell’obiettivo. E’ possibile creare pagine di login false che assomigliano a siti Web legittimi per raggirare gli utenti, oppure incrementare la quantità dei tentativi di credential stuffing, che testano in velocità grandi volumi di combinazioni di password e nomi utente ottenute tramite la violazione dei dati per ottenere l’accesso agli account personali. Ecco che in questo caso è facile immaginare come AI e quantum computing combinati potrebbero presto sconvolgere del tutto il paradigma dei modelli di difesa, soprattutto nell’ambito delle sfide di cyberwarfare.

L’ultimo punto è a nostro avviso ancora più insidioso: i modelli di AI utilizzati per le applicazioni prevedono l’utilizzo di un’ampia serie di dati per l’addestramento o l’aggiornamento dei modelli. Violare la sicurezza dei dati fino a manipolarli e inquinarli, darebbe origine a modelli AI che forniscono risultati tanto imprevedibili quanto pericolosi, soprattutto per le organizzazioni che si affidano all’intelligenza artificiale per supportare i processi automatizzati. Un rischio che, in particolare nelle applicazioni sui device interconnessi negli scenari IoT, può portare a veri e propri disastri e incidenti importanti (basta in questo caso l’esempio dei dispositivi utilizzati per automatizzare i sistemi di guida o la gestione degli ambienti “smart”).

© RIPRODUZIONE RISERVATA