L’adozione delle soluzioni di intelligenza artificiale per l’automazione dei processi aziendali pervaderà, a tendere, tutti gli ambiti della gestione aziendale. Oggi già impatta il comparto IT, per l’implementazione dell’AI volta a migliorare la cybersecurity, la gestione delle risorse infrastrutturali, etc. ma anche finance, risorse umane, produzione, marketing e logistica.

Nelle organizzazioni servono figure responsabili riguardo gli aspetti di regolamentazione e conformità. Persone che siano in grado di guidare l’utilizzo dell’AI, tanto più in un momento come quello attuale di ‘attivazione’ dei regolamenti e delle direttive a livello europeo.

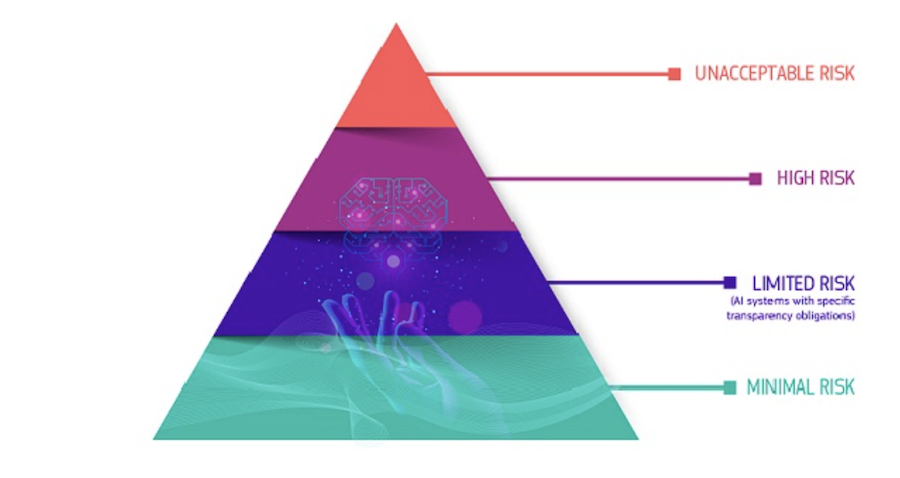

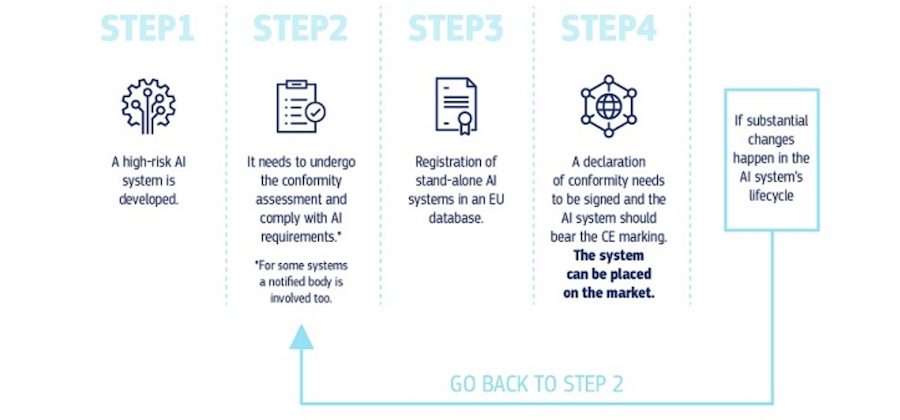

Solo per citare le ‘tappe‘ più recenti, ricordiamo che l’AI Act europeo è di fatto la prima legge articolata sull’IA – il 14 giugno il testo è ‘passato’ all’assemblea di Strasburgo – ed è stata adottata dai deputati la posizione negoziale del parlamento europeo sul Regolamento per l’utilizzo dell’intelligenza artificiale. Ora si attende l’avvio dei negoziati fra i Paesi che fanno parte del Consiglio Ue perché la legge assuma la sua forma definitiva che comunque già oggi esclude la possibilità di utilizzare l’AI per la sorveglianza sfruttando la rilevazione biometrica, il riconoscimento delle emozioni, il social scoring e gli utilizzi “predittivi” per valutare la ‘predisposizione al crimine’, per esempio. In primo piano, da valutare, sono le linee guida sull’utilizzo dei Large Language Model (Llm), come ChatGpt, Google Bard. Per questo Gartner individua quattro aree critiche, per richiamare l’attenzione dei decision maker aziendali, in particolare in ambito “legal”.

Soprattutto è importante iniziare a muoversi ora perché, come spiega Laura Cohn, senior principal research di Gartner, “sebbene le leggi in molte giurisdizioni potrebbero non entrare in vigore prima del 2025, i leader legali sono chiamati ad iniziare ad agire comunque in attesa che si delinei una regolamentazione definitiva. Per esempio possono già esaminare eventuali aree di impatto e sovrapposizione con i processi attuali per aiutare i dirigenti senior e i consigli di amministrazione a prepararsi ai cambiamenti normativi mentre sviluppano la strategia di AI aziendale”.

Per farsi trovare pronti e disporre di una governance collaudata al momento opportuno, mentre si delineano ulteriormente i regolamenti, ecco allora l’analisi delle quattro tracce di intervento.

Trasparenza

Nei confronti sia dei dipendenti, sia dei partner e dei clienti il primo punto su cui intervenire riguarda la trasparenza. Incorporare la trasparenza nell’uso dell’AI è già emerso come principio fondamentale nelle proposte normative a livello mondiale e, così come accade già o dovrebbe essere per la sostenibilità, i responsabili legali devono pensare a come le loro organizzazioni renderanno esplicito e comunicheranno a tutti come e quando l’organizzazione sta interagendo con l’AI. Si pensi anche solo agli utilizzi nelle attività di marketing, e nei processi di assunzione in ambito HR. Chiaro che bisogna aggiornare le informative sulla privacy, termini e condizioni sui siti Web, contratti, etc..

Gartner parla nello specifico della possibilità di studiare la disponibilità di un trust center, dando per scontata la necessità di un avviso specifico al momento della raccolta dei dati che espone in dettaglio i modi in cui l’organizzazione utilizza l’AI. Allo stesso tempo, servirà allineare anche il codice di condotta dei fornitori nello stesso senso.

Gestione del rischio

In azienda, i responsabili legali ed i decision maker devono prodigarsi, inoltre, in uno sforzo interfunzionale vòlto ad implementare tutti i controlli di gestione del rischio così da coprire l’intero ciclo di vita di utilizzo dei diversi sistemi/strumenti di AI. Spiega Cohn: “Un approccio potrebbe essere una valutazione dell’impatto algoritmico (Aia, ovvero Algorithmic Impact Assessment) che documenta come vengono prese le decisioni, espone la due diligence e riduce i rischi regolamentari presenti e futuri e altre responsabilità”.

Un ambito di evidente sovrapposizione con la cybersecurity questo. Ne parliamo in un successivo passaggio specifico. Perché la sicurezza dell’AI riguarda anche la sicurezza delle informazioni, la gestione dei dati – abbiamo già visto in parte la privacy – ma è chiaro che nel tempo il tema comprenderà anche la tutela stessa dell’azienda, la cui compliance all’evoluzione dei regolamenti richiederà anche la disponibilità di competenze più specifiche nell’ambito legal/data science. Che di fatto oggi mancano. O comunque non sono ancora “allenate” in modo specifico a seconda dell’utilizzo dell’AI nei diversi verticali. Sarebbe interessante in questi casi considerare anche l’impatto sul mercato di possibili nuove formule assicurative proprio in relazione all’utilizzo dell’AI e ad eventuali incident correlati.

Governance, supervisione e responsabilità

“Un rischio molto evidente nell’uso degli strumenti Llm è che essi possono sbagliare e sbagliare di molto, pur sembrando all’apparenza del tutto plausibili ed attendibili” – spiega Cohn. Impossibile quindi e scorretto fare a meno della supervisione umana e di tutti i controlli interni richiesti prima che “l’output” offerto dagli strumenti di AI diventi azione o rappresenti la valutazione ufficiale.

In questo senso potrebbe essere utile pensare ad una figura responsabile dell’AI, così come d’altra parte sono nate già diverse figure “responsabili” nelle aziende su specifici temi sfidanti (si pensi alla sicurezza fisica degli ambienti di lavoro, al trattamento dei dati, etc.).

Servirebbe ad aiutare i team nella progettazione e nell’implementazione anche delle necessarie fasi di controllo umano e, a seconda del dipartimento che ospita l’iniziativa sull’intelligenza artificiale, questa persona potrebbe anche essere quindi un membro del team con profonde conoscenze funzionali, un membro del team di sicurezza o privacy, o, se ci sono integrazioni con la ricerca aziendale, il responsabile del luogo di lavoro digitale.

Sarebbe infine molto interessante l’istituzione di un comitato consultivo sull’etica digitale composto da esperti legali, operativi, informatici, marketing e consulenti esterni pensato per aiutare i team di progetto a gestire tutte le questioni etiche, e poi assicurarsi la condivisione dei risultati con i consigli di amministrazione.

Privacy dei dati, focus principale

“È evidente – ritorna sul tema Cohn – che i regolatori vogliono prima di tutto proteggere la privacy dei dati delle persone quando si tratta dell’uso dell’IA”. Serve quindi tenere il passo per quanto riguarda gli aggiornamenti di legge, su tutte le pratiche. Non a caso in apertura abbiamo fatto riferimento, per esempio, anche al monitoraggio biometrico che è regolamentato con particolare attenzione. Vengono in aiuto per questi aspetti gli approcci zero trust e di privacy-by-design già entrati nelle consuetudini degli esperti di cybersecurity. E sarà importante, infine, tanto più quanto più si diffondono le versioni ‘pubbliche’ degli strumenti Llm, avvisare sempre i dipendenti che le informazioni che inseriscono potrebbero diventare parte di diversi set di dati di addestramento. In concreto, questo significa che informazioni sensibili o proprietarie utilizzate negli input potrebbero essere riutilizzate poi anche nelle risposte dati ad utenti esterni all’azienda.

Linee guida, formazione del personale sui rischi, indicazioni su come utilizzare gli strumenti di AI in modo sicuro i passi irrinunciabili da percorrere.

© RIPRODUZIONE RISERVATA