A voler cercare di caratterizzare la proposta di Snowflake sul mercato, il servizio di archiviazione ed analisi dei dati si qualifica per essere basato sul cloud, proposto con il modello data-as-a-service, e consentire archiviazione ed analisi dei dati utilizzando risorse e software basati a loro volta sul cloud. Il tratto distintivo più importante è però che l’azienda propone un servizio in grado di disaccoppiare l’archiviazione dall’elaborazione, che è scalabile e si basa su un sistema di condivisione e ‘clonazione’ dei dati efficace sul cloud dei tre principali hyperscaler: Aws, Microsoft Azure e Google Cloud.

Per spiegare meglio: gli utenti possono incrementare senza limitazioni il numero di cluster di calcolo dedicati a ciascun workload per svolgere operazioni simultanee, senza limitazioni. Una volta completato un workload, viene ripristinata la capacità di calcolo iniziale, così i clienti non devono pagare per risorse in eccesso, anche perché gli utilizzi sono fatturati al secondo e gestiti in modo semplice e trasparente.

La platform Data Cloud proposta consente di archiviare, integrare e analizzare data set di dati strutturati, sem-strutturati e non strutturati in un’unica posizione ed attraverso il suo marketplace, Snowflake permette di acquisire in modo sicuro data set, strumenti e applicazioni di terze parti, e servizi dati complementari, tutto senza dover spostare o copiare le informazioni. Un modello che permette anche una gestione delle applicazioni migliori, per esempio consente di distribuire app connesse, in cui dati e codice rimangono separati. In questo caso, per esempio, il provider dell’applicazione può continuare a gestire semplicemente il codice dell’applicazione mentre i clienti collegano l’applicazione ai dati che rimangono nei loro account Snowflake.

Snowflake Data Cloud Summit, tempo di bilanci

In occasione di Snowflake Data Cloud Summit 2024, a San Francisco, è tornato centrale nei keynote il tema per cui, con l’adozione dell’intelligenza artificiale, le aziende stanno incrementando l’analisi e l’elaborazione dei loro dati non strutturati. Un aspetto che permette di valorizzare fonti di dati non sfruttate, ma rende allo stesso tempo anche importante un approccio moderno alla governance per proteggere informazioni sensibili e private. In un numero, secondo la ricerca Snowflake Data Trends 2024, le aziende solo nell’ultimo anno avrebbero aumentato l’elaborazione dei dati non strutturati del 123%.

Da qui l’attivazione dell’azienda in questa direzione strategica. Già in primavera, Snowflake ha annunciato in occasione di Nvidia Gtc AI Conference un’estesa collaborazione con l’azienda pensata per offrire ai clienti una solida soluzione di AI, frutto dell’integrazione tra la piattaforma full-stack accelerata di Nvidia con la data foundation e l’AI di Snowflake Data Cloud per combinare infrastrutture e capacità di calcolo, così da sbloccare e accelerare la produttività dell’intelligenza artificiale e alimentare la trasformazione aziendale in ogni settore.

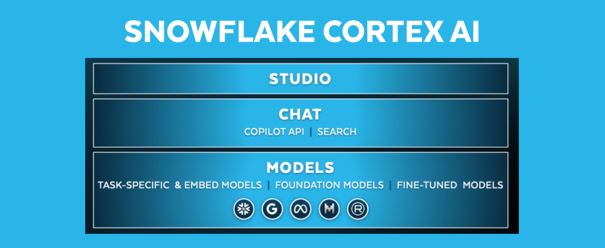

La partnership punta ad integrare il potenziale del software della capacità computazionale di Nvidia alla piattaforma dati di Snowflake per accelerare l’adozione dell’AI nelle aziende. Si parla in particolare di integrazione di Nvidia NeMo per l’utilizzo immediato di NeMo Retriever sui dati proprietari nella Data Cloud, mantenendone sicurezza, privacy e governance. NeMo Retriever ottimizza le prestazioni e la scalabilità delle applicazioni chatbot e può accelerare il time to value delle oltre 400 aziende che stanno già realizzando applicazioni di intelligenza artificiale con Snowflake Cortex. E’ il servizio per modelli linguistici di grandi dimensioni (Llm) e per la ricerca vettoriale di Snowflake in grado di analizzare dati di testo e creare applicazioni AI in modo veloce con ricerca vettoriale, Llm e modelli AI di riferimento del settore completamente gestiti.

L’evento di giugno porta l’annuncio di un ulteriore passo in avanti della partnership con Nvidia. Per cui Snowflake implementa il software Nvidia AI Enterprise in modo da integrare i microservizi NeMo Retriever all’interno di Snowflake Cortex AI. Questo consente alle organizzazioni di collegare modelli personalizzati con dati aziendali eterogenei per ottenere risposte particolarmente accurate. Inoltre, il Llm Snowflake Arctic è ora pienamente supportato dal software Nvidia TensorRT-Llm per offrire agli utenti prestazioni ottimizzate. Il guadagno per le aziende è che possono creare soluzioni AI personalizzate, specifiche per i diversi casi d’uso, in modo più agile.

Evolve allo stesso tempo proprio la proposta Snowflake Cortex AI che abilita anche la possibilità di sviluppare in pochi minuti chatbot in grado di dialogare direttamente con i dati per ottenere le risposte necessarie più velocemente.

L’azienda sta democratizzando il modo in cui gli utenti possono personalizzare l’AI per casi d’uso specifici. Lo fa con la proposta di una nuova interfaccia interattiva senza codice, dell’accesso facilitato agli Llm e alle ottimizzazioni serverless per accelerare il percorso di operatività dei modelli con un’esperienza di apprendimento automatico (ML) integrata attraverso Snowflake ML, che consente agli sviluppatori di costruire, scoprire e governare modelli e funzionalità lungo tutto il ciclo di vita del machine learning.

La piattaforma unificata Snowflake per ML e AI generativa offre la possibilità di estrarre più valore dai dati, senza rinunciare a sicurezza, governance e controllo. Ed il rafforzamento della partnership con Nvidia, su questo fronte, riserva le funzionalità software di Nvidia AI Enterprise che saranno offerte in Cortex AI, di cui abbiamo appena parlato. A quanto già visto aggiungiamo l’integrazione di Nvidia Triton Inference Server per distribuire, eseguire e scalare l’inferenza dell’intelligenza artificiale su qualsiasi applicazione e piattaforma.

Snowflake, l’evoluzione della piattaforma

Lato piattaforma, Data Cloud, i passi in avanti più importanti riguardano l’implementazione di catalogo aperta per Apache Iceberg, uno standard di riferimento per data lakehouse e data lake.

Polaris Catalog (questo il suo nome) sarà disponibile nei prossimi tre mesi. Consentirà alle aziende e all’intera comunità Iceberg maggiore flessibilità, scelta e controllo sui propri dati. Apre all’interoperabilità di Apache Iceberg con Amazon Web Services (Aws), Confluent, Dremio, Google Cloud, Microsoft Azure, Salesforce e altri ancora.

Spiega così il valore della proposta Christian Kleinerman, Evp of Product di Snowflake: “Le imprese desiderano uno storage aperto e motori di query interoperabili, senza lock-in. E così ora semplifichiamo il modo in cui ogni organizzazione può accedere facilmente ai propri dati su sistemi diversi ]…[“.

Apache Iceberg è oggi uno dei principali formati di tabelle dati open source; con Polaris Catalog gli utenti hanno a disposizione un ambiente unico e centralizzato in cui qualsiasi motore può trovare e accedere alle tabelle Iceberg di un’organizzazione con un’interoperabilità completa e aperta. Il protocollo alla base di Polaris, infatti,consente di accedere e recuperare i dati da qualsiasi motore che supporti le Api Rest di Iceberg, tra cui Apache Flink, Apache Spark, Dremio, Python, Trino, etc.

© RIPRODUZIONE RISERVATA