Per comprendere l’evoluzione del panorama tecnologico storage, strategico anche in relazione ai workload legati all’AI, che sollecitano ancora di più le infrastrutture e i data center, Insight 2024 rappresenta l’appuntamento clou che NetApp propone per individuare e capire le future direzioni e le strategie messe in campo anche in relazione ai passi in avanti necessari per quanto riguarda la gestione dei dati in cloud. Ne parliamo, con Davide Marini, country manager di NetApp Italia, e Roberto Patano, Technical Account manager che offrono una visione articolata delle innovazioni tecnologiche e delle soluzioni avanzate che NetApp annuncia per affrontare le relative sfide.

L’evento è momento di confronto e approfondimento su come l’azienda intende supportare le imprese nell’affrontare un mercato sempre più complesso e competitivo. E gli aggiornamenti a cadenza trimestrale, introdotti per accelerare il ritmo dell’innovazione, riflettono una strategia orientata non solo a soddisfare le esigenze immediate dei clienti, ma a prevedere e prepararsi alle evoluzioni future del settore. Esordisce Marini: “NetApp ha recentemente annunciato risultati finanziari positivi per il primo trimestre del fiscal year corrente, con una crescita significativa in settori chiave come lo storage flash (+21%) e i servizi cloud (+40%). In Italia la crescita è in linea con i risultati globali e l’azienda sta rafforzando la sua posizione con l’acquisizione di nuovi clienti e partnership strategiche, come quella con l’Istituto Europeo di Oncologia (Ieo) e Aruba“. I numeri riflettono l’efficacia della strategia aziendale e la capacità di NetApp di adattarsi e rispondere alle esigenze di un mercato in rapida trasformazione. Perché i dati non solo vanno gestiti, ma anche governati e protetti, e nella “strategia NetApp è centrale rendere più semplici gli ambienti infrastrutturali con la proposta di un’intelligent data infrastructure con la componente di gestione dei dati al centro”.

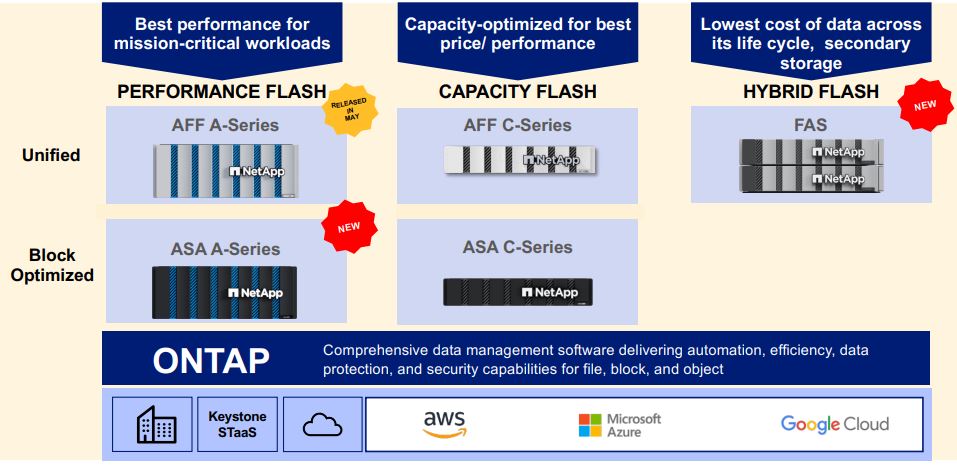

Sono cinque i pilastri entro cui si collocano le novità di NetApp Insight 2024 e che guideranno la strategia di NetApp nei prossimi anni. Enterprise Storage (1) con focus sulle nuove soluzioni Asa (All San Array) che combinano semplicità, performance e convenienza e rispondono alle esigenze di scalabilità e flessibilità delle moderne infrastrutture IT; Cyber Resiliency (2) con l’accento sulla sicurezza cibernetica e la resilienza dei dati, attraverso soluzioni che offrono protezione avanzata contro minacce come il ransomware; l’evoluzione nell’offering Cloud Storage (3) con l’espansione delle capacità di integrazione e gestione dei dati nel cloud, e le partnership strategiche con i principali hyperscaler (Azure, Aws e Google); lo sviluppo di BlueXP (4) come piattaforma di gestione unificata che semplifica l’amministrazione delle risorse di storage, sia on-premise che nel cloud, migliorando l’efficienza operativa e la sicurezza e il tema dell’artificial intelligence (5) con l’innovativa visione di NetApp e lo sviluppo di infrastrutture e servizi che facilitano l’adozione di tecnologie di intelligenza artificiale per ottimizzare la gestione e l’analisi dei dati.

NetApp Asa, evolve la proposta per l’enterprise storage

Dettaglia i capisaldi di ogni singolo punto così Roberto Patano: “La nuova declinazione San, la serie Asa (All San Array) nasce per offrire la semplicità di messa in opera e utilizzo richiesta dalle aziende di fatto con performance raddoppiate rispetto alla generazione precedente, arrivando fino a 12 milioni di Iops e con latenze inferiori al millisecondo”. Si parla di soluzioni sviluppate pensando a scenari specifici come i data center moderni, che richiedono alta disponibilità, scalabilità e facilità di gestione. NetApp introduce diverse migliorie non solo dal punto di vista delle performance, ma anche della sostenibilità. Patano: “Tutte le nuove macchine arrivano con un packaging totalmente riciclabile e semplice da gestire”, che dimostra l’impegno dell’azienda verso pratiche più ecologiche. Uno degli aspetti più apprezzati delle nuove soluzioni Asa è proprio la facilità di configurazione. NetApp ha ridisegnato infatti la parte di configurazione, semplificando i processi e rendendo possibile l’implementazione delle nuove macchine in pochi minuti. “Abbiamo testato la nuova interfaccia e le nuove modalità di accesso con diversi clienti, e i feedback sono stati del tutto positivi, anche perché per mettere in produzione una macchina bastano dai 30 secondi ai 4 minuti, a seconda del tipo di configurazione”, dettaglia Patano.

Questa semplicità si traduce in un risparmio significativo di tempo e risorse, perché consente alle aziende di concentrarsi su aspetti strategici piuttosto che su complessi processi di configurazione. La nuova serie Asa quindi è proposta alle imprese che vogliono modernizzare il proprio data center senza dover affrontare la complessità tipica delle architetture tradizionali. Le prestazioni elevate sono un punto di forza della serie. Patano: “Le nuove soluzioni raddoppiano le performance rispetto alle serie precedenti, come Asa 400 e Asa 800, con capacità che le rende ideali per ambienti Vmware e i database aziendali, dove la velocità e l’affidabilità sono cruciali”. Con l’utilizzo del protocollo Nvme poi è offerta maggiore velocità di accesso ai dati rispetto ai tradizionali protocolli iScsi e fiber channel. Prosegue Patano: “Abbiamo così ripensato tutta l’architettura interna per ottimizzare le performance, utilizzando processori più potenti e una memoria più estesa” migliorie che consentono un incremento significativo della velocità di elaborazione e un’efficienza energetica superiore rispetto alla generazione precedente Asa”.

L’attenzione alla sostenibilità resta un tema centrale per NetApp, che ha introdotto numerose innovazioni per ridurre l’impatto ambientale delle sue soluzioni. Davide Marini, lo conferma: “ogni nuovo prodotto è progettato per minimizzare il consumo energetico, con componenti certificati e un design che riduce l’occupazione di spazio nei data center”.

Resta strategico, su tutto, il tratto distintivo della strategia di NetApp e cioè l’uso di un unico sistema operativo, Ontap, per tutte le soluzioni di storage, sia on-premise che nel cloud. E’ proprio l’approccio unificato a permettere una maggiore interoperabilità ed a facilitare la gestione delle infrastrutture IT. Patano: “Con Ontap, infatti, i clienti hanno accesso a tutte le funzionalità, come la replica e la compliance, senza dover acquistare componenti aggiuntivi”. Questa uniformità semplifica non solo la gestione, ma anche l’integrazione con altre tecnologie e ambienti. Senza considerare poi che l’introduzione della nuova serie Asa non sostituisce le serie precedenti, ma le affianca, garantendo una transizione graduale per i clienti che desiderano aggiornare le proprie infrastrutture senza discontinuità operative.

Oltre alla nuova serie Asa, NetApp ha introdotto nuove soluzioni ibride che combinano dischi flash e dischi rotativi tradizionali. Si parla in questo caso di soluzioni ideali per applicazioni che non richiedono le massime performance dei dischi flash, come il backup e l’archiviazione. Anche in questo caso però “è stata rivista l’architettura interna per offrire più espandibilità e flessibilità, rendendo queste soluzioni adatte per una vasta gamma di utilizzi, da Tier 1 al backup”. Così le aziende possono adattare la propria infrastruttura di storage alle diverse esigenze applicative, ottimizzando i costi e migliorando l’efficienza operativa. Inoltre, la possibilità di integrare facilmente queste soluzioni con i sistemi esistenti rende il processo di aggiornamento o espansione più semplice e conveniente.

Cyber resiliency, sfida aperta al ransomware

In un contesto globale in cui le minacce informatiche sono in costante aumento, la sicurezza dei dati continua a rappresentare una priorità assoluta per le aziende. NetApp ha sviluppato una serie di soluzioni per garantire protezione e resilienza allo storage che – come vuole specificare Patano – “rappresenta l’ultimo baluardo di sicurezza quando tutte le altre difese perimetrali vengono superate”.

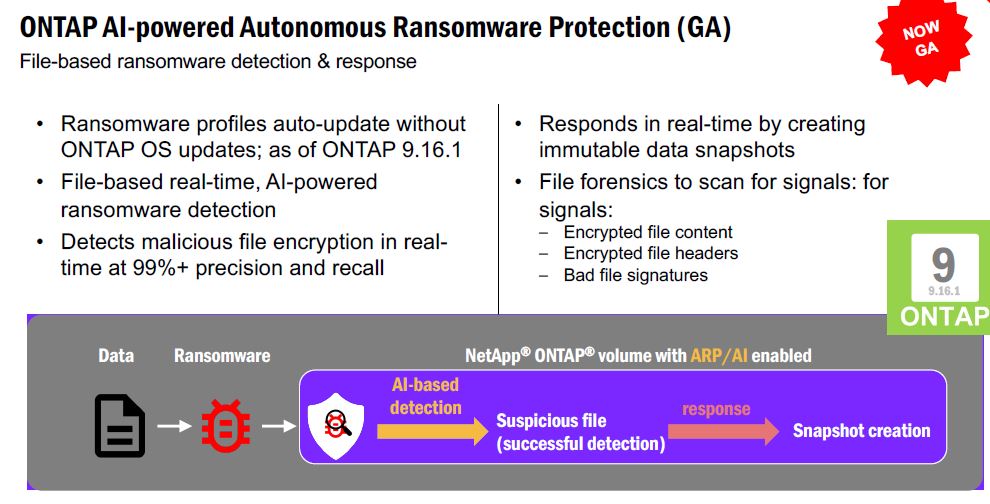

L’azienda propone soluzioni che integrano livelli avanzati di protezione dei dati certificate anche da enti indipendenti come gli SE Labs. L’annuncio principale in questo ambito si collega alla General Availability della versione 9.16.1 di Ontap, il sistema operativo proprietario di NetApp con funzionalità avanzate che permettono di rilevare e bloccare automaticamente attività sospette, offrendo una protezione in tempo reale senza impatti negativi sulle performance. Si parla in particolare di Ontap AI-powered Autonomous Ransomware Protection. Patano spiega come “il sistema operativo monitora continuamente l’attività sui dischi, rilevando eventuali anomalie che potrebbero indicare un attacco ransomware e creando immediatamente una copia delle informazioni che non può essere modificata”. Un approccio proattivo che riduce drasticamente il rischio di perdita di dati e minimizza l’impatto di eventuali attacchi. Il sistema, in particolare, utilizza modelli di intelligenza artificiale per identificare comportamenti sospetti e, una volta rilevata una minaccia, isola automaticamente le informazioni compromesse, bloccando la propagazione dell’attacco. Prosegue Patano: “Abbiamo così raggiunto il 99% di successo nel riconoscere attacchi ransomware, con praticamente zero falsi positivi”. Una funzionalità che, essendo integrata nel sistema operativo, non comporta costi aggiuntivi per gli utenti, “perché – come vuole precisare a sua volta Marini – “la nostra filosofia è che la sicurezza dei dati non dovrebbe essere un lusso, ma una componente fondamentale di qualsiasi infrastruttura IT”.

Oltre alla protezione automatica contro i ransomware, NetApp offre anche la possibilità di connettere il sistema operativo al cloud per scaricare aggiornamenti continui relativi alle nuove minacce identificate, mantenendo sempre attivo il livello più elevato di protezione. Questo sistema di aggiornamento, simile a quello degli antivirus tradizionali, assicura che le difese siano sempre all’avanguardia rispetto agli attacchi emergenti.

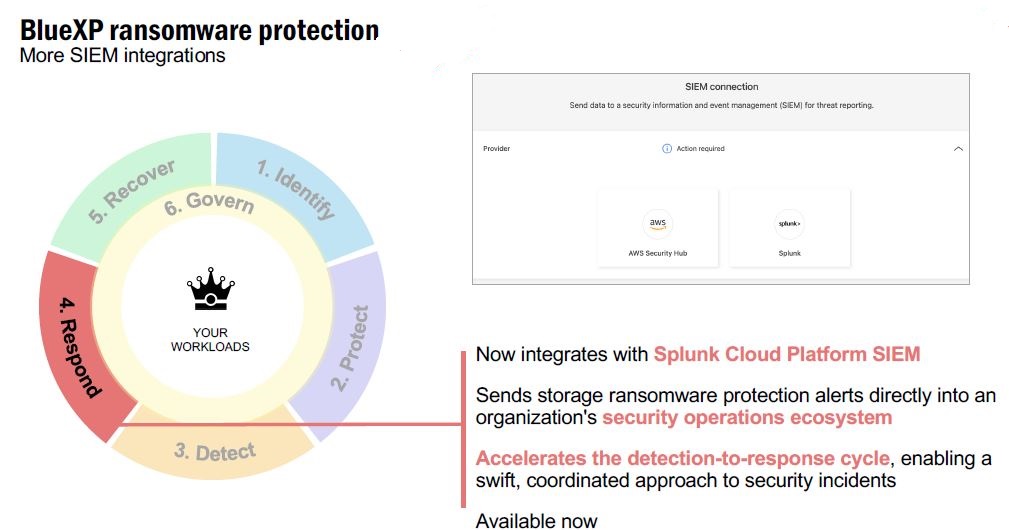

Solo per scendere ulteriormente nel dettaglio è importante spiegare che l’Autonomous Ransomware Protection “non si limita a inviare alert, ma può intervenire direttamente isolando le macchine da cui si sospetta sia partito l’attacco e questa capacità di rispondere autonomamente alle minacce, unita alla possibilità di integrare Ontap con piattaforme di monitoraggio e gestione delle minacce come Splunk, offre un livello di protezione ulteriore unico nel suo genere”.

Oltre a questo BlueXP, la piattaforma di gestione unificata di NetApp, non solo fornisce una visione centralizzata di tutte le risorse di storage, ma offre ora funzionalità avanzate per la classificazione dei dati e la protezione contro il ransomware. “Grazie a BlueXP, i clienti possono identificare facilmente i dati sensibili e applicare politiche di protezione adeguate, garantendo che solo gli utenti autorizzati possano accedere a informazioni critiche”, spiega Patano. BlueXP Ransomware Protection monitora quindi il comportamento degli utenti all’interno dell’infrastruttura IT, rilevando eventuali attività sospette e attivando automaticamente misure di protezione. In caso di attacco, il sistema può creare copie sicure dei dati, isolarli e avviare procedure di ripristino, minimizzando così l’impatto dell’attacco.

NetApp offre poi un’ulteriore garanzia di protezione di livello. Assicura che, se la configurazione della soluzione segue le best practices e include il supporto dei servizi professionali NetApp, i dati non verranno mai persi. In caso contrario si impegna a un risarcimento economico. Patano: “Garantiamo l’alta affidabilità con i famosi sei 9 (99,9999%) di affidabilità, per un downtime annuale inferiore ai cinque minuti”. Questa garanzia, insieme a funzionalità avanzate di protezione come l’anti-ransomware integrato, rende le soluzioni NetApp adatte per le aziende che necessitano di elevati standard di sicurezza e continuità operativa. L’alta affidabilità e la protezione dei dati sono infatti elementi critici per settori come la finanza, la sanità e il retail, dove ogni interruzione di servizio può comportare gravi conseguenze. L’azienda si concentra sulla continuità operativa delle aziende anche offrendo soluzioni che garantiscono l’alta affidabilità e la business continuity comunque, pure in caso di attacchi o guasti con le sue funzionalità avanzate di replica e failover che permettono di mantenere operativi i sistemi anche in situazioni di emergenza.

Evoluzione cloud storage, negli scenari multicloud

La gestione dei dati nel cloud resta componente cruciale per le aziende che desiderano sfruttare al meglio le potenzialità della trasformazione digitale. Marini: “NetApp ha sviluppato una strategia congiunta con i public cloud service provider, puntando su un approccio hybrid multicloud per consentire alle aziende di gestire i dati ovunque si trovino”. Questa strategia oggi poggia su un’integrazione profonda con i principali hyperscaler: Azure, Google e Aws.

Una tra le principali innovazioni presentate riguarda Azure NetApp Files (Anf). Permette alle aziende di sfruttare le capacità storage avanzate di NetApp direttamente all’interno dell’infrastruttura di Azure. Precisa Patano: “Consente di combinare performance e scalabilità tipiche del cloud con le funzionalità enterprise di NetApp, come la gestione avanzata dei dati e la protezione contro i ransomware”. Concretamente una delle caratteristiche più interessanti di Anf è la possibilità di fare tiering automatico, spostando i dati meno utilizzati su soluzioni di storage più economiche all’interno di Azure, riducendo così i costi complessivi senza compromettere le performance. “Questo tipo di integrazione con Azure dimostra anche quanto sia profonda la collaborazione con l’hyperscaler, che non si limita a vendere hardware come servizio, ma consente a NetApp l’integrazione piena con l’ecosistema Azure per offrire ai clienti un’esperienza fluida e ottimizzata”. Torna ancora il tema delle possibilità di replica e failover: “Abbiamo introdotto la possibilità di fare replica cross-zone su Anf, permettendo alle aziende di replicare i dati su diverse regioni di Azure per garantire la massima resilienza”, ha spiegato Patano. Questa funzionalità è particolarmente importante per i clienti enterprise che hanno bisogno di mantenere operativi i propri servizi anche in caso di disastri o interruzioni. La replica a livello di storage, anziché a livello di software, garantisce prestazioni superiori e una maggiore affidabilità, riducendo i tempi di ripristino e assicurando che i dati siano sempre disponibili quando necessario.

Per quanto riguarda invece la collaborazione con Google Cloud, con il servizio Google Cloud NetApp Volumes, è ora possibile configurare volumi di storage in modo granulare, partendo da un solo Gigabyte fino a interi Petabyte. Patano: “Google Cloud NetApp Volumes offre una flessibilità che poche altre soluzioni cloud possono garantire, permettendo di adattare le risorse di storage alle necessità specifiche di ogni cliente, dal piccolo sviluppatore alla grande azienda”. Anche in questo caso, è possibile attivare il tiering automatico, spostando i dati meno utilizzati su Google Cloud Storage, riducendo i costi complessivi e ottimizzando l’uso delle risorse.

Per le aziende che desiderano sfruttare le capacità di NetApp senza dover investire in hardware proprietario, Cloud Volumes Ontap rappresenta poi una soluzione ideale. Questo servizio permette di utilizzare il sistema operativo Ontap come soluzione software defined all’interno degli hyperscaler, sfruttando l’infrastruttura cloud di Aws, Azure o Google per creare ambienti di storage flessibili e scalabili. Davide Marini: “E’ come poter beneficiare della stessa esperienza e delle stesse funzionalità che si avrebbero con una soluzione on-premise, ma con la flessibilità e la scalabilità del cloud”. Ed una delle caratteristiche più apprezzate è la possibilità di implementare policy di sicurezza avanzate, come la protezione anti-ransomware e la creazione di volumi non riscrivibili, garantendo un livello di sicurezza tipicamente non disponibile sulle piattaforme cloud standard.

BlueXP, matura la piattaforma unificata di gestione dati

La crescente complessità delle infrastrutture IT e la necessità di gestire dati distribuiti su cloud e ambienti on-premise richiedono strumenti di gestione avanzati e integrati. Per rispondere a questa esigenza, NetApp ha già sviluppato BlueXP, piattaforma unificata che permette alle aziende di monitorare e gestire in modo centralizzato tutte le risorse di storage, migliorando l’efficienza operativa e la sicurezza. In occasione di NetApp Insight 2024 sotto la lente la sua evoluzione che la qualifica – come spiega Patano – “come un’unica console di gestione che fornisce ai clienti una visione completa delle loro risorse di storage, permettendo loro di prendere decisioni informate e di automatizzare operazioni complesse”. Un approccio che semplifica la gestione delle infrastrutture IT, riducendo il carico di lavoro per gli amministratori e migliorando la reattività alle esigenze aziendali.

Tra le principali funzionalità di BlueXP vi è l’automazione degli aggiornamenti e della gestione delle vulnerabilità. “Con BlueXP, i clienti possono pianificare e automatizzare gli aggiornamenti delle loro soluzioni di storage, identificare eventuali vulnerabilità e ricevere raccomandazioni proattive su come migliorare la sicurezza e l’efficienza”, spiega Patano. Questo sistema permette di mantenere sempre aggiornate le infrastrutture, riducendo il rischio di problemi legati a versioni obsolete o a configurazioni non ottimali. BlueXP fornisce inoltre suggerimenti su come ottimizzare l’uso delle risorse. Ad esempio, se una determinata soluzione di storage sta raggiungendo il limite delle sue capacità, la piattaforma può suggerire di migrare parte dei dati su una soluzione più performante, come un sistema flash, per migliorare le performance e ridurre i tempi di risposta. “Si parla quindi di raccomandazioni proattive con cui gli utenti migliorano l’efficienza delle loro infrastrutture senza dover necessariamente investire in nuove risorse”.

BlueXP non si limita alla gestione delle risorse di storage on-premise, ma offre anche un controllo completo sulle soluzioni cloud. “Con BlueXP, i clienti possono monitorare e gestire tutte le loro risorse di storage, sia locali che cloud, da un’unica interfaccia, semplificando la gestione e migliorando la visibilità” ed un esempio di questa integrazione è la possibilità di visualizzare e gestire i volumi di storage cloud di NetApp, come Anf e Google Cloud NetApp Volumes, direttamente all’interno di BlueXP. Così si monitora l’uso delle risorse, si impostano policy di sicurezza e si automatizzano operazioni come il tiering dei dati, da un’unica interfaccia. L’integrazione con l’Autonomous Ransomware Protection, che utilizza l’intelligenza artificiale per monitorare l’attività sui volumi di storage e rilevare eventuali comportamenti sospetti, permette di rilevare e bloccare in tempo reale attività anomale, garantendo che i dati siano protetti contro minacce come il ransomware. E’ prevista anche la possibilità di gestire le chiavi di cifratura in modo centralizzato, permettendo ai clienti di proteggere i dati sensibili con facilità. Inoltre, grazie a strumenti avanzati di auditing e monitoraggio, è possibile tenere traccia di tutte le attività svolte sui dati, garantendo la conformità alle normative e alle policy aziendali.

Un passo ulteriore in avanti è quello segnato da BlueXP Workload Factory, un servizio che facilita la migrazione dei workload tra diversi ambienti. Questo strumento è particolarmente utile per le aziende che desiderano spostare applicazioni e dati da ambienti on-premise a cloud, o tra diversi provider di cloud, come Aws e Azure. “BlueXP Workload Factory analizza i workload esistenti, identifica le soluzioni cloud più adatte e fornisce una roadmap dettagliata per la migrazione, riducendo al minimo i tempi di inattività e i rischi”, spiega Patano. Si parla di un servizio che supporta anche la migrazione di workload complessi come Sap e Vmware, offrendo strumenti specifici per la pianificazione e l’esecuzione della migrazione. Infine, BlueXP supporta ora anche la gestione dei dati ad oggetti attraverso l’integrazione con Storage Grid, la soluzione di object storage di NetApp. E’ possibile quindi definire policy di gestione avanzate, come il tiering automatico tra diversi livelli di storage e la replica dei dati tra diverse location, senza perdere le caratteristiche di disponibilità e protezione volute. Inoltre, grazie a strumenti di analisi e reporting integrati, è possibile monitorare l’uso delle risorse e identificare opportunità di ottimizzazione.

Tra gli aspetti più apprezzati di BlueXP vi sono l’apertura e la flessibilità. La piattaforma supporta infatti l’integrazione con diverse soluzioni di terze parti, come strumenti di monitoraggio e gestione IT, permettendo ai clienti di personalizzare l’ambiente di gestione in base alle loro specifiche esigenze. Dettaglia Patano: “BlueXP è progettato per essere un hub di gestione centrale, ma non isolato e i clienti possono integrare le loro soluzioni preferite e utilizzare BlueXP come punto di riferimento per tutte le loro operazioni di gestione e sicurezza”. Questa apertura consente alle aziende di mantenere le proprie scelte tecnologiche esistenti e di aggiungere nuove funzionalità senza dover rivoluzionare le proprie infrastrutture. Inoltre, la possibilità di testare gratuitamente molte delle funzionalità di BlueXP per un periodo limitato permette alle aziende di valutare l’efficacia della piattaforma prima di impegnarsi in un investimento a lungo termine. “Ora stiamo lavorando per offrire ai nostri clienti strumenti ancora più sofisticati per la gestione dei loro dati, integrando funzionalità di intelligenza artificiale e machine learning per migliorare ulteriormente l’efficienza e la sicurezza”, chiude sul tema Patano.

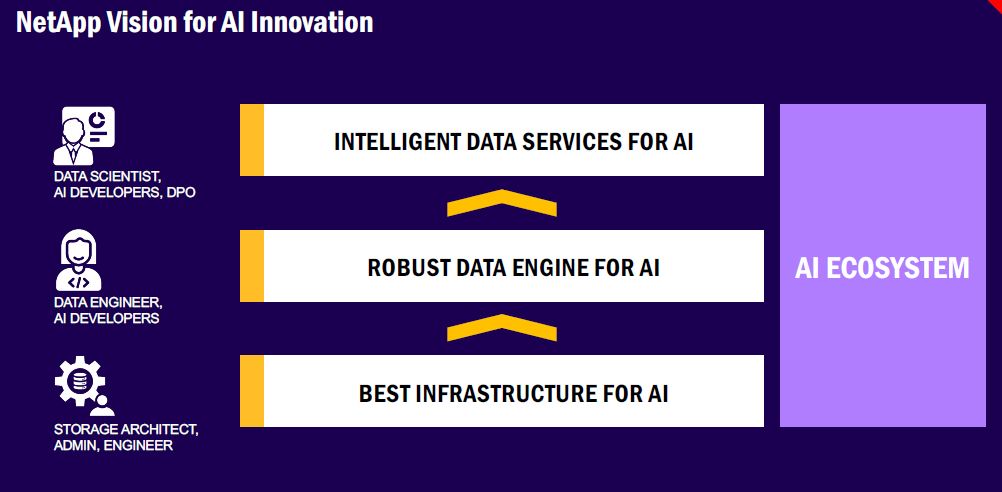

La visione di NetApp per il futuro dell’AI

L’intelligenza artificiale (AI) trasforma il modo in cui le aziende operano e interagiscono con i dati e NetApp riconosce il potenziale di questa tecnologia e per questo sviluppato una strategia articolata a supporto dell’adozione e dell’implementazione dell’AI nelle imprese. Davide Marini: “C’è tanta curiosità e voglia di adottare l’intelligenza artificiale, ma le competenze e gli strumenti disponibili sono ancora limitati. Il nostro obiettivo è semplificare e rendere più accessibile l’implementazione di progetti AI nelle aziende, garantendo una maggiore probabilità di fare bene”.

NetApp sta lavorando per creare un’infrastruttura che supporti efficacemente i progetti con l’AI. Spiega Patano: “La quantità di dati che le aziende devono gestire per supportare progetti di intelligenza artificiale è in continua crescita, e le performance richieste sono sempre più elevate”. Per questo NetApp introduce l’idea Global Metadata Namespace. Questa tecnologia consente di creare uno spazio dei metadati distribuito, permettendo alle aziende di analizzare i dati ovunque essi si trovino, senza la necessità di spostarli fisicamente in un’unica location. “Global Metadata Namespace consente di gestire e accedere ai dati in modo distribuito, replicando solo i metadati e non i dati effettivi. Questo approccio riduce significativamente l’occupazione di spazio e la necessità di banda per la replica dei dati, permettendo alle aziende di sfruttare tutte le loro risorse di storage in modo più efficiente”.

E’ di fatto un cambiamento radicale rispetto alle pratiche tradizionali di gestione dei dati, in cui l’accesso e l’analisi richiedono spesso la centralizzazione delle informazioni perché con Global Metadata Namespace, le aziende possono analizzare e gestire i dati in tempo reale, riducendo i costi e migliorando la reattività. L’idea ha bisogno dello sviluppo di un nuovo componente denominato Data Engine, specificamente progettato per supportare le applicazioni di intelligenza artificiale. Questo motore di dati utilizza la tecnologia SnapDiff, una funzione proprietaria di NetApp basata su snapshot, per rilevare e tracciare le minime modifiche ai blocchi di dati, consentendo di identificarle rapidamente e aggiornare i modelli di machine learning in tempo reale. “Il Data Engine permette di alimentare le applicazioni di intelligenza artificiale con i dati più aggiornati, riducendo i tempi di elaborazione e migliorando l’accuratezza dei modelli”. Questo sistema è quindi in grado di elaborare grandi volumi di dati e di generare in tempo reale i metadati necessari per l’addestramento dei modelli, ottimizzando così il processo di analisi e migliorando le prestazioni complessive.

Oltre all’infrastruttura hardware e ai tool di gestione dei dati, NetApp offre anche una serie di servizi di intelligenza artificiale integrati, pensati per facilitare l’adozione di queste tecnologie nelle aziende. “Stiamo investendo nello sviluppo di servizi che permettano alle aziende di analizzare e interpretare i loro dati in modo più intelligente, fornendo strumenti che semplificano l’implementazione di modelli di AI e migliorano la qualità dei risultati”, puntualizza quindi Marini. Questi servizi includono strumenti di data exploration, che utilizzano modelli di linguaggio naturale per permettere agli utenti di interagire con i dati in modo intuitivo, e strumenti di analisi predittiva, che aiutano a identificare tendenze e pattern nascosti nei dati aziendali.

Un aspetto fondamentale della strategia di NetApp per l’intelligenza artificiale è la collaborazione con Nvidia. Le soluzioni Ontap AI di NetApp, certificate da Nvidia, combinano la potenza delle Gpu Nvidia con la flessibilità e l’efficienza delle soluzioni di storage NetApp, a generare una piattaforma ottimizzata per l’AI. “Ontap AI offre prestazioni ottimizzate per i progetti di intelligenza artificiale, grazie a un’architettura scalabile che può essere adattata alle esigenze specifiche di ogni cliente. Questa soluzione permette di sfruttare al massimo la potenza delle Gpu Nvidia, garantendo che i modelli di AI possano essere addestrati ed eseguiti nel modo più efficiente possibile”, spiega Patano. L’integrazione tra Ontap e le Gpu Nvidia consentono quindi di gestire in modo ottimale i carichi di lavoro AI, riducendo i tempi di training e migliorando la scalabilità delle applicazioni. Chiude Marini: “L’intelligenza artificiale è un viaggio, e noi siamo qui per accompagnare i nostri clienti lungo questo percorso, fornendo loro gli strumenti e il supporto di cui hanno bisogno per raggiungere i loro obiettivi”.

© RIPRODUZIONE RISERVATA