Oggi i servizi di Aws e l’infrastruttura proposti sono qualificati anche dall’Agenzia per la Cybersicurezza Nazionale come idonei (qualifica di livello QI2-QC2) per essere utilizzati dalle aziende private come dalle pubbliche amministrazioni. “Soddisfano più di 360 requisiti e sono pensati per permettere all’Italia di continuare a crescere con cloud e AI in un momento, quello attuale, di sfide e cambiamenti che, come tali, vedono spesso nascere anche nuove opportunità”. Per Groues è quindi tempo di “reinventare il futuro, perché quanto vediamo ora di realizzato con l’AI è solo la punta dell’iceberg, e siamo davvero di fronte a un cambiamento epocale, non solo nel modo di lavorare”.

L’Italia è un po’ indietro, rispetto ad alcuni Paesi europei, ma certo non arranca. Nel 2023, il 23% delle aziende ha già utilizzato in qualche forma l’AI (+28% rispetto all’anno precedente), un boost per l’economia valutato in circa 329 miliardi, entro il 2030. Soprattutto oltre l’80% delle aziende che ha adottato l’AI dichiara di aver ottenuto importanti miglioramenti in efficienza ed il 75% di aver semplificato in modo significativo i processi. “L’AI quindi rappresenta davvero uno stimolo per l’innovazione e porta vantaggi a realtà di ogni dimensione e settore: finance, assicurazioni, manifatturiero, sanità e PA”.

Il Gruppo 24 Ore a sua volta, sempre con Amazon Bedrock, e le Generative AI su Aws ha fatto evolvere uno dei più conosciuti e apprezzati servizi, l’Esperto Risponde. Lo ha fatto con un assistente virtuale in grado di comprendere il complesso linguaggio del settore fiscale per fornire, sotto la guida dei propri operatori, risposte tempestive e precise grazie all’utilizzo esclusivo della propria base dati, per cui è stata raggiunta una qualità delle risposte simile a quelle umane con un’accuratezza del 90%. Prosegue Groues: “E’ vero però anche che se le imprese italiane stanno accogliendo con entusiasmo l’idea di utilizzare strumenti di AI – e anche se sono chiari i benefici che queste tecnologie possono generare – l’adozione dalla parte delle aziende è in ritardo rispetto alla media europea”.

Prende il timone dell’evento Becky Weiss, VP, distinguished engineer Aws: “Rivoluzione industriale, rivoluzione digitale (con pc e device) e poi Internet ed il cloud sono tappe fondamentali la cui importanza solo ora, con una certa distanza, riusciamo a comprendere”. Aws ha avuto un ruolo fondamentale nel trasformare il potenziale di networking, storage, database e dell’elaborazione dei dati, con il cloud, eliminando la necessità per i clienti di gestire infrastrutture e data center. “Oggi propone più di 200 servizi in 33 region diverse. Tra questi con Aws Lambda, circa dieci anni fa, l’azienda ha dato il via alla rivoluzione serverless”. Ora è percepibile come la distanza tra ideazione e innovazione sia sempre più breve. “Soprattutto, è possibile interpretare i dati ed interagire con essi in modo nuovo e l’intelligenza artificiale generativa offre alle applicazioni la possibilità di risolvere i problemi in modo nuovo”.

L’esperienza di Aria

Risolvere i problemi in modo nuovo è alla base dell’esperienza di Aria. Ne parla così Lorenzo Gubian, direttore generale. “Siamo il motore tecnologico di Regione Lombardia. Circa 500 professionisti, con un valore di produzione annuo di 450 milioni di euro. E proprio nell’ambito della digitalizzazione dei processi operiamo in una vasta area di settori, non solo sanità, ma anche istruzione, lavoro, agricoltura e collaboriamo con 16 diverse direzioni generali di Regione Lombardia erogando più di 600 servizi a 10 milioni di abitanti”. Quando Aria decide di intraprendere questo percorso verso il cloud nel 2020 ha quattro data center on-prem con più di 4.000 macchine virtuali. “Il nostro obiettivo era quello di poterci focalizzare sull’innovazione dei processi e per riuscire sapevamo che avremmo dovuto dotarci di un’infrastruttura moderna, robusta, flessibile e scalabile”. L’azienda coglie quindi l’opportunità di un finanziamento specifico del Pnrr ed estende il perimetro di azione sui 40 data center delle aziende sanitarie che ospitano più di 10.000 macchine virtuali. E li porta nel cloud di Aws. Entro la fine del 2024 avrà terminato il percorso.

“Solo per citare alcuni dei principali workload che abbiamo portato nei cloud: il Fascicolo sanitario elettronico, la piattaforma dell’agricoltura che segue anche tutte le attività produttive correlate, il sistema di bandi online di Regione Lombardia che distribuisce ogni anno centinaia di milioni al tessuto economico della regione, e oltre 500 milioni di transazioni all’anno di ricerca”, prosegue Gubian. Una mole di lavoro importante se si pensa alla migrazione in cloud di oltre 600 servizi diversi, sviluppati e implementati in anni diversi, su un numero di infrastrutture ed eterogeneità notevoli. “Aria utilizza oggi più di 40 servizi Aws e grazie ai Migration Services e ai Discovery Services ha già migrato più di 8.700 macchine virtuali. Entro la fine dell’anno arriveremo a una cifra di circa 14.000 VM“. Sono stati inoltre innovati diversi applicativi: flessibilità e scalabilità, ma soprattutto l’accelerazione dei tempi sono gli elementi che hanno contraddistinto i progetti, insieme alla riduzione dei costi ed all’incremento delle performance. Chiude Gubian: “Aver modernizzato l’infrastruttura è solo il primo passo, che oggi consente di focalizzarci sul nostro vero obiettivo che è quello di migliorare i servizi, che è quello di migliorare l’esperienza dei nostri utenti”.

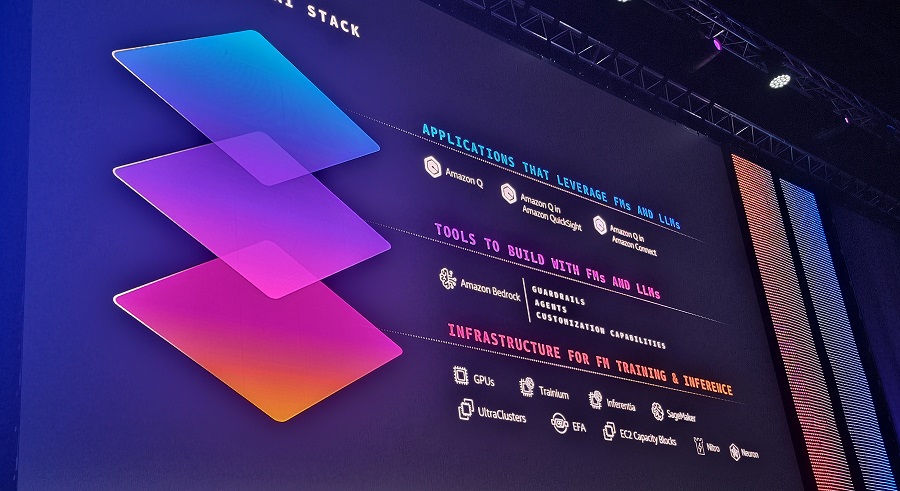

Aws e AI, un modello su tre livelli

“Compiere nuovi passi avanti sfruttando il potenziale dell’AI generativa resta una sfida – riprende Weiss -. Per questo Aws ha implementato una serie di servizi appositamente progettati per aiutare le aziende a compiere questo salto, semplificando l’utilizzo di AI generativa personalizzata sulla base dei dati specifici di ogni azienda”. Quello proposto è un modello su tre livelli. Nello strato inferiore dello stack si trova l’infrastruttura utilizzata per addestrare modelli linguistici di base o di grandi dimensioni ed eseguirli in produzione. Il livello intermedio fornisce l’accesso ai modelli di cui si ha bisogno, nonché agli strumenti per creare, scalare e distribuire applicazioni di intelligenza artificiale generativa. E al livello più alto ci sono applicazioni che sono esse stesse costruite su foundation model e large language model, in modo da poter sfruttare l’intelligenza artificiale generativa senza nemmeno la necessità di acquisire competenze specializzate.

Training e inferenza sono i carici di lavoro principali su cui si basano i progetti con l’AI. Il training serve a creare e aggiornare modelli e migliorare questi modelli, l’inferenza utilizza questi modelli per generare testo, immagini o video. “Aws è impegnata a migliorare queste capacità con Amazon Sagemaker, ma anche con un’infrastruttura all’altezza per potenza di calcolo necessaria, che utilizza il potenziale delle Gpu di Nvidia e che allo stesso tempo contribuisce alla crescita del potenziale di quell’azienda considerato che quando Nvidia ha voluto costruire il suo supercomputer ha scelto per il suo progetto come partner proprio Aws” . Negli ultimi cinque anni, l’azienda ha inoltre investito sullo sviluppo di componenti di silicio personalizzate, proprio per ridurre i costi del machine learning e della formazione dei modelli (Aws Inferentia e Aws Trainium).

A caratterizzare l’approccio di Aws per l’AI è Amazon Bedrock piattaforma pensata per creare e scalare applicazioni di intelligenza artificiale generativa con Llm e foundation model, nel modo più semplice. In particolare si parla di un servizio completamente gestito che offre la scelta di foundation model ad alte prestazioni di diverse aziende tra cui per esempio Anthropic, Meta, Mistral, etc. tramite un’unica Api.

L’esperienza di Iveco

Tra i clienti italiani che sfruttano il potenziale delle soluzioni Aws ed i diversi servizi ‘predittivi’ anche Iveco. Ne abbiamo parlato in un contributo dedicato, ma in occasione di Aws Summit, Marco Liccardo, Cto e digital officer di Iveco Group, torna sul tema ed offre ancora un paio di spunti interessanti: “Gli ultimi cinque anni sono stati caratterizzati da cambiamenti importanti e in qualche caso anche imprevedibili, perché siamo entrati nella fase della non linearità. La non linearità a cui mi riferisco riguarda cambiamenti climatici, sempre più estremi, un quadro normativo, soprattutto in Europa, in continua evoluzione, la richiesta di personalizzazioni sempre più marcate da parte dei nostri clienti. E non ultimo, innovazioni esponenziali in ogni ambito. Si pensi oggi allo sviluppo sui motori a idrogeno, sui veicoli elettrici, sui veicoli ibridi”. La domanda è come riuscire a continuare a competere a fronte di una crescente complessità. “E proprio l’innovazione tecnologica è tra le risposte. La nostra roadmap in questo senso si basa su tre pilastri: il primo, è l’azzeramento delle emissioni nette di CO2 entro il 2040; il secondo, l’introduzione dell’intelligenza artificiale dei software defined vehicles per proporre customizzazioni sempre più spinte e in tempi sempre più rapidi per i nostri clienti. E l’ultimo è la guida autonoma per migliorare la sicurezza e l’efficienza dei trasporti”.

Caratterizzante l’aspetto che riguarda l’utilizzo dell’AI, proponiamo la riflessione di Liccardo riguardo l’evoluzione di Driver Pal 3.0 in grado di informare l’autista attivamente su tutto ciò che è importante, come le condizioni del traffico, gli incidenti lungo il percorso, le condizioni meteorologiche, e i problemi del veicolo grazie ad un sistema completamente integrato all’interno del veicolo.

Oggi il sistema si basa sulle possibilità di interazione in linguaggio naturale, con il supporto multilingue, mentre per quanto riguarda la guida autonoma prosegue il percorso di piena automazione dei modelli. Vengono elaborati dai sistemi enormi quantità di dati, parte di essi viene poi inviata al cloud per consentire un affinamento e un miglioramento continuo e costante degli algoritmi così da migliorare il riconoscimento di ostacoli edei veicoli lungo il percorso. Si tratta di use case per i quali l’AI giocherà un ruolo chiave ora, proprio a partire dalla valorizzazione di questi dati. “Ci immaginiamo – chiude Liccardo – Un ecosistema di veicoli iperconnessi, verdi, in parte autonomi, che siano in grado di comunicare tra di loro e comunicare con l’infrastruttura, aprendo di fatto la strada a nuovi modelli di business as a service. È chiaro che questo porterà ai cambiamenti importanti delle organizzazioni, sia sui modelli di business, sia su quelli operativi”.

Amazon Q, aiuti per gli sviluppatori

Becky Weiss, riprende il filo della proposizione tecnologica, degli strumenti facilitatori per utilizzare l’AI generativa anche quando non si dispone di competenze specifiche in particolare per il machine learning. Si parla quindi di Amazon Q come proposta di un assistente generativo basato sull’intelligenza artificiale su misura che dispone di molteplici aree di competenza calibrate per soddisfare le diverse esigenze, i diversi tipi di utenti e ruoli all’interno della tua organizzazione”. Per gli sviluppatori Amazon Q può trasformare le modalità di “building in ogni fase del ciclo di vita dello sviluppo”. Per esempio come assistente alla console di gestione degli Ide (ambienti di sviluppo integrati). Un esempio: a fronte del necessario utilizzo di un portale scritto in Java per inviare, rivedere e cercare documenti di ricerca – allorquando manchino metadati accurati e i documenti siano di difficile categorizzazione – l’AI generativa è in grado di implementare queste funzionalità per esempio attraverso la generazione di una funzione Lambda che invierà questi documenti ad Amazon Bedrock, che sarà così in grado di riassumere e aggiungere tag necessari. Ma Amazon Q, utilizzato all’interno dell’Ide è in grado di fornire ulteriori preziosi aiuti, per esempio anche con le istruzioni passo passo su come implementare esattamente il codice per Amazon Bedrock, o su come velocizzare il testing per verificare quali foundation model siano più adatti ai propri progetti. Di fatto è proposto per ottenere risposte rapide e pertinenti a domande urgenti, risolvere problemi, generare contenuti e intraprendere azioni utilizzando i dati e le competenze presenti negli archivi di informazioni, nel codice e nei sistemi aziendali.

Lo strumento, di fatto pensato per gli sviluppatori, consente a Weiss di ribadire una focalizzazione chiara per Aws proprio su questo target, in particolare in Italia. “C’è una domanda in forte crescita per le tecnologie Aws qui in Italia. È per questo motivo che continuiamo ad offrire formazione gratuita a milioni di persone, con oltre 100 corsi e la disponibilità di risorse di apprendimento su intelligenza artificiale, machine learning e intelligenza artificiale generativa attraverso i programmi Aws Skills Builder e Aws Education. E la mia speranza è che coloro che beneficiano di questa formazione diventino membri attivi della nostra comunità”. Resta una domanda: “Quale magìa si vuole creare?”…

Aws Summit, focus sull’Italia

In Italia questa è una domanda che diverse aziende hanno già raccolto, come ci spiega Antonio D’Ortenzio, manager in Solutions Architecture di Aws, domanda che da una parte sottolinea lo scenario “numerico” ripreso nel keynote da Groues: “Sono numeri – spiega D’Ortenzio che incoraggiano sicuramente, ma soprattutto ci fanno sentire in linea anche rispetto agli obiettivi del decennio digitale che prevedono che entro il 2030 almeno il 75% delle aziende abbia adottato tecnologie come il cloud, i big data e l’intelligenza artificiale“.

Non solo, si parla oggi di un interesse in sostanza trasversale ai diversi verticali. “Alcuni vivono dei fattori di rallentamento dovuti alla regolamentazione, per cui sono meno agili (per esempio il finance) ma l’interesse che vediamo è esattamente lo stesso e stiamo cercando di assecondarlo e soprattutto di dare anche a questi clienti le giuste rassicurazioni affinché possano seguire un’adozione veloce e corretta”.

Un bisogno invece condiviso da tutte le aziende, anche le Pmi è la disponibilità di strumenti evoluti che permettano di semplificare il raggiungimento dei propri obiettivi. “Per Aws significa lavorare alla democratizzazione delle tecnologie complesse e in particolare dell’intelligenza artificiale, così che anche le aziende meno strutturate possano utilizzare i diversi servizi suddivisi concretamente nei tre layer”, spiegati da Weiss durante il keynote, e possano sfruttare il cloud in modo sostenibile. “Oggi un data center di Aws è fino a 5 volte più efficiente dal punto di vista energetico di un data center tipico dell’enterprise europea (fonte: 451 Research)“. Tutti i datacenter europei utilizzano il 100% di energie rinnovabili e Aws sta perseguendo l’obiettivo di avere tutto il proprio business alimentato da energie rinnovabili entro il 2025, con 5 anni di anticipo rispetto al previsto. “E’ possibile con tecnologie avanzate di raffreddamento degli ambienti, e costruendo in house i nostri chip che hanno un comportamento particolarmente efficace dal punto di vista energetico”. A questo tema si accompagna quello della sicurezza. Prosegue D’Ortenzio: “Sì, allora, il tema della sicurezza se riferita in generale al cloud è da sempre la nostra priorità. La cosa che possiamo dire con riferimento specifico all’intelligenza artificiale è che per nostra politica aziendale non riutilizzeremo mai i dati dei nostri clienti per addestrare i modelli terzi e rimetterli in commercio”.

I dati rimangono privati in uno spazio che soltanto il cliente utilizza insieme al modello messo a disposizione. “Gli unici dati che noi memorizziamo sono quelli che servono per le metriche operazionali oppure, se i clienti sviluppano il loro modello, ovviamente dobbiamo memorizzarlo per poterlo poi ospitare e mettere a disposizione, ma in quel caso mettiamo a disposizione del cliente la possibilità di criptare tutto, peraltro con le loro stesse chiavi”. E sul tema della sovranità del dato, chiude D’Ortenzio: “Abbiamo region il più possibile capillarmente distribuite in Europa e quindi se si sceglie come region di adozione Milano, i dati, anche quelli dell’intelligenza artificiale, saranno a Milano e rimarranno a Milano finché il cliente non deciderà di farci altro. Tutto ciò che è dato in transito è criptato di default vale anche in riferimento al nostro servizio principe che è Amazon Bedrock che non ha neanche un endpoint che non sia gestito col Tls”.

© RIPRODUZIONE RISERVATA