Tutto ruota attorno all’AI questa settimana, per diversi motivi, spunti vari.

Il primo è il passo significativo dell’Unione europea verso la definizione di una normativa che regoli in modo piu severo l’intelligenza artificiale (AI Act). Il secondo, la riflessione pubblicata da Avivah Litan, VP analyst di Gartner, sull’AI generativa che ne contempla i rischi ma anche l’imprescindibilità. Il terzo, il report del World Economic Forum sull’impatto dell’AI nel mondo del lavoro, inarrestabile. Il quarto (ma solo perché mi fermo qui… non certo l’ultimo), la valanga di annunci da parte dei big vendor dai palchi delle loro convention internazionali, che integrano l’AI nelle loro soluzioni – Ibm, Google o Oracle ad esempio -. Se non c’è AI non pare novità…

Tutti fatti che confermano il ritmo vertiginoso con cui cresce l’innovazione dell‘intelligenza artificiale generativa ma che rimarcano anche le preoccupazioni relative alla sicurezza e l’urgenza di regolamentazione che l’AI richiede.

Partiamo dal primo spunto.

1 – L’Unione europea ha finalmente fatto un passo significativo verso l’approvazione di una normativa che regoli gli strumenti di intelligenza artificiale: lo scorso giovedì (11 maggio) i legislatori hanno espresso un voto decisivo per concordare un disegno di legge più severo per governare l’AI, che verrà sottoposto al voto plenario del parlamento europeo entro giugno. L’attesissimo AI Act – dopo che i nuovi contenuti saranno discussi e finalizzati anche dalla Commissione Europea e dagli stati membri – dovrebbe essere la prima legislazione completa al mondo per disciplinare l’intelligenza artificiale, definendo nuove regole. “Un accordo delicato” secondo Dragos Tudorache, uno dei parlamentari incaricati a redigere l’atto (fonte Reuters), che richiede la ricerca di un accordo tra poli opposti, per classificare gli strumenti di AI in base al livello di rischio percepito, con obblighi diversificati per aziende e PA a seconda del rischio evidenziato. Non facile. “Siamo riusciti a trovare un compromesso che regolerebbe l’intelligenza artificiale in modo proporzionato, proteggendo i diritti civili e stimolando l’innovazione e l’economia”, precisa l’eurodeputata Svenja Hahn. Tra i paletti l’uso del riconoscimento facciale negli spazi pubblici, l’impiego di sistemi biometrici con dati sensibili (genere, razza, etnia, religione, orientamento politico) o sistemi di riconoscimento delle emozioni a disposizione di forze dell’ordine, datori di lavoro o istituzioni educative. O anche l’uso indiscriminato di dati biometrici presi da social media per creare database di immagini violando privacy e diritti umani, così come la regolamentazione degli strumenti di polizia predittiva con nuove misure di trasparenza alle applicazioni di intelligenza artificiale.

L’iter legislativo prevede che dopo l’approvazione della legge (che verrà sottoposta dal Parlamento al Consiglio dell’Unione europea e alla Commissione Europea) ci sarà un lasso di tempo di circa due anni per consentire alle aziende e alle pubbliche amministrazioni di conformarsi al nuovo regolamento. Ma la decisione è stata presa.

2 – Il secondo spunto è l’articolo di Avivah Litan, VP analyst di Gartner “Perché la fiducia e la sicurezza sono essenziali per il futuro dell’AI generativa”, scritto a valle della sospensione di ChatGpt in alcuni paesi (tra cui l’Italia e poi riabilitato).

“Lo sviluppo dell’AI generativa non si ferma. Le aziende devono formulare una strategia per gestire la fiducia, i rischi, la sicurezza dell’AI (AI TRiSM) ma c’è un urgente bisogno di una nuova classe di strumenti di AI TRiSM per gestire i flussi di dati e di processo tra utenti e aziende. Al momento non esistono strumenti standard sul mercato che offrano agli utenti garanzie sistematiche sulla privacy o un efficace filtraggio dei contenuti, ad esempio filtrando errori fattuali, allucinazioni, materiali protetti da copyright o informazioni riservate. Gli sviluppatori di intelligenza artificiale devono lavorare urgentemente con i responsabili politici, comprese le nuove autorità di regolamentazione che potrebbero nascere, per stabilire politiche e pratiche per la supervisione dell’AI generativa e la gestione del rischio”.

I rischi dell’AI generativa secondo Gartner sono diversi, a partire delle fake news (“allucinazioni“) perché i dati addestrati possono portare a risposte distorte e sbagliate, difficili da individuare dal momento che le risposte appaiono sempre più credibili e affidabili. Il deepfake, o la creazione di contenuti con intenti dannosi, costruiti partendo da immagini, video o registrazioni vocali falsi, utilizzati per attaccare organizzazioni, politici, celebrità con significativi rischi di reputazione, contraffazione o frode (esplicativo il deepfake dell’immagine di Papa Francesco generata dall’AI, che indossava un piumino alla moda, diventata virale sui social media). La privacy dei dati, perché i dipendenti possono facilmente esporre dati aziendali sensibili e proprietari quando interagiscono con soluzioni di chatbot di AI generativa e tali informazioni potrebbero anche cadere nelle mani sbagliate in caso di violazione della sicurezza. I problemi di copyright, dal momento che i chatbot di intelligenza artificiale generativa vengono addestrati su una grande quantità di dati presi dal Web, che possono includere materiale protetto da copyright, generando output che violano diritti o proprietà intellettuale. Infine, le preoccupazioni per la sicurezza informatica, aprendo nuove falle perché, sebbene i fornitori di AI addestrino i loro modelli per proteggere i sistemi, non forniscono agli utenti gli strumenti per “controllare” efficacemente tutti i “controlli” di sicurezza in atto.

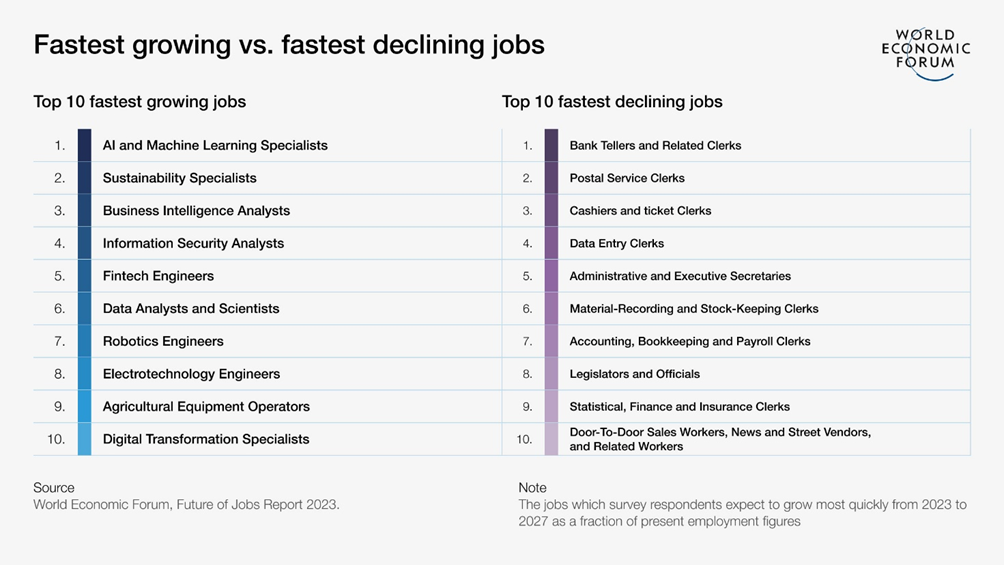

3 – Terzo spunto. Il Future of Jobs Report 2023 del World Economic Forum ha rilevato che l’AI generativa dovrebbe essere adottata da quasi il 75% delle aziende, e questo porterà conseguenze evidenti nel mondo del lavoro: alcuni ruoli impiegatizi diminuiranno rapidamente, mentre cresceranno altre figure specializzatesi su intelligenza artificiale, machine learning, analisti di dati, data scientist, trasformazione digitale. I progressi nell’AI generativa rappresenteranno così un punto di svolta anche per il mondo del lavoro e per l’istruzione, a cui dovranno rispondere governi, datori di lavoro, educatori, scuola e università. Bene tenere d’occhio la tabella del Wef, il su e giù a piè di pagina.

4 – Infine, gli annunci dei grandi vendor negli ultimi giorni (Ibm, Oracle, Google Cloud, Appian, Salesforce…). Non mi soffermo su ognuno di questi. Solo una considerazione. Non è una buzzword l’AI, uno slogan, proprio no. Dobbiamo abituarci, se qualcuno avesse ancora qualche dubbio.

© RIPRODUZIONE RISERVATA