Un paradosso caratterizza l’intero ecosistema dei progetti con l’AI. La fiducia nelle tecnologie AI cresce più velocemente della loro effettiva affidabilità. Il fenomeno, definito dagli analisti “trust dilemma”, riguarda il 46% delle organizzazioni nel mondo. Significa che quasi una su due mostra un disallineamento tra la percezione di fiducia e la capacità concreta di garantire sistemi trasparenti, spiegabili e governati. Lo dice la ricerca condotta a livello globale Data and AI Impact Report: The Trust Imperative, realizzato da Idc per Sas su un campione di 2.375 aziende in cinque macroregioni, fotografa un paradosso che attraversa l’intero ecosistema dell’intelligenza artificiale:

Nonostante il 78% delle aziende dichiari di “fidarsi completamente dell’AI”, solo il 40% ha realmente investito in pratiche e framework di governance per renderla dimostrabilmente affidabile. Questa distanza tra fiducia percepita e fiducia meritata si traduce in ritorni economici inferiori. Le aziende che integrano criteri di AI responsabile hanno infatti il 60% di probabilità in più di raddoppiare il Roi rispetto a chi trascura le misure etiche e di sicurezza. “Per il bene della società, delle imprese e dei lavoratori, la fiducia nell’AI è imprescindibile – spiega Bryan Harris, chief technology officer di Sas –. Per raggiungere questo obiettivo, l’industria deve migliorare il successo delle implementazioni, valutare criticamente i risultati e mettere le persone nelle condizioni di valorizzare al meglio la tecnologia”.

GenAI e Agentic AI, tra fiducia e controllo

I dettagli dello studio rivelano che l’AI generativa è oggi la tecnologia più diffusa e più creduta, con un tasso d’adozione dell’81% e un livello di fiducia quasi tre volte superiore rispetto al machine learning tradizionale. Il 48% dei rispondenti afferma di avere “completa fiducia” nella GenAI, il 33% nell’AI agentica e solo il 18% nelle forme predittive o di machine learning, considerate più tecniche ma meno “umane”.

La tendenza evidenzia un chiaro bias cognitivo: più un sistema appare interattivo, conversazionale o “simile all’uomo”, maggiore è la fiducia che ispira, anche a fronte di un’affidabilità inferiore. “Le forme di AI con interattività umana e familiarità – osserva Kathy Lange, research director Idc– sembrano incoraggiare una maggiore fiducia indipendentemente dall’accuratezza effettiva. La domanda che dobbiamo porci è se la GenAI sia considerata affidabile solo perché percepita come tale”.

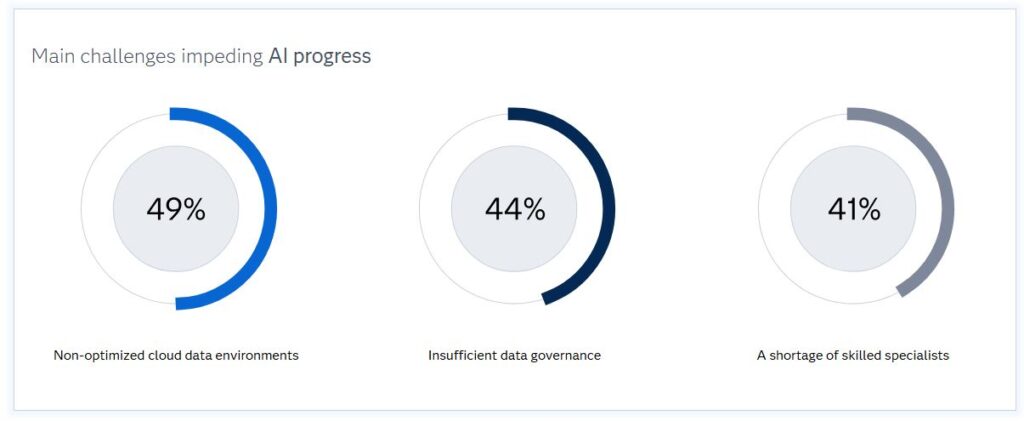

Questo squilibrio si riflette anche nelle preoccupazioni degli utenti: 62% teme per la privacy dei dati, 57% per la trasparenza e spiegabilità dei modelli, 56% per l’uso etico. In sostanza, la fiducia emotiva cresce, ma il controllo tecnico non la segue con la stessa velocità. Il quadro si complica ulteriormente con l’avvento dell’AI agentica, che secondo il 52% delle imprese è già in uso. Queste soluzioni, capaci di agire autonomamente in ambienti dinamici, impongono requisiti di governance più stringenti e infrastrutture dati più solide. Idc rileva che il 49% delle organizzazioni segnala ambienti cloud non ottimizzati, il 44% scarsa governance dei dati e il 41% carenza di specialisti AI come principali ostacoli alla scalabilità.

Ritorno degli investimenti e priorità

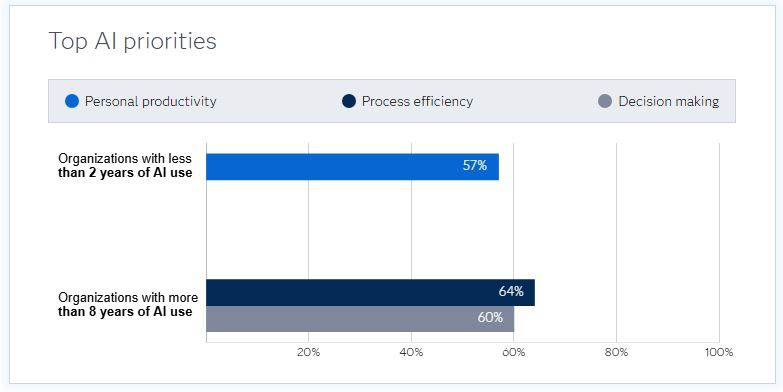

Sussiste una differenza significativa tra imprese mature e neofite nell’adozione dell’AI. Le prime, con oltre otto anni di esperienza, indirizzano gli investimenti verso l’efficienza dei processi (64%) e il supporto alle decisioni (60%), mentre i nuovi adottanti puntano ancora alla produttività individuale e al contenimento dei costi. Tuttavia, il risparmio si rivela il motore meno redditizio: è l’obiettivo più comune, ma genera il Roi più basso.

Le organizzazioni che usano l’AI per migliorare l’esperienza del cliente, ampliare la quota di mercato e rafforzare la resilienza del business ottengono invece ritorni mediamente superiori. A livello globale, solo un quarto delle aziende dispone oggi di un gruppo centralizzato dedicato alla governance dell’AI, ma la tendenza è in crescita: 57% prevede di aumentare moderatamente gli investimenti in AI responsabile e un ulteriore 25% in modo significativo, con focus su competenze etiche, compliance e capacità di spiegabilità dei modelli.

Trust e impatti, le nuove metriche

Per misurare il legame tra fiducia e risultati, Idc e Sas introducono allora due nuovi indicatori: il Trustworthy AI Index, che valuta quanto un’organizzazione ha investito in pratiche di AI responsabile, e l’Impact Index, che misura i benefici concreti generati (produttività, innovazione, efficienza, ritorni finanziari). Ne emerge una mappa globale che colloca l’Italia a metà classifica, con 2,73 punti su 5 per la fiducia dimostrabile e 3,01 per l’impatto. Le performance più equilibrate si registrano in Irlanda, Australia e Nuova Zelanda, dove governance e ritorni procedono di pari passo. Al contrario, alcuni Paesi ottengono risultati di business elevati senza solide basi di fiducia, esponendosi a rischi reputazionali e regolatori. Come osserva Chris Marshall, vice president Idc per Data, Analytics e AI, “solo il 40% delle imprese ha investito per rendere i sistemi realmente affidabili. Il resto continua a operare sulla percezione, non sulla dimostrazione. È il classico caso in cui l’entusiasmo per l’AI precede la capacità di governarla”.

L’analisi settoriale mostra poi un mosaico di maturità e di atteggiamenti verso la fiducia. Le banche risultano le più avanzate nella costruzione di framework di AI affidabile: il 23% opera ai livelli più alti del Trust Index, ma quasi la metà resta prigioniera di un approccio prudente che rallenta l’innovazione. Le principali sfide riguardano la governance dei dati (45%), la carenza di competenze specialistiche e l’assenza di metriche di valutazione univoche. Le assicurazioni, pur mostrando un atteggiamento moderatamente fiducioso, mantengono i livelli di maturità più bassi. Qui le priorità si concentrano su formazione e reskilling, mentre i piani di investimento futuri risultano contenuti. Il settore pubblico evidenzia il gap più critico tra fiducia percepita e fiducia meritata: il 46% delle amministrazioni ricade nel trust dilemma, spesso con un eccesso di confidenza in sistemi non pienamente affidabili. L’AI è utilizzata per migliorare processi e produttività, ma le basi dati restano frammentate e la governance insufficiente. Nel comparto lifescience, infine, la fiducia convive con un alto livello di complessità. Le aziende biopharma e di ricerca sono le più mature per data infrastructure, ma anche le più esposte al rischio di overreliance, cioè di eccessiva fiducia in modelli non ancora pienamente validati. Quasi metà delle organizzazioni del settore rientra in questa categoria, segno che la velocità dell’innovazione supera spesso i tempi della regolazione.

Quantum AI e fiducia algoritmica

Sul fronte delle tecnologie emergenti, la Quantum AI guadagna consensi prima ancora di disporre di un mercato maturo. Un quarto dei dirigenti afferma di fidarsi di questa tecnologia, nonostante le applicazioni siano ancora sperimentali e limitate ai laboratori di ricerca. L’interesse è concentrato su ambiti come finanza, logistica, cybersecurity e modellazione climatica, dove la potenza del calcolo quantistico promette di accelerare l’addestramento dei modelli. Per Sas e Idc, questa fase richiede però un approccio prudente. “C’è un rischio evidente di fidarsi troppo presto di sistemi che non sono ancora pienamente comprensibili – avverte Neil Ward-Dutton, VP AI & Automation di Idc –. La fiducia non può basarsi sull’hype, ma sulla solidità delle basi dati e sulla trasparenza del ciclo di vita dei modelli”. Di fatto, solo costruendo sistemi trasparenti, sicuri e responsabili le imprese possono colmare il divario di fiducia e liberare il pieno potenziale dell’AI: tra fiducia percepita e fiducia dimostrata, il vantaggio competitivo delle aziende dipende da quanto sapranno rendere la propria intelligenza artificiale davvero “trusty”.

© RIPRODUZIONE RISERVATA