Approfondire trend ed opportunità nel campo dell’intelligenza artificiale integrata con l’high performance computing è il tema al centro dell’evento di E4 Computer Engineering – AI & Hpc Reshaping the Business Landscape – che vuole mettere a fuoco allo stesso tempo lo stato delle attività dell’azienda in modo trasversale rispetto alle tematiche tecnologiche ed alle pratiche oggi in uso da imprese, università e centri di ricerca. Ne parla Cosimo Damiano Gianfreda, Ceo di E4. “In questa fase ancora più competitiva rispetto al passato anche per chi si occupa di tecnologie e dell’innovazione, le aziende emergono non solo per la qualità dei prodotti che offrono, ma anche per la capacità di anticipare le tendenze e definire nuovi standard e di attrarre talenti. Questo è anche il nostro obiettivo”

L’azienda oggi è riconosciuta come attore di riferimento nel settore dell’high-performance computing (Hpc), dei sistemi di raffreddamento a liquido e dell’intelligenza artificiale, lungo un percorso che l’ha vista già nel 2005 consegnare il primo sistema di storage al Cern, passaggio che ha segnato l’inizio di una lunga collaborazione che vede oggi ancora la partecipazione di E4 a Cern OpenLab.

Tra le sfide principali che E4 si trova ad affrontare c’è il crescente interesse per l’intelligenza artificiale delle aziende.

“Il 92% di esse si trova in una fase di riflessione strategica: cosa fare con l’AI? Quali sono le soluzioni migliori per integrarla nei propri modelli di business?” Ed E4 vuole offrire le soluzioni che consentono alle aziende di ottenere il massimo vantaggio competitivo, “perché molte aziende stanno ancora cercando di comprendere come utilizzare al meglio queste tecnologie per potenziare la propria attività – spiega Gianfreda -. Ed è questo il contesto entro cui ci troviamo ad operare” sulla base di un’esperienza che ha visto l’azienda maturare anche attraverso le tappe della realizzazione del supercomputer Franklin per l’Istituto Italiano di Tecnologia e la capacità di integrare tecnologie avanzate proprio per soddisfare le esigenze reali sul campo. Si pensi anche alla collaborazione con l’Ecmwf (Centro europeo per le previsioni meteorologiche a medio termine) presso il Tecnopolo di Bologna, dove E4 ha implementato i sistemi di raffreddamento a liquido “oggi una componente fondamentale delle infrastrutture IT avanzate, perché permette di ridurre i costi energetici e migliorare l’efficienza dei sistemi”.

La value proposition di E4

Una delle caratteristiche distintive di E4 è proprio la capacità di integrare e implementare le tecnologie più avanzate in maniera semplice e accessibile per i clienti, possibile solo quando si riesce ad essere “collante di talenti ed eccellenze”. L’approccio di E4 è quello di “fornire soluzioni su misura, partendo dall’analisi dei requisiti del cliente e accompagnandoli in tutte le fasi, dal progetto iniziale al supporto post-vendita”. E4 già nel 2017 ha intuito come AI e quantum computing sarebbero diventate, insieme, tecnologie chiave. Con E4 attiva già in diversi progetti quantum a livello europeo. “Resta al centro il nostro ruolo di system integrator con la capacità di aggregare componenti e soluzioni provenienti da diversi fornitori, in questo senso siamo in grado di offrire ai clienti le migliori soluzioni disponibili sul mercato. Questo approccio flessibile permette all’azienda di rispondere rapidamente alle esigenze dei clienti e di adattarsi alle nuove tecnologie emergenti”, chiude Gianfreda.

La proposition di E4 Computer Engineering poi oggi è affiancata da quella di E4 Analytics. Ne parla Mario Rosati, il Ceo: “Abbiamo fondato questa azienda come sister company di E4 con l’obiettivo di creare sinergie per valorizzare i sistemi prodotti da E4. In un momento in cui i principali casi d’uso aziendali del machine learning richiedevano una potenza di calcolo nel complesso ancora limitata si era intuito che il settore avrebbe richiesto strumenti sempre più complessi ed una maggiore capacità di orchestrare framework e piattaforme“.

Secondo Rosati, proprio il processo che va dalla gestione dei dati alla messa a punto dei modelli in produzione richiede strumenti specifici, e gestire questa complessità è difficile. Per questo “l’obiettivo è quello di semplificare la complessità per liberare il potenziale delle tecnologie AI e della GenAI”. Tra gli esempi, Urania, una piattaforma nativa cloud pensata per lo sviluppo e la produzione di progetti AI, dedicata agli AI experts che permette a data scientist e machine learning engineer di ideare, sviluppare e mettere in produzione i modelli di intelligenza artificiale, offrendo un ambiente di lavoro integrato orchestrato con Kubernetes.

Rosati insiste però in particolare su un tema: la GenAI è qui per restare. “Il 75% delle aziende già utilizza l’AI generativa, mentre il 45% sta considerando la creazione di propri large language models per sfruttare al meglio le capacità di questa tecnologia” (fonte: Intersect360 Research). Solo il 17% delle organizzazioni però è già in fase di produzione o vicina alla produzione con modelli AI, mentre il 60% ha ancora molto lavoro da lavorare per passare dalla fase di sperimentazione a quella operativa. “Questo significa che il mercato è ancora aperto, con ampie possibilità di successo per chi sa come sfruttarle”.

La sicurezza e la protezione dei dati

Un aspetto cruciale dell’adozione della Generative AI è la sicurezza dei dati. Rosati fa riferimento a un caso recente che ha visto Samsung minacciare il licenziamento dei dipendenti che avessero divulgato dati sensibili tramite chatbot AI come ChatGpt. Questo esempio richiama l’importanza di una gestione attenta e sicura delle informazioni aziendali. Ecco allora che “consapevoli che le chatbot di intelligenza artificiale possono essere strumenti potenti, bisogna capire come possano rappresentare un rischio per la riservatezza”, Per questo E4 ha sviluppato Private-Llm, proposta come architettura che utilizza modelli di linguaggio open source e personalizzabili per lavorare in modo sicuro con i documenti aziendali. In pratica è il cuore della proposta Gaia, che rappresenta l’appliance di intelligenza artificiale generativa offerta come un’alternativa ‘private’ a ChatGpt.

Tre i fattori fondamentali per il successo nell’adozione dell’AI generativa poi messi a fuoco da Rosati: “riconoscimento del brand, la potenza di calcolo e i talenti. Tre ingredienti che non mancano nella proposta E4”. Con la capacità di lavorare insieme si introduce così il tema che guida l’intervento di Rod Evans, VP supercomputing e AI di Nvidia.

Nvidia, l’AI come infrastruttura critica del futuro

Rod Evans delinea la vision dell’aziende su AI e supercomputing ed evidenzia il ruolo chiave che queste tecnologie giocheranno nel plasmare le infrastrutture del futuro. Il messaggio centrale di Evans: “Non si va da nessuna parte se non si lavora insieme, con tecnologie integrate e collaborazione tra partner”. Nella roadmap tecnologica di Nvidia per l’accelerating computing, vi sono invece le sinergie tra Cpu, Gpu e Dpu (Data Processing Unit). L’obiettivo è creare un’infrastruttura computazionale che permetta di accelerare i processi legati all’intelligenza artificiale. Come spiega Evans: “Nvidia non si concentra solo sull’hardware, ma sviluppa un intero ecosistema che include software e modelli per abilitare la rapida adozione dell’AI in azienda”. E l’integrazione tra hardware e software è fondamentale per ottenere il massimo dalle tecnologie di AI.

Evans insiste in particolare sul valore delle AI Factories, descrivendole come “ecosistemi che combinano competenze, Gpu e modelli di intelligenza artificiale per alimentare la crescita economica e l’innovazione. Strutture centrali per il progresso scientifico e in futuro motori di crescita economica”. Lo stesso Cineca rappresenta in questa prospettiva un vero trampolino di lancio per startup e aziende emergenti, permettendo loro di testare e scalare le proprie soluzioni AI. Evans va oltre: “Con il lancio di ChatGpt è cambiato il modo in cui le persone e le aziende percepiscono e utilizzano l’intelligenza artificiale”. Il 2023 è stato l’anno poi in cui le aziende si sono chieste come stare al passo con l’innovazione e sfruttare i Llm per trasformarsi. Ora “il 2024-2025 sarà biennio decisivo per portare l’AI in produzione su larga scala. Le aziende inizieranno a utilizzare queste tecnologie non solo per esplorare possibilità, ma per integrarle concretamente nei loro flussi operativi e questo passaggio segnerà una nuova fase”.

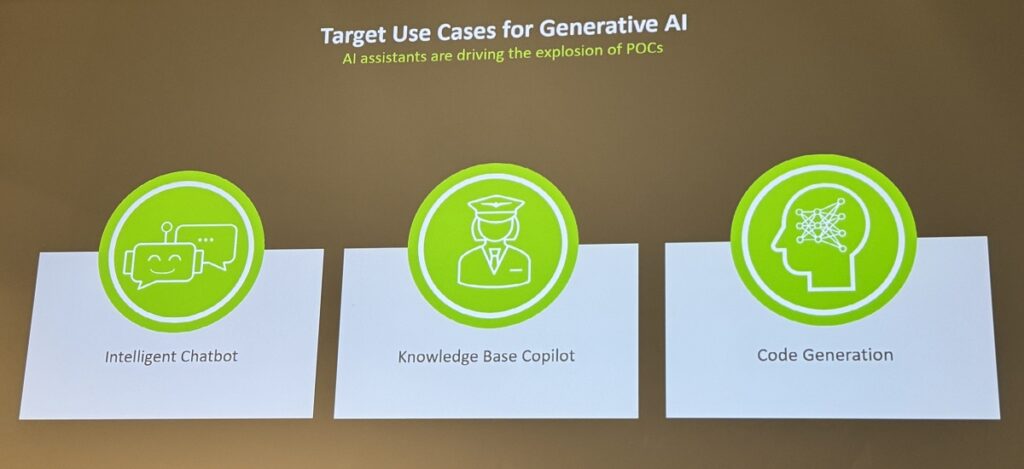

Tre casi d’uso chiave della GenAI ne guidano l’adozione: gli Intelligent Chatbot come strumenti conversazionali che utilizzano AI generativa per migliorare l’interazione con i clienti; i Base Copilot come assistenti che supportano gli utenti nelle loro mansioni quotidiane, offrendo suggerimenti e soluzioni in tempo reale e la Code Generation per generare automaticamente codice software, semplificando e accelerando il lavoro degli sviluppatori.

Tra le sfide invece “la difficoltà nel gestire grandi quantità di dati, l’importanza di mantenere bassi i costi operativi e la necessità di integrare l’AI nei flussi di lavoro esistenti senza problemi”. Molte aziende infatti temono di perdere il controllo sui propri dati se questi vengono gestiti su piattaforme cloud e Nvidia offre soluzioni come gli Inference Microservices per superare anche questo problema. Si tratta di microservizi che permettono alle aziende di gestire l’inferenza AI in modo scalabile ed efficiente, anche on-premise. Si va oltre: con Nvidia Blackwell Platform, si propone una piattaforma avanzata per gestire carichi di lavoro AI di grandi dimensioni e, grazie all’integrazione di NVLink e NVSwitch Chip, la piattaforma Blackwell consente di connettere fino a 72 Gpu in un unico sistema, migliorando significativamente la velocità e l’efficienza dei modelli di AI. Tecnologie essenziali per affrontare carichi di lavoro complessi, come i modelli di linguaggio di grandi dimensioni utilizzati nella Generative AI. Un punto chiave: “L’AI deve essere disponibile ovunque, sia nel cloud che on-premise, per offrire la massima flessibilità alle aziende e per questo Nvidia collabora con numerosi partner tecnologici per garantire che le sue soluzioni siano accessibili in qualsiasi ambiente, permettendo alle aziende di scegliere l’infrastruttura più adatta alle loro esigenze”.

Il punto di vista di Intel e Amd

Il confronto si arricchisce nella tavola rotonda con Claudio Bellini, Hpc Account Executive, Italia e Svizzera di Intel, Luca Catalano, sales executive di Amd e lo stesso Rod Evans.

Al centro gli sviluppi nell’high performance computing e sull’intelligenza artificiale e le rispettive visioni aziendali nel rispondere alle crescenti esigenze di potenza di calcolo e ottimizzazione energetica. Intel propone un vero e proprio approccio “duale”. L’azienda riconosce che oggi la maggior parte dei sistemi di punta utilizza una combinazione di Cpu e Gpu ma se le Gpu sono responsabili della maggior parte della potenza di calcolo, le Cpu rimangono fondamentali per diversi sistemi.

Intel è comunque la seconda azienda nella classifica dei vendor di Gpu. E casi d’uso d’eccellenza proprio del suo approccio “duale” sono per esempio l’Argonne National Laboratory, che utilizza l’architettura Xeon Cpu e le Gpu Max 1550 di Intel. Inoltre fa innovazione in casa Intel la capacità di sfruttare acceleratori specifici all’interno dei processori Xeon, che non eseguono codice x86, ma operano su applicazioni mirate come la compressione, la criptografia e la semplificazione dei calcoli per l’AI. “Un altro passo importante per Intel è legato all’acquisizione di Habana Labs, e quindi poi lo sviluppo dell’acceleratore Gaudi, progettato specificamente per l’AI”.

Catalano (Amd) propone invece di riflettere su tre grandi sfide che i clienti affrontano nell’ambito dell’Hpc e dell’AI: il valore delle performance per watt, la diversificazione delle esigenze tra inferencing e training, e il ruolo cruciale del software. Con Amd che risponde a queste sfide attraverso soluzioni hardware che combinano Cpu, Gpu e altre tecnologie, come le Apu (Accelerated Processing Units), che integrano funzionalità di calcolo grafico e generico.

Tema caldo è proprio quello relativo alla sostenibilità che vede Amd concentrare i propri sforzi proprio sul raggiungimento delle prestazioni più elevate con il minor impatto energetico possibile. Un ambito che esalta l’importanza del software. Spiega Catalano: “Senza un’infrastruttura software efficiente, anche l’hardware più potente può risultare inutile”.

Per questo Amd ha sviluppato il software stack ROCm, che comprende librerie, compilatori e strumenti per aiutare i clienti a sfruttare al meglio le tecnologie di ultima generazione, rispondendo in modo dinamico ai cambiamenti del settore.

Entrambi gli ospiti concordano su un punto fondamentale: i sistemi ibridi che combinano Cpu e Gpu stanno diventando lo standard nel campo dell’Hpc e dell’AI. Questa combinazione permette di sfruttare al massimo le capacità di calcolo delle Gpu, mentre le Cpu continuano a svolgere un ruolo essenziale nei sistemi che richiedono un’alta capacità di gestione dati e controllo. Le Gpu, d’altro canto, con la loro potenza parallela sono diventate il motore principale dell’innovazione, e tuttavia è attraverso l’integrazione con Cpu e acceleratori specifici che sarà possibile raggiungere le massime prestazioni. Non senza incognite, come insiste nello spiegare Catalano: “L’efficienza computazionale nel bilancio consumi/prestazioni e la scalabilità richiedono oggi un vero e proprio salto generazionale che lato hardware aancora non si intravvede ma in cui il software di sicuro gioca un ruolo imprescindibile. Non si avanza più nella ricerca delle prestazioni a forza bruta mettendo più macchine, e la ricerca della potenza di calcolo e di performance non può essere l’unica via”.

GenAI e quantum computing, tra realtà e prospettive

Esplorare il crescente impatto dell’intelligenza artificiale generativa nelle aziende e discutere le principali problematiche legate alla sua adozione sono invece il tema del confronto con Erion Islamay, ML Engineer di E4 Analytics insieme ad Antonio Cisternino, fellow researcher UniPisa e Giuseppe Fiameni, lead engineer Nvidia AI Technology Center. Tra i punti salienti trattati le politiche aziendali riguardo all’uso dell’AI, con particolare attenzione alla protezione dei dati. Islamay: “Sebbene l’AI generativa offra enormi vantaggi in termini di efficienza e produttività, molte aziende ancora non sanno come gestire efficacemente questa tecnologia”. Dati Business.com rivelano infatti che il 9% delle aziende incoraggia l’uso dell’AI generativa, ma un 80% non ha una politica chiara in merito. Torna al centro il tema dell’importanza di controllare i propri dati durante l’adozione di GenAI. “Strumenti cloud come ChatGpt – insiste Islamay – possono davvero mettere a rischio la privacy dei dati aziendali, ma la soluzione c’è ed proposta proprio da E4 con Gaia, piattaforma di AI generativa on-premise che garantisce il controllo totale sui dati aziendali, permettendo alle aziende di sfruttare i benefici della GenAI senza compromettere la sicurezza”.

Islamay introduce quindi il tema di tecnologie come la Rag (Retrieval-Augmented Generation) ed il Fine-Tuning che servono per personalizzare i modelli AI sulle esigenze specifiche delle aziende, e spiega come questi approcci permettano di migliorare le prestazioni dell’AI nel rispondere a domande aziendali specifiche. Gaia 4.0, al riguardo va oltre e integrerà innovazioni come GraphRag e Agentic Workflows. Quest’ultimo si basa su veri e propri “agenti”, piccoli modelli AI che possono svolgere compiti complessi in parallelo, come per esempio produrre più versioni di riassunti di un documento.

Islamay in particolare vuole così enfatizzare il ruolo chiave degli sviluppi nella transizione verso l’uso dell’AI generativa direttamente nei sistemi aziendali, integrando i dati interni e ottimizzando i flussi di lavoro senza la necessità di ricorrere a servizi cloud esterni. “La visione di E4 è di permettere alle aziende di portare l’intelligenza artificiale generativa verso i dati, garantendo sicurezza e prestazioni elevate all’interno delle infrastrutture aziendali”. Facciamo però anche un passo indietro con Antonio Cisternino e Giuseppe Fiameni che mettono in luce le problematiche, le potenzialità e le sfide dell’implementazione di modelli AI nelle aziende, con un focus sull’infrastruttura necessaria per supportare questa rivoluzione tecnologica.

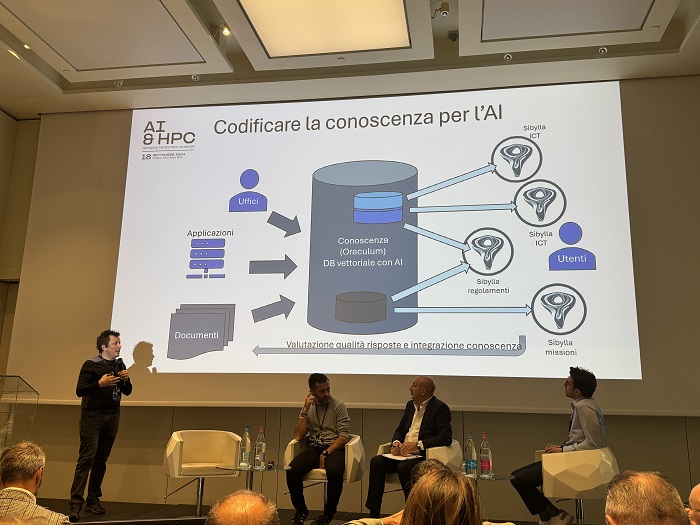

Cisternino al riguardo presenta per esempio il progetto Oraculum, un framework open-source sviluppato in UniPisa con l’obiettivo di migliorare l’integrazione tra l’intelligenza umana e quella artificiale. Questo strumento “permette di combinare la conoscenza dell’operatore con quella preesistente nel modello AI, senza che vi sia una separazione o “affettamento” delle informazioni”. Perché “estrarre conoscenza richiede di non affettare le informazioni e la coerenza del contesto è essenziale per ottenere risposte accurate e rilevanti dai modelli di linguaggio”.

Uno degli aspetti più interessanti di Oraculum è proprio l’utilizzo del sistema Rag (Retrieval-Augmented Generation), che permette di arricchire il modello AI con dati specifici e rilevanti per il contesto aziendale. In questo modo, “si può fornire al modello un set di informazioni supplementari che ne aumenta l’accuratezza e la capacità di rispondere alle esigenze specifiche di ogni utente”. Grazie a questo approccio, i modelli possono essere utilizzati non solo per generare testo, ma anche per aiutare a risolvere problemi aziendali complessi. Il vantaggio di progetti come Oraculum è proprio che offrono una soluzione in grado di essere integrata on-premise, mantenendo così i dati all’interno dei confini aziendali e riducendo i rischi di esposizione.

E’ Giuseppe Fiameni a mettere invece in evidenza la crescente necessità di infrastrutture potenti e flessibili per sostenere lo sviluppo e l’implementazione di modelli di intelligenza artificiale generativa. Secondo Fiameni, “uno dei problemi principali nel campo dell’AI è l’enorme quantità di dati e risorse computazionali necessarie per addestrare e far funzionare questi modelli che porta al bisogno di grandi infrastrutture e tanti dati”, e Nvidia stia lavorando per fornire soluzioni capaci di scalare e sostenere questi requisiti.

Mentre le aziende richiedono lo sviluppo di modelli di fine-tuning per adattare i modelli AI generativi alle esigenze specifiche migliorando così le loro performance con gli stessi propri dati. Al centro si pone il tema dei modelli aperti, come quelli sviluppati da Meta e Mistral, che condividono sì il modello in sé ma non i dati su cui è stato fatto l’addestramento né le relative ricette per il training. Una vera sfida per la comunità di ricerca, che – pur beneficiando dei relativi vantaggi – si trova spesso a dover competere con giganti tecnologici senza avere accesso alle stesse risorse o conoscenze dettagliate.

Del tutto collegato ai precedenti Fiameni affronta allora anche il tema dei foundational models, modelli pre-addestrati che possono essere adattati a una vasta gamma di compiti grazie alla generazione di “next token”. Questi modelli sono alla base della maggior parte delle applicazioni AI moderne e sono progettati per essere estremamente flessibili. Tuttavia, “la loro efficienza dipende dalla capacità di adattarli a specifiche necessità proprio attraverso tecniche come il fine-tuning e l’ottimizzazione continua”. L’evoluzione di questi modelli pone una domanda cruciale: perché i modelli AI continuano a crescere in dimensione e complessità? Secondo Fiameni, l’aumento delle dimensioni dei modelli è legato alla necessità di migliorare la capacità di reasoning dell’AI, cioè la capacità di prendere decisioni complesse e di interpretare correttamente le informazioni. Questo sarà un elemento chiave per il successo delle applicazioni di AI generativa, che devono essere in grado di comprendere il contesto e fornire risposte pertinenti e utili

Matteo Barbieri, quantum developer di E4 Computer Engineering, Misal Memeo, partner di Obloo, e Daniele Ottaviani, head of quantum computing Lab Cineca, offrono a conclusione della mattinata di lavori una panoramica delle più recenti evoluzioni e delle prospettive future per questa tecnologia emergente. Barbieri ritorna ancora sul tema del quantum advantage, spiega come “il quantum potrebbe superare i limiti del calcolo classico una volta risolti i problemi legati alla tolleranza agli errori. Anche se attualmente, siamo nell’era Nisq (Noisy Intermediate-Scale Quantum), caratterizzata da dispositivi quantistici affetti da rumore, che tuttavia si prevede che entro 4-5 anni saranno in grado di raggiungere un livello di maturità sufficiente per ottenere un vero vantaggio quantistico”.

Oggi è invece già cruciale e strategico il ruolo degli emulatori.

Gli emulatori quantistici permettono di testare algoritmi quantistici su hardware classico, simulando il comportamento dei qubit (fino a un massimo di 30-40 qubit). Questo approccio offre alle aziende e ai ricercatori un’opportunità per iniziare a lavorare con il quantum computing, anche prima che i computer quantistici siano pronti per l’uso su larga scala. Un momento per arrivare al quale sono necessari ancora importanti investimenti.

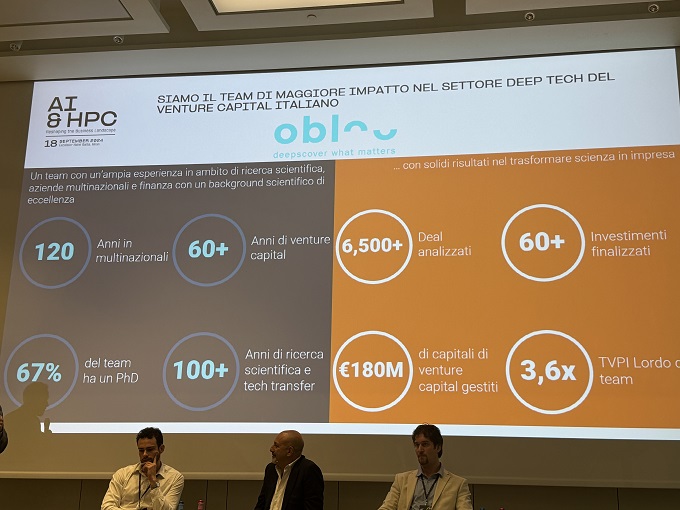

Ne parla Memeo che discute a fondo il panorama degli investimenti nel quantum computing, evidenziando come, “attualmente, il settore pubblico sia il principale investitore in questa tecnologia, poiché il costo elevato e la complessità rendono difficile per i player privati sostenere progetti su larga scala”. Memeo osserva in particolare che “molti investimenti sono stati dirottati verso l’AI generativa, data la sua applicabilità a breve termine rispetto al quantum computing, che richiede ancora anni di sviluppo prima di poter diventare una realtà commerciale”.

Daniele Ottaviani, rappresentante di Cineca, chiude gli incontri della mattina facendo un punto interessante sull’attività di Cineca nel quantum. “Oggi, in particolare, il quantum computing viene integrato nelle infrastrutture Hpc, un innesto che genera valora già oggi”. Cineca ha recentemente “collegato” due computer quantistici ai suoi sistemi. “E questa integrazione rappresenta un passo avanti verso l’adozione di un modello di calcolo ibrido, che combina le potenzialità del calcolo classico e quantistico per accelerare il processo di risoluzione dei problemi complessi”. Ma ancora è importante generare collaborazione. “Serve creare una rete europea di computer quantistici. Attraverso progetti finanziati dall’Unione Europea, Cineca ha accesso a computer quantistici situati in Francia, Germania e Spagna, e questo permette ai ricercatori di testare i propri algoritmi su diverse architetture quantistiche. Una collaborazione essenziale per sfruttare appieno le potenzialità del quantum computing, offrendo un’infrastruttura condivisa per la ricerca e lo sviluppo”. L’integrazione con l’Hpc e lo sviluppo di algoritmi ibridi rappresentano un passo fondamentale per accelerare la transizione verso il momento in cui il quantum computing diventerà parte integrante del computing per le aziende.

© RIPRODUZIONE RISERVATA