L’incontro con Roberto Patano, senior manager solutions engineer di NetApp Italia, negli uffici milanesi dell’azienda, è l’occasione per comprendere quali dinamiche tecnologiche sono state protagoniste dell’anno appena concluso ed individuarne le evoluzioni future.

“In un mercato allargato dove business e tecnologia si sovrappongono sempre più, la parola d’ordine è oggi flessibilità, come filo conduttore per orchestrare tutti i nuovi processi tecnologici, dall’AI, all’IoT, al multi cloud, alla containerizzazione”, esordisce Patano. E in queste dinamiche, “la digital technology coinvolgere ormai tutte le linee di business, tendenza dimostrata dal fatto che oggi siedano ai tavoli di discussione nella definizione dei processi non più solo gli IT manager ma i responsabili marketing e strategie; l’infrastruttura diventa un di cui”.

L’approccio flessibile è quello che NetApp adotta per supportare le aziende che vogliono sviluppare i nuovi paradigmi. Come nel caso di Ducati Corse, con cui è nata una collaborazione, ampliata proprio nei giorni scorsi, per analizzare e sfruttare il potenziale dei dati nel mondo delle gare e consentire al team corse di prendere decisioni più rapide e miglorare le strategie attraverso l’infrastruttura di hybrid cloud. La partnership vede in particolare l’implementazione della soluzione All Flash FAS di NetApp, collegata a cloud, con cui Ducati può gestire 200 applicazioni e 300 terabyte di dati, e di NetApp HCI, con cui le potenzialità dell’intero data center vengono consegnate direttamente al team MotoGP di Ducati in pista.

L’AI entra nel gioco del cloud

Facendo riferimento all’analisi “NetAppPredictions 2019” realizzata a livello globale dal CSO, Atish Gude, Patano entra nel dettaglio dei trend. L’Artificial Intelligence è la protagonista nello sviluppo del digitale e registra un’esplosione durante il 2018. “Ma la vera novità – spiega il manager – è che l’AI è ormai entrata nel gioco del cloud, che sta investendo massicciamente in questo ambito (come dimostrano ad esempio le ultime mosse in questa direzione fatte da Amazon e Google, quest’ultima con un sito dedicato all’AI), con software e strumenti di servizio, soluzioni preconfezionate, hardware, GPU, dischi veloci, e tutta l’infrastruttura pronta all’uso per rendere i processi più evoluti”. Un trend in fase iniziale destinato ad avere ulteriori sviluppi, come confermano i dati: un’analisi di IDC prevede infatti che l’85% circa delle aziende a livello globale sarà on cloud entro il 2020.

Le aziende sembrano ormai pronte al cambiamento: “Fino ad oggi solo pochi soggetti potevano permettersi di sperimentare questa tecnologia, mettendosi in casa un’infrastruttura di AI – afferma il manager -. Oggi si assiste ad un cambiamento di approccio e alcune aziende, che mai avrebbero pensato di adottare tecnologie per il riconoscimento facciale o una chatbot, fanno un’inaspettata scelta in questa direzione”.

Nell’IoT, smart device sempre più intelligenti impongono maggiore flessibilità e si preparano a rendere il real time una realtà, “in particolare dopo l’asta del 5G che genererà banda sufficiente per fare analisi di qualsiasi tipo, fino ad essere in grado di decidere quali dati elaborare immediatamente, quali rimandare alla parte core o al cloud e quali scartare in tempo reale”. Un processo che già oggi vede sempre più intelligenza migrare dove i dati vengono generati, per essere rielaborati in loco e magari mandati verso soluzioni di AI.

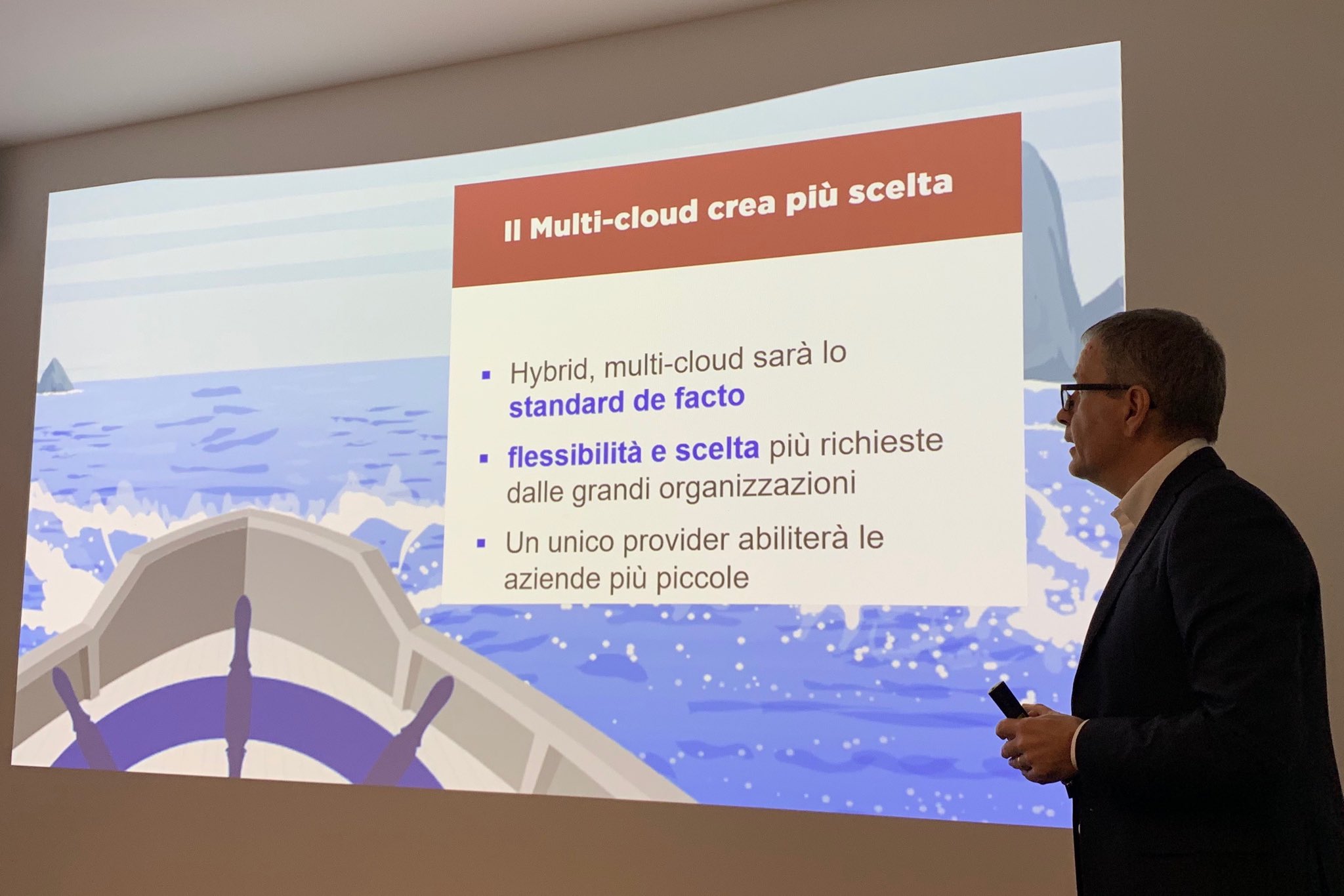

Multi cloud, lo sposano le grandi aziende

“Nell’adozione del cloud, ibrido o multi cloud, lo scorso anno si pensava che l’approccio fosse indipendente dalla dimensione delle aziende – dichiara Patano -, oggi si dimostra che non è così”. Ciò che ormai assodato è che multi cloud e cloud ibrido sono scelte per le aziende medio-grandi. Le organizzazioni più piccole, al contrario, non sentono l’esigenza del multi cloud ma continuano a sviluppare capacità interne come alternativa ai fornitori di servizi cloud e generalmente si affidano a un unico cloud provider.

In un contesto dove i confini fisici stanno sempre più scomparendo, il data center va un po’ contro questa dinamica, sottolinea Patano, ma resterà una realtà ancora a lungo: “Le infrastrutture on premise e i data center ci saranno comunque, perché le aziende preferiscono mantenere i dati sensibili all’interno, utilizzando soluzioni pronte all’uso già in casa”.

Verso il concetto di Automagically

La richiesta di flessibilità e la possibilità di poter spostare le applicazioni tra cloud diversi produce un’evoluzione molto forte verso l’adozione dei container per favorire lo spostamento dei carichi di lavoro verso il luogo in cui vengono generati i dati anziché il contrario. “Mentre le tecnologie di containerizzazione come Docker continueranno ad avere rilevanza – spiega Patano -, lo standard per lo sviluppo di applicazioni multi cloud sarà Kubernetes, come soluzione per orchestrare il tutto”, un settore sul qualeNetApp sta investendo molto con soluzioni di Kubernetes-as-a-service che supportano direttamente le funzionalità di orchestrazione delle applicazioni nei cloud.

Lo sviluppo delle tecnologie di containerizzazione e “serverless” fanno anche strada al nuovo concetto di “automagically”, legato al maggior livello di aspettativa dell’utente, all’astrazione delle risorse IT e alla trasformazione dei servizi di dati in commodity. Soluzioni progettate con il dato al centro, delivery predittiva di dati, servizi in background forniranno sempre più dati quando e dove necessari, ovunque essi risiedano, solidi ma “invisibili” agli utenti.

© RIPRODUZIONE RISERVATA