Più che una tecnologia l’acronimo AI Ops indica un metodo operativo. La sigla infatti significa Artificial Intelligence Operations: sfruttando le possibilità offerte dall’intelligenza artificiale è possibile generare programmi di autoapprendimento per rivoluzionare e migliorare i servizi IT (anche quelli infrastrutturali) automatizzando una serie di funzioni e anticipando eventuali interventi.

Si tratta quindi di un passo avanti rispetto al modello operativo semplicemente basato sugli analytics e quindi in pratica solo reattivo.

Tra i casi concreti di applicazione quello all’interno del programma PathForward sostenuto dal Dipartimento per l’Energia statunitense (Doe) – cui fa capo il Laboratorio Nazionale di ricerca sulle Energie Rinnovabili (Nrel, National Renewable Energy Laboratory, ente governativo) – insieme ad Hpe.

Spiega l’idea Kristin Munch, manager data, analysis and visualization group per Nrel: “La nostra collaborazione tocca la ricerca nelle aree della gestione dei dati, della data analytics e dell’ottimizzazione AI/ML per gli interventi sia manuali sia autonomi nelle operazioni dei data center”.

Scopo: la ricerca e lo sviluppo di tecnologie di intelligenza artificiale e machine learning per l’automazione e il perfezionamento dell’efficienza operativa nei data center exascale.

Contesto

Un data center exascale si definisce di classe tale quando è grado di eseguire almeno un exaflops (un miliardo di miliardi) di operazioni al secondo. Si tratta di una capacità superiore di mille volte rispetto a quanto era in grado di fare un sistema di computing di classe inferiore prossima (petascale) nel 2008.

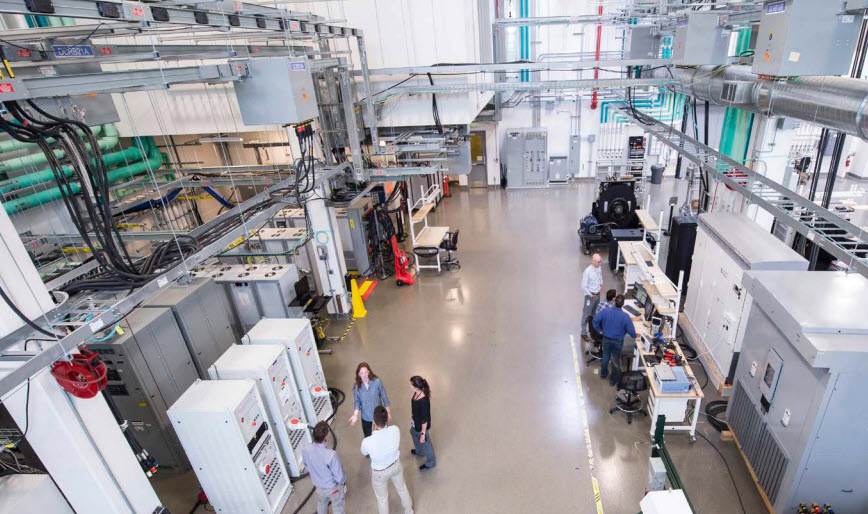

Il progetto rientra nell’ambito di una collaborazione di respiro triennale, per l’introduzione di tecniche di monitoraggio e analisi predittive con focus specifico sui sistemi di alimentazione e di raffreddamento del data center Hpc del Nrel presso l’Energy Systems Integration Facility (Esif).

Da una parte rientra tra le missioni del Nrel studiare tecnologie di efficientamento energetico anche sfruttando le energie rinnovabili, dall’altra sono di interesse per tutti studio e messa a terra di nuovi approcci per la riduzione dei consumi di energia e l’abbattimento dei costi operativi sfruttando le tecnologie emergenti più promettenti.

Il metodo

Nel caso specifico, si parte a lavorare sulla scorta dei dati raccolti in oltre cinque anni: circa 16 TB. I dati sono stati generati dai sensori dei sistemi Hpc, Peregrine ed Eagle, nella struttura del Nrel e sono serviti per addestrare i modelli di apprendimento relativi alla capacità di rilevare le anomalie per prevedere e prevenirne i problemi di funzionamento prima che si verifichino.

Per quanto riguarda la sostenibilità del data center exascale, si studiano i consumi di energia ed acqua. Il consumo di acqua si prevede raggiungerà i 660 miliardi di litri entro il 2020 (Fonte: Berkeley Lab’s Energy Technology Areas: United States Data Center Energy Usage Report). Circa 73 miliardi di kWh i consumi di energia previsti.

I modelli serviranno per monitorare ed ottimizzare efficienza e sostenibilità (se ancora se ne può parlare in questi termini) misurata secondo i parametri Pue, Wue e Cue (rispettivamente Power, Water e Carbon Usage Effectiveness).

Per sviluppare algoritmi di machine learning si utilizzano software e librerie open source tra cui anche Tensorflow insieme a Numpy e Sci-Kit.

Tre i momenti progettuali. Vengono raccolti ed elaborati i big data relativi a IT e facility anche da fonti eterogenee (generando un data lake) prima dell’applicazione sugli stessi degli algoritmi (1). Quindi con tecniche specifiche di big data analytics e ML vengono analizzati i dati da diversi tool e dispositivi all’interno di tutto il DC (2), a questo punto vengono applicati gli algoritmi per consentire ai sistemi di computing di risolvere in autonomia task ripetitivi e automatizzare attività di manutenzione predittività sia sull’IT sia nella struttura del DC (3).

Obiettivi

Il progetto AI Ops è destinato ad evolvere per diventare a tutti gli effetti un tool di convalida per le attività di integrazione e deployment continue (Continuous Integration and Deployment, ovvero CI e CD). L’applicazione di algoritmi AI a un sistema Hpc exascale dovrebbe permettere di migliorare anche le caratteristiche di resilienza e affidabilità per mezzo di capacità automatiche e smart.

Hpe allo stesso tempo sulla scorta di sperimentazioni come queste vuole ampliare i propri sistemi Hpcm (High Performance Cluster Management), per modellizzare le procedure di provisioning, gestione e monitoraggio dei cluster fino a 100mila nodi.

Tra i test previsti, la possibile integrazione di Hpe InfoSight (tool di gestione AI-driven basato su cloud per il monitoraggio dell’infrastruttura IT) per prevedere e prevenire probabili eventi mantenendo lo stato di salute complessivo delle prestazioni dei server.

© RIPRODUZIONE RISERVATA