Al via Google Cloud Next ’20, edizione virtuale rinnovata e spalmata tra il 14 luglio ed il 9 settembre con sessioni settimanali ad indirizzare specifiche tematiche: Industry insights, Productivity e collaboration, Infrastructure, Security, Data analytics, Data Management, Application modernization. Cloud AI e Business Application Platform sarà l’ultimo appuntamento a settembre. Favorire la trasformazione delle aziende, sfruttando i dati, resta il primo obiettivo della proposizione cloud di Google, oggi disponibile in oltre 150 Paesi, che poggia sostanzialmente su tre pilastri, come spiega Kirsten Kliphouse, presidente di Google Cloud per il Nord America: “L’affidabilità, la semplicità e l’offerta di servizi innovativi“. Con una proposizione tecnologica, in estrema sintesi così figurata da Thomas Kurian, Ceo di Google Cloud: “Offriamo tre stack principali: infrastruttura distribuita su scala globale come servizio, una piattaforma di trasformazione digitale, e soluzioni specifiche, per i verticali delle diverse industry, basate sull’AI di Google e sui progressi del machine learning“.

Gli sforzi compiuti in questo anno hanno permesso all’hyperscaler di guadagnare una serie di clienti nel mondo, di classe enterprise, segmento su cui Google punta in modo particolare: per esempio Vodafone, Telefonica, Lufthansa, AT&T, Deutsche Bank e, tra le realtà a noi più vicine e interessanti, Tim e Intesa SanPaolo.

In questo solco si inserisce anche il recente impegno in Italia di Sundar Pichai, AD di Google, per 900 milioni nel programma Italia in Digitale, indirizzato però in modo specifico alle Pmi che rappresentano la parte più importante del nostro tessuto produttivo.

Kirsten Kliphouse svela ora i nuovi accordi con Fox Sport negli Usa e Renault in Europa. In particolare, Renault sviluppa dal 2016 una propria piattaforma digitale per connettere e aggregare dati industriali da 22 siti del gruppo in tutto il mondo e la nuova partnership con Google Cloud mira a ottimizzare la piattaforma di gestione dei dati industriali sfruttando le soluzioni Google Cloud per l’analisi intelligente, con machine learning e intelligenza artificiale, per migliorare supply chain e efficienza in produzione, riducendo l’impatto ambientale anche attraverso il risparmio energetico.

Google Cloud, passi avanti nel Confidential Computing

E’ ben definito il focus degli annunci Google Cloud Next ’20 più importanti, che può essere individuato nei passi avanti compiuti per garantire la sicurezza del public cloud, compliance, governance dei dati in modo automatizzato e l’analisi sui dati su cloud pubblici eterogenei senza doverli spostare, sfruttando la cloud di Google.

Jeanette Manfra global director Security and Compliance Google Cloud: “I sistemi legacy, i mindset legacy, possono spalancare la porta all’azione del cybercrime, ed invece la digital transformation deve necessariamente procedere di pari passo con la security transformation per assicurare la produttività. Per questo un approccio al cloud effettivamente ‘trusted’, deve prevedere l’utilizzo pervasivo dell’encryption su tutto lo stack ed un’offerta commerciale cloud sicura e protetta: in questa direzione vanno anche gli annunci più importanti”.

Introduce il primo Sunil Potti, GM e VP of Security Google Cloud: “Quando le aziende portano i propri workload in cloud, la sfida più grande da indirizzare è comprendere come riuscire a processare ed a lavorare sui dati sensibili continuando a mantenerli protetti, ‘privati'”. Google Cloud già crittografa i dati inattivi ed in transito, ma resta il problema della protezione durante l’elaborazione e le tecnologie di Confidential Computing – si parla da tempo della possibilità di tenere i dati crittografati “in memory” per l’elaborazione – si propongono ora come approccio innovativo in grado di tenere crittografati i dati anche mentre vengono utilizzati. La novità riguarda la fase di beta testing sulla proposta di Confidential VM (Virtual Machine) che rappresenterà la prima soluzione di Confidential Computing a catalogo.

Google Cloud utilizza diverse tecniche di isolamento e sandboxing per rendere sicura l’architettura multi-tenant. Ora con Confidential Virtual Machine si innalza il livello di sicurezza offrendo la crittografia della memoria per meglio isolare i carichi di lavoro in cloud, sfruttando il framework open source Asylo sul macchine virtuali N2D basate su processori Cpu Amd Epyc di seconda generazione. La memoria della VM resta crittografata con una chiave dedicata alla VM che viene generata e gestita dal processore. Le chiavi risiedono esclusivamente all’interno della VM, rendendole non disponibili per Google o per le altre VM in esecuzione sull’host.

Si apre uno scenario quindi in cui sarà possibile condividere data set riservati e sensibili per collaborare sulla ricerca anche in cloud, preservando l’esposizione del contenuto, in modo trasparente, considerato che Google punta a permettere che tutti i workload che già oggi sfruttano le VM possano allo stesso modo girare su Confidential VM (scegliendo quando con una semplice modalità di check-boxing), con una serie di importanti vantaggi anche per la sicurezza dai cyberattacchi.

“La proposizione di Confidential Computing – come in più occasioni ha sottolineato in passato Vint Cerf, chief Internet evangelist di Google – può effettivamente cambiare le regole del gioco riguardo all’elaborazione dei dati in cloud“. Con Potti che specifica “i clienti di tutti i settori che sperimentano le complessità della conformità e della privacy nel cloud, in particolare quelle nei settori regolamentati, come società di servizi finanziari, aziende sanitarie e agenzie governative che operano con regolamentazioni stringenti, possono apprezzare le potenzialità del cloud ma i requisiti rigorosi hanno impedito fino ad oggi di indirizzare una serie di workload, mentre Confidential VM indirizzerà correttamente questi casi d’uso ed al contempo semplifica la sicurezza”.

Workload vincolati e protetti

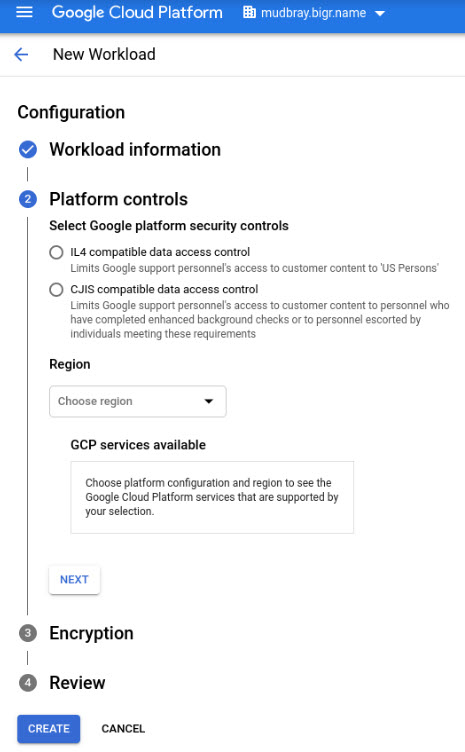

Strettamente legato a questo aspetto, e sempre con l’obiettivo di offrire il cloud pubblico compliant alle normative e sicuro è il secondo annuncio relativo a Assured Workload. In pratica, Google offre la possibilità di creare in modo facile e veloce ambienti controllati cui viene applicata in modo automatico tutta una serie di specifiche di accesso e protezione ai dati, a seconda della posizione geografica e delle relative regolamentazioni.

In tanti casi, per garantire privacy e conformità a normative specifiche sui carichi di lavoro, i cloud provider si trovano a dover creare ambienti separati con requisiti specifici, oppure spesso capita che le agenzie governative scelgano di eseguire versioni di cloud commerciali meno ricche di funzionalità ma adatte alle proprie stringenti esigenze.

Google propone l’automazione di questo processo, a partire dal proprio cloud, con la possibilità poi di sfruttarne tutti i servizi. Assured Workload quindi permette di portare in cloud i workload e sfruttarne le potenzialità senza compromettere la conformità. Al momento, anche questa possibilità è in beta privata, solo per alcuni enti governativi americani, la disponibilità della beta pubblica è prevista per l’autunno.

Si tratta di uno sviluppo molto interessante anche per le amministrazioni europee, ma ovviamente richiederà un lavoro specifico nel tempo. Assured Workload può aiutare inoltre a ridurre il rischio di configurazioni accidentali errate, mettendo a disposizioni configurazioni di sicurezza della piattaforma pre-impostate a seconda dei regolamenti, con l’applicazione determinata di alcune regole, in base alla distribuzione del prodotto e, nel caso, anche limitando l’implementazione nell’utilizzo di nuove risorse secondo le specifiche aree, o in base alle norme dell’organizzazione.

BigQuery Omni, l’analisi sui dati in multicloud

Una recente ricerca di Gartner svela che l’80% delle aziende che utilizzano il public cloud, utlizzano i servizi di diversi cloud provider, allo stesso tempo sperimentano come disporre di dati su diverse piattaforme cloud, di fatto crei silos di informazioni inutilizzabili e non funzionali allo sviluppo del business.

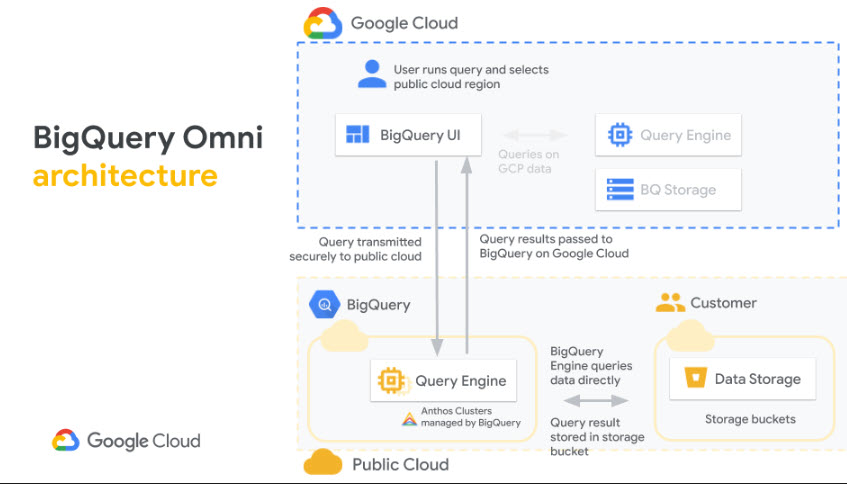

Ne parla Debanjan Saha, GM e VP Engineering Data Analytics Google Cloud, annunciando BigQuery Omni che può essere definita come una piattaforma di analisi multicloud per permettere ai clienti di sfruttare le funzionalità conosciute di BigQuery su Google Cloud, anche su Aws e nel prossimo futuro su Microsoft Azure. Il vantaggio principale è proprio quello di non dover spostare i dati tra i diversi public cloud per l’analisi delle informazioni.

BigQuery Omni si basa su Anthos e propone una singola interfaccia utente per l’analisi della region in cui i dati sono archiviati. Anthos, un’applicazione ibrida multicloud, offre la connessione sicura tra Google Cloud e gli altri cloud, sfruttando le Api.

Un esempio pratico: è possibile utilizzare BigQuery Omni per eseguire una query sui dati di Google Analytics 360 Ads archiviati in Google Cloud ma anche query sui dati dei registri dalla piattaforma di e-commerce e dalle applicazioni archiviate in Aws S3. Sfruttando Looker, si può poi generare una dashboard che permetta di visualizzare il comportamento dei clienti e gli acquisti, confrontandoli con la spesa pubblicitaria. In pratica questo è reso possibile attraverso la separazione delle componenti di computing da quelle di archiviazione di BigQuery.

Disaccoppiando questi due elementi, BigQuery Omni fornisce storage scalabile che può risiedere in Google Cloud o in altri cloud pubblici e risorse di calcolo resilienti per elaborare le query Sql standard, mentre fino ad ora per utilizzare BigQuery, i dati dovevano essere archiviati in Google Cloud. In pratica Anthos rende possibile l’esecuzione delle query senza preoccuparsi dell’infrastruttura sottostante. Le risorse di calcolo vengono utilizzate nella stessa area cloud in cui sono archiviati i dati, consentendo di avere un’esperienza di analisi dei dati del tutto fluida.

© RIPRODUZIONE RISERVATA