I servizi cloud infrastrutturali sotto la lente di Canalys comprendono l’offering bare metal As a Service, il mercato IaaS, quello PaaS e tutta la sfera dei container insieme al serverless in host presso provider di terze parti, reso disponibile ai clienti via Internet.

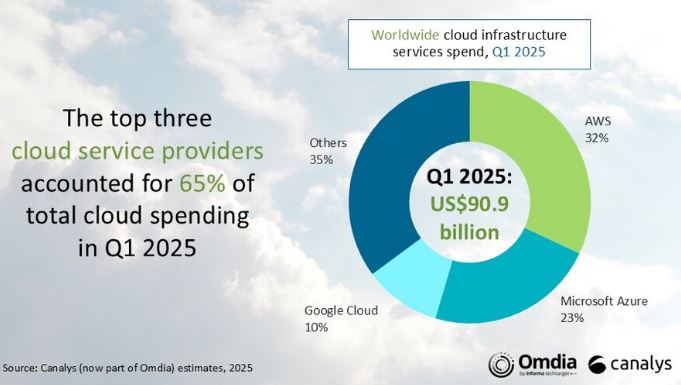

Nel primo trimestre del 2025 la spesa globale per i servizi cloud così definiti ha raggiunto il valore di 90,9 miliardi di dollari, registrando un incremento del 21% su base annua.

Le aziende riconoscono che l’adozione diffusa di applicazioni AI richiede un rinnovato impulso ai progetti di migrazione sul cloud, diventato l’asset fondamentale per supportare l’esecuzione anche dei workload AI. E questo, a vedere i numeri, nonostante si riconoscano per il cloud i rischi relativi all’incremento dei costi, in particolare nell’utilizzo dei servizi in forma massiva sia per le medie aziende, sia nell’ambito enterprise.

Il 2025 si presenta come l’anno in cui l’investimento congiunto nelle infrastrutture cloud e AI rappresenta il principale driver evolutivo dell’intero comparto e sta trasformando i modelli di spesa IT delle imprese, determinando una crescente allocazione di budget verso ambienti in grado di sostenere l’addestramento e l’inferenza di modelli avanzati, spesso con requisiti computazionali intensivi.

Le priorità delle aziende e le strategie degli hyperscaler

Due le priorità strategiche quindi: da un lato l’accelerazione dei progetti di migrazione cloud, sia attraverso lo spostamento di ulteriori workload sia con il rilancio di transizioni on-premise rimaste in sospeso; dall’altro, l’esplorazione e l’adozione progressiva dell’intelligenza artificiale generativa che, per sua natura, trova nel cloud la piattaforma abilitante ideale. In risposta a queste esigenze, i principali hyperscaler sono impegnati nell’ottimizzazione dell’infrastruttura. La diffusione delle applicazioni di AI generativa impone infatti una nuova attenzione al tema della sostenibilità economica dell’inferenza.

Lo spiega Rachel Brindley, senior director di Canalys: “Man mano che l’AI passa dalla fase di ricerca alla distribuzione su larga scala, le imprese pongono crescente attenzione all’efficienza dei costi di inferenza, valutando i modelli, le piattaforme cloud e le architetture hardware – dalle Gpu agli acceleratori custom”. A differenza del training, che rappresenta un investimento una tantum, l’inferenza costituisce infatti un costo operativo ricorrente e può diventare un vincolo critico lungo il percorso di industrializzazione dell’AI.

Una complessità che si riflette anche nella variabilità dei modelli di pricing attuali, prevalentemente basati sul consumo (ad esempio per token o chiamate alle Api), come osserva Yi Zhang, analyst di Canalys: “Quando i costi di inferenza diventano imprevedibili o eccessivamente elevati, le imprese sono costrette a limitare l’uso, ridurre la complessità dei modelli o riservare le implementazioni ai soli scenari ad alto valore”.

Un quadro che, inevitabilmente, frena il pieno sfruttamento del potenziale dell’intelligenza artificiale.

Per superare questi ostacoli, Aws, Microsoft Azure e Google Cloud hanno già introdotto chip proprietari e famiglie di istanze specializzate, con l’obiettivo dichiarato di migliorare l’efficienza dell’inferenza e contenere il costo complessivo dell’AI per le imprese clienti. Lo sviluppo di chip proprietari, progettati specificamente per abbattere i costi di utilizzo dell’AI e incrementare l’efficienza nei processi di inferenza è investimento che non solo consente di migliorare le performance e la scalabilità dei servizi AI, ma permette anche ai provider di differenziarsi in un mercato in cui la competizione tecnologica è sempre di più per “verticali”. Entriamo nei dettagli.

Aws, Microsoft e Google, strategie a confronto

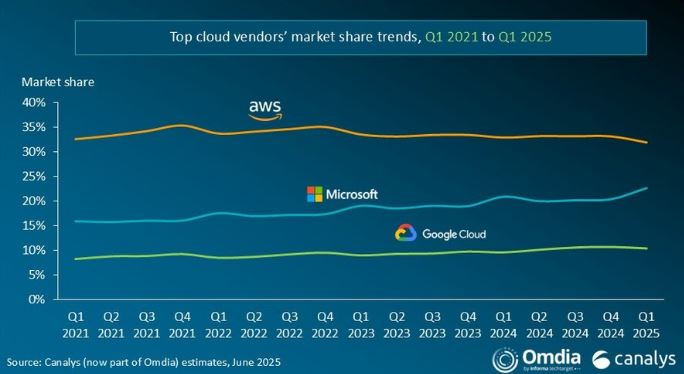

Nel primo trimestre 2025, la corsa degli hyperscaler globali sul mercato del cloud e dell’intelligenza artificiale ha messo in evidenza approcci e traiettorie differenti, pur all’interno di uno scenario di crescita complessiva sostenuta. Certo Amazon Web Services, Microsoft Azure e Google Cloud restano i principali protagonisti, ma le modalità con cui affrontano la sfida AI rivelano scelte strategiche distintive e in parte divergenti.

Aws di fatto cresce poco (quota al 32%) ma incrementa i ricavi annui del 17%. Continua a beneficiare di una posizione di forza consolidata sul piano infrastrutturale e di un’espansione progressiva della propria offerta AI. Particolarmente rilevante la scelta, annunciata a marzo, di attuare una politica di riduzione dei prezzi per favorire l’adozione dei propri chip Trainium, posizionati come alternativa economicamente più vantaggiosa rispetto alle soluzioni basate su Gpu Nvidia. Secondo le stime di Aws, Trainium 2 garantisce un vantaggio di costo-prestazioni compreso tra il 30 e il 40% rispetto alle configurazioni concorrenti. E’ in espansione l’utilizzo del servizio Bedrock, e sono disponibili nuovi modelli di AI generativa come Claude 3.7 Sonnet di Anthropic, Llama 4 di Meta ed è in grado di gestire in modalità fully managed modelli emergenti come DeepSeek R1 e Mistral Large. Sul fronte infrastrutturale, infine, Aws ha annunciato nel maggio 2025 un investimento di oltre 4 miliardi di dollari per la realizzazione di una nuova regione cloud in Cile entro la fine del 2026, a testimonianza di una visione orientata al lungo termine.

Microsoft Azure smarca una crescita annua del 33%, sensibilmente superiore a quella di Aws. L’AI rappresenta oggi un volano essenziale della crescita Azure, con un contributo stimato di 16 punti percentuali sul tasso di crescita trimestrale — il maggiore incremento registrato dal secondo trimestre 2024. Microsoft ha messo a disposizione, da aprile, i modelli Gpt-4.1 sia su Azure AI Foundry sia su GitHub, ampliando così l’accesso degli sviluppatori a capacità avanzate di generative AI. La piattaforma Azure AI Foundry, diventata ormai centrale nella strategia di Microsoft per la costruzione e la gestione di applicazioni e agenti AI, è oggi utilizzata da oltre 70mila aziende, con un utilizzo in sensibile crescita. In parallelo, Microsoft ha lavorato sull’efficienza energetica e di costo: rispetto all’anno precedente, ha ottenuto un miglioramento delle performance AI del 30% a parità di consumo energetico e una riduzione del 50% del costo per token. Prosegue la strategia di espansione con l’apertura di nuovi data center in dieci Paesi su quattro continenti.

Google Cloud ha una quota di mercato “solo” del 10%, ma registra una crescita annua del 31%. Al 31 marzo 2025, il backlog di ricavi ha raggiunto quota 92,4 miliardi di dollari, in leggero calo rispetto al trimestre precedente, soprattutto per effetto di limitazioni nella capacità di calcolo disponibili. Nonostante questi vincoli, Google ha introdotto a marzo la nuova serie di modelli Gemini 2.5, con Gemini 2.5 Pro che ha rapidamente guadagnato il vertice dei benchmark prestazionali e della classifica Chatbot Arena. Si aprono nuove opportunità applicative sia per gli sviluppatori sia per gli utenti enterprise. Cresce di oltre il 200% l’utilizzo attivo di Google AI Studio e delle Api Gemini dall’inizio dell’anno. Nuova cloud region in Svezia, la 42esima a livello globale, e ulteriori 7 miliardi di dollari per l’espansione del data center in Iowa, destinato a sostenere i futuri carichi AI e cloud.

© RIPRODUZIONE RISERVATA