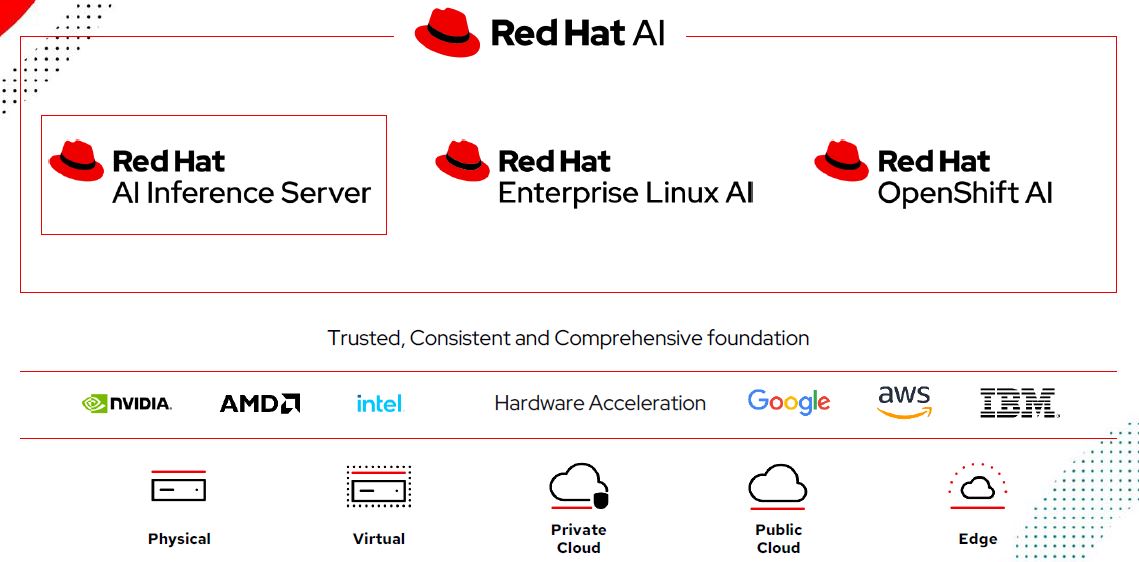

Si è da poco concluso, a Boston, Red Hat Summit 2025, occasione per l’azienda per confermare le traiettorie della propria evoluzione strategica e di proposizione tecnica. Due direttrici: rafforzare il proprio ruolo di abilitatore tecnologico per il cloud ibrido e l’intelligenza artificiale e raccogliere la sfida di proporre un’offerta sempre più articolata che integra AI generativa, automazione avanzata e innovazioni nella virtualizzazione e nella sicurezza. Al centro della proposizione strategica c’è la visione di un’intelligenza artificiale realmente “open”, scalabile e indipendente dall’infrastruttura, sintetizzata anche nel principio, trasversale (vale sull’intero stack tecnologico), “any model, any accelerator, any cloud”. Red Hat punta quindi a democratizzare l’adozione dell’AI generativa nelle aziende offrendo piattaforme di inferenza e modelli validati capaci di funzionare su qualunque acceleratore hardware, in qualsiasi ambiente cloud e con piena coerenza operativa.

Tra gli annunci coerenti con questo proposito Red Hat AI Inference Server, una piattaforma enterprise di inferenza basata sul progetto open source vLlm, a sua volta avviato dall’Università di Berkeley. Grazie alla combinazione con le tecnologie Neural Magic, Red Hat AI Inference Server promette inferenza AI generativa più veloce, efficiente e conveniente economicamente.

Joe Fernandes, vicepresidente e general manager della AI Business Unit di Red Hat, in occasione del Summit così spiega la proposta: “L’inferenza è il punto in cui la promessa dell’AI generativa si concretizza, offrendo interazioni utente rapide e accurate. Ma è essenziale che ciò avvenga in modo sostenibile dal punto di vista dei costi. Red Hat AI Inference Server risponde proprio a questa esigenza, offrendo un’infrastruttura flessibile per qualunque modello, acceleratore e ambiente”.

L’inferenza rappresenta a tutti gli effetti il motore operativo su cui si basa l’esecuzione dei modelli di AI; con la crescente complessità dei modelli fondazionali, rischia però di diventare un collo di bottiglia, sia in termini di consumo di risorse che di costi. Red Hat AI Inference Server vuole risolvere questi problemi integrando strumenti avanzati di compressione degli Llm per ridurre la dimensione dei modelli e un repository di modelli ottimizzati accessibile su Hugging Face, capace di accelerare l’efficienza senza sacrificare l’accuratezza. La piattaforma è disponibile sia come componente standalone sia integrata all’interno di Red Hat Enterprise Linux AI (Rhel AI) e Red Hat OpenShift AI.

E proprio la componente dei modelli validati rappresenta un altro tassello importante della strategia AI annunciata al Summit. Red Hat AI Validated Models costituisce un catalogo curato di modelli AI open source di terze parti, accuratamente testati per garantire prestazioni e affidabilità in produzione. Questi modelli, disponibili anch’essi su Hugging Face, sono corredati di “pesi” SafeTensor e istruzioni per una rapida implementazione, offrendo alle imprese un supporto concreto nella scelta dei modelli più adatti ai propri casi d’uso e alle proprie piattaforme hardware.

Il potenziale dell’AI open

Secondo Forrester, l’open source è destinato a diventare un catalizzatore per accelerare gli investimenti delle aziende in AI, e Red Hat punta a consolidare questo ruolo abilitante. La nuova versione Red Hat OpenShift AI 2.20, ad esempio, introduce funzionalità avanzate di training distribuito basato su Kubeflow, l’integrazione di un feature store centralizzato (basato su Feast, il “feature store per l’AI”) e un catalogo ampliato di modelli prevalidati pronti per la produzione. Grazie a questi strumenti, le organizzazioni possono orchestrare pipeline di sviluppo AI complete, dall’addestramento fino all’inferenza, mantenendo il pieno controllo dei dati e della sicurezza.

In parallelo, il nuovo Red Hat Enterprise Linux AI (Rhel AI) versione 1.5 amplia ulteriormente le opzioni per le imprese. Già disponibile su Aws, Azure e ora anche su Google Cloud Marketplace, la piattaforma integra funzionalità multilingue avanzate (incluso l’italiano) grazie a InstructLab e consente una personalizzazione più granulare dei modelli, sia per casi d’uso verticali che per specifiche esigenze linguistiche.

All’interno di questa strategia AI aperta e flessibile, l’azienda estende il proprio ecosistema di partnership: collaborazioni con Google, Meta, Amd e Ibm rafforzano l’integrazione di vLlm su nuovi acceleratori hardware come Instinct AI di Amd e Aiu di Ibm (il chip Artificial Intelligence Unit). In particolare, la partecipazione di Red Hat ai progetti open source llm-d e Agent2Agent sottolinea l’impegno dell’azienda nel contribuire a costruire standard aperti per l’inferenza AI e per l’evoluzione degli AI agent.

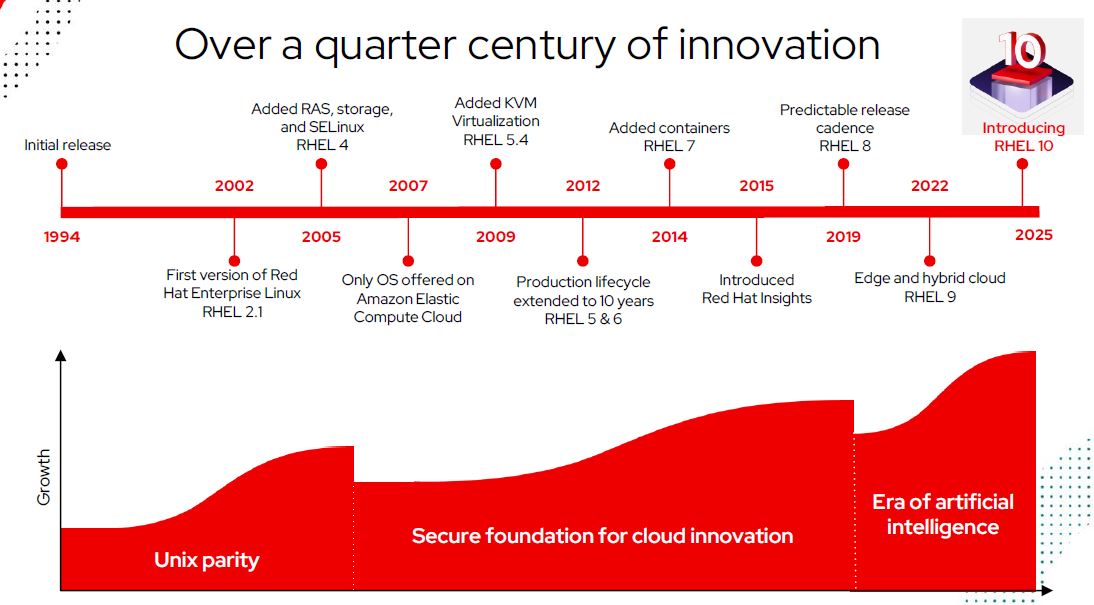

Red Hat Enterprise Linux 10

Se l’AI rappresenta l’asse portante del futuro tecnologico di Red Hat, il Summit 2025 ha messo in luce anche il rinnovo profondo di Red Hat Linux Enterprise, che raggiunge la versione 10. In un contesto in cui l’adozione cloud ibrida accelera e le competenze Linux scarseggiano, Rhel 10 introduce innovazioni cruciali per sicurezza, gestione e supporto all’intelligenza artificiale.

Gunnar Hellekson, VP della Red Hat Enterprise Linux Business Unit, rimarca: “Rhel 10 è progettato per aiutare i team IT a gestire l’attuale complessità e a progettare il futuro, con funzionalità AI native, gestione semplificata e sicurezza avanzata contro le minacce quantistiche”.

Tra le principali novità emerge inoltre Red Hat Lightspeed, che integra AI generativa nativa nella riga di comando Linux, offrendo suggerimenti contestuali, diagnosi proattive e assistenza in linguaggio naturale agli amministratori. Una funzionalità pensata per colmare il gap di competenze Linux e semplificare la gestione di ambienti estesi. Altrettanto innovativa è la modalità immagine, che introduce un paradigma container-native nella gestione del sistema operativo stesso, unificando il ciclo di build, rilascio e aggiornamento sia per OS che per applicazioni.

Sul fronte sicurezza, Red Hat Enterprise Linux 10 si distingue per essere la prima distribuzione enterprise a includere la crittografia post-quantistica conforme agli standard Fips, mitigando i rischi futuri legati all’arrivo dei computer quantistici. Inoltre, grazie a Red Hat Insights image builder, le organizzazioni possono ottimizzare le proprie configurazioni in fase di build, anticipando scelte più efficaci prima della messa in produzione.

L’evoluzione di Rhel 10 si completa con il supporto nativo ai principali hyperscaler. Red Hat, in collaborazione con Aws, Google Cloud e Microsoft Azure, ha infatti sviluppato immagini cloud-native pre-ottimizzate, integrate direttamente con i servizi di sicurezza e osservabilità dei provider cloud.

Questo consente implementazioni più rapide, coerenza tra ambienti on-premise e cloud pubblico e maggiore controllo sui costi e sulla scalabilità delle applicazioni. E come sottolinea Brendan Burns, corporate vice president Azure Compute di Microsoft, “Red Hat Enterprise Linux per Microsoft Azure consente una maggiore coerenza tra gli ambienti per gestire in modo più efficace l’utilizzo e i costi, aiutando le aziende a sbloccare nuovo valore di business nel cloud”.

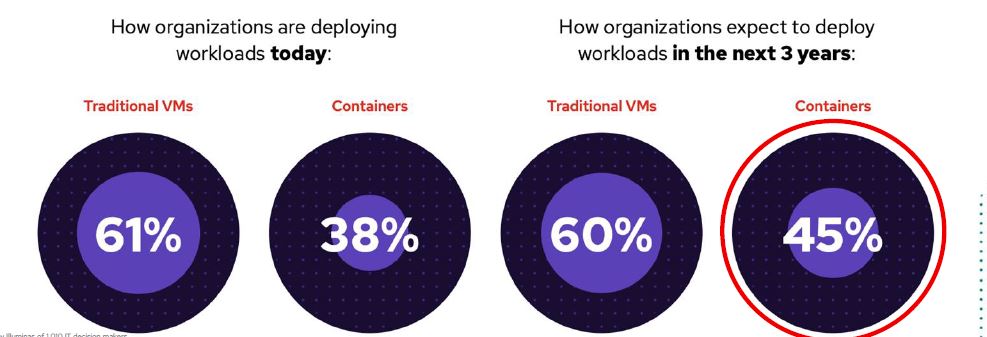

Virtualizzazione ancora centrale ma le aziende “cambiano”

Accanto all’AI e al sistema operativo, il Summit 2025 ha riservato ampio spazio al tema della virtualizzazione, sempre più strategico nel percorso di modernizzazione cloud-native. Ma, secondo una ricerca Red Hat – The State of Virtualization 2025 – condotta su oltre 1.000 decision maker IT, il 70% delle aziende ha già avviato migrazioni significative verso nuove piattaforme hypervisor, spinte dalla necessità di ridurre costi, complessità e lock-in ed il 43% ha in previsione di cambiare l’hypervisor nel corso dei prossimi tre anni o di affiancarne altri a quello in utilizzo ora nei progetti.

Red Hat risponde a questa domanda con la propria proposta di OpenShift Virtualization, che integra la gestione delle macchine virtuali direttamente su Kubernetes, grazie a KubeVirt. Questa convergenza consente di orchestrare in modo unificato sia workload container che VM, abilitando un’infrastruttura realmente ibrida, scalabile e automatizzabile. La disponibilità è già estesa a tutti i principali hyperscaler: Aws, Azure, Google Cloud e Oracle Cloud Infrastructure.

A supportare queste trasformazioni interviene inoltre l’evoluzione di Ansible Automation Platform, aggiornata anch’essa e ‘ri-presentata’ in occasione del summit. Con l’introduzione di Ansible Lightspeed, l’automazione beneficia di un assistente intelligente basato su AI, integrato nella UI della piattaforma per offrire troubleshooting rapido, suggerimenti contestuali e percorsi guidati per la gestione delle automazioni. Inoltre, nuove Ansible Content Collections dedicate all’infrastruttura AI estendono la copertura dei workload automatizzabili, sia on-premise che in cloud. Interessante, infine, il debutto di Red Hat In-Vehicle Operating System 1.0, prima distribuzione Linux certificata Iso 26262 per applicazioni automotive di sicurezza funzionale, a conferma della volontà di Red Hat di presidiare anche i mercati emergenti dell’edge computing industriale.

AI, cloud ibrido, sicurezza e automazione in un ecosistema aperto e collaborativo resta il mantra su cui l’azienda continua a imperniare lo sviluppo di. E’ un percorso che guarda al futuro prossimo dell’IT enterprise offrendo i mattoncini fondamentali per le aziende che devono affrontare la crescente complessità tecnologica senza rinunciare a flessibilità, governance e controllo.

© RIPRODUZIONE RISERVATA