Il dibattito sull’intelligenza artificiale ed il suo utilizzo nella gestione delle operations riguarda anche i temi dell’osservabilità e dell’automazione dei processi IT. Per questo il concetto di event-driven architecture (Eda) si configura come un paradigma caro ai Cio, ma ancora troppo poco esplorato al di fuori delle C-line più tecniche. Eppure, il suo potenziale nell’abilitare un’IT reattiva ed efficiente è significativo. Gli stessi analisti quando considerano il futuro delle architetture applicative, identificano l’Eda come uno dei pilastri per costruire sistemi agili e adattabili in ecosistemi digitali dinamici. Non si tratta più soltanto di gestire eventi in tempo reale su piattaforme “data-streaming” come Apache Kafka o Amazon EventBridge – strumenti utilizzati per la gestione e lo scambio di eventi in tempo reale – ma di orchestrare l’intero ecosistema IT attraverso segnali, trigger e pattern reattivi distribuiti.

Il paradigma event-driven, oltre la gestione applicativa

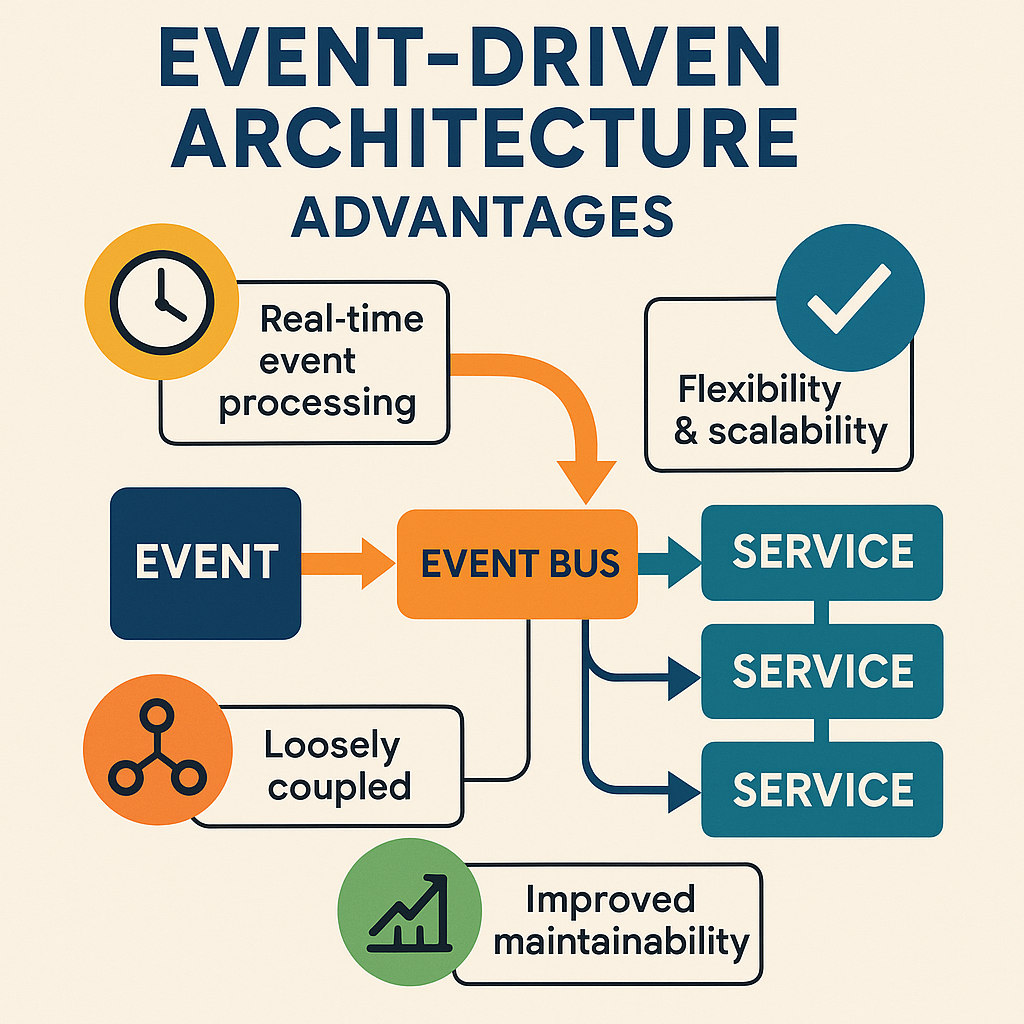

Tradizionalmente confinata ai discorsi su microservizi e architetture serverless, l’event-driven architecture viene spesso percepita come un tema da sviluppatori e ingegneri software. Tuttavia, quando la logica basata sugli eventi viene applicata in modo trasversale, può trasformare l’intera postura dell’organizzazione verso una modalità “reactive by design”. Secondo il report Tech Vision di Accenture (2024), il 68% delle aziende che ha adottato modelli event-driven a livello infrastrutturale ha registrato un miglioramento significativo nei tempi di risposta alle anomalie operative e di sicurezza. Il cuore dell’approccio, è da notare, risiede nella capacità di generare, catturare e reagire a eventi – cioè modifiche di stato – in modo asincrono, decentralizzato e immediato. Questo cambia il paradigma: dal “polling e batch processing” a un’azione guidata dai dati e dalla loro evoluzione in tempo reale.

Orchestrare il multicloud ibrido

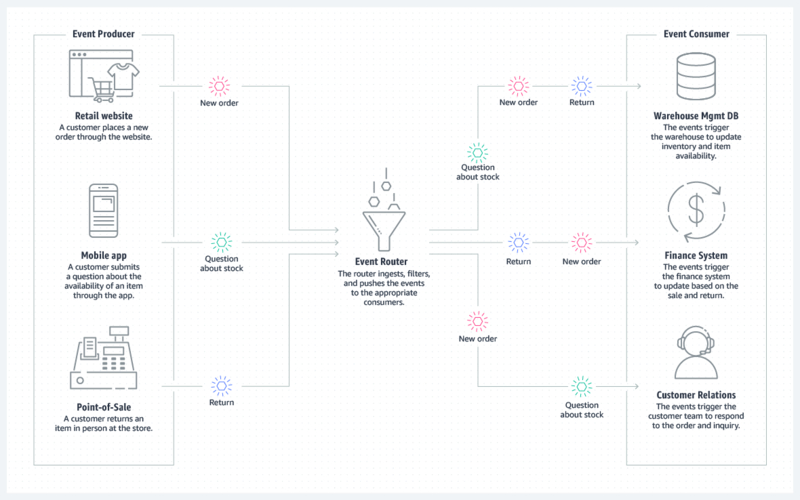

Un approccio IT mediato sul modello della event-driven architecture mostra la sua forza in particolare proprio negli ambienti multicloud ibridi, dove la complessità di sincronizzazione e integrazione tra sistemi eterogenei rappresenta una sfida quotidiana. Qui l’architettura basata su eventi abilita una comunicazione disaccoppiata tra servizi e applicazioni distribuiti, riducendo la latenza e a vantaggio della reattività.

In un ambiente dove coesistono workload in cloud pubblici, privati e on-premise, disporre di un layer di orchestrazione che reagisce a eventi piuttosto che a polling costanti consente un risparmio significativo in termini di risorse e una maggiore affidabilità operativa. Lo confermano anche i numeri di Idc, secondo cui le organizzazioni che implementano architetture reattive nei contesti multicloud ottengono una riduzione fino al 40% nei downtime legati a problemi di sincronizzazione e latenza tra ambienti disomogenei.

Data governance, controlli proattivi e conformi

Uno degli ambiti in cui l’Eda guadagna terreno è quello della data governance. In uno scenario regolatorio sempre più stringente – basti pensare al Gdpr, al Data Governance Act europeo e alla necessità di rendere tracciabili tutte le operazioni sui dati – l’Eda permette un controllo proattivo, automatico e continuo. Eventi come una modifica a un campo protetto, l’accesso anomalo a un dataset sensibile o la violazione di una policy possono generare istantaneamente alert, audit log o blocchi operativi. Le soluzioni più evolute di data governance, come quelle già proposte da alcune aziende, integrano già da tempo motori event-driven per la conformità in tempo reale. E Gartner stima che entro il 2026, il 60% delle soluzioni di data governance enterprise includerà moduli di rilevamento eventi nativi, una percentuale che solo tre anni fa era appena del 25%.

I vantaggi per la cybersecurity

Ancora più evidenti sono i vantaggi nell’adzione di un’Eda nell’ambito della cybersecurity. Le architetture tradizionali spesso si basano su log centralizzati e analisi ex post degli incidenti, con un notevole ritardo tra l’evento e la risposta. Al contrario, un’infrastruttura IT orchestrata tramite eventi permette di collegare direttamente strumenti Siem (Security Information and Event Management), piattaforme Soar (Security Orchestration, Automation and Response) e motori di AI comportamentale. In questo modo, un comportamento anomalo rilevato su un endpoint può innescare in tempo reale una catena di reazioni automatiche: isolamento della macchina, avviso al Soc, analisi forense. I numeri di Forrester dicono che le aziende che integrano flussi event-driven nella loro architettura di sicurezza riducono del 58% il tempo medio di risposta agli incidenti (Mttr). Si aggiungono quelli strettamente di mercato: a livello globale l’automazione della sicurezza raggiungerà un fatturato secondo Grand View Research toccherà il valore di 22,92 miliardi di dollari entro il 2030, con un tasso di crescita annuo composto (Cagr) del 14,0% tra il 2025 al 2030. Market&Markets stima che il mercato varrà 16,7 miliardi di dollari già entro il 2028, con un Cagr del 13,4% dal 2023 al 2028. E secondo Polaris Market Research la crescita è prevista persistere almeno per i prossimi dieci anni tanto da prevedere un valore di mercato di 38,09 miliardi di dollari entro il 2034, mentre Sns Insider prevede un valore di 27,82 miliardi di dollari entro il 2032.

Decentralizzazione intelligente all’edge

In ambienti caratterizzati da scarsa connettività o alta latenza, la possibilità di reagire localmente a eventi (ad esempio un sensore che rileva un’anomalia) senza attendere sincronizzazioni centrali è cruciale. Per questo con la crescita delle architetture edge – in settori come la produzione industriale, l’automotive, la sanità e l’agricoltura di precisione – il ruolo dell’event-drive architecture si amplifica. L’event-driven architecture consente una decentralizzazione operativa intelligente: ogni nodo può essere dotato di logiche di automazione autonome basate su eventi, aumentando l’efficienza e l’affidabilità del sistema complessivo. In questa specifica direzione, architetture come Aws Greengrass o Azure IoT Edge integrano già framework event-driven per supportare modelli di elaborazione near-real-time.

Il futuro dell’Eda con l’AI agentica e le sfide

Il futuro dell’automazione IT si muove verso scenari sempre più distribuiti, autonomi e intelligenti. L’espansione dell’intelligenza artificiale agentica – in cui software intelligenti prendono decisioni autonome in base a contesti dinamici – si sposa perfettamente con il modello Eda, che fornisce il substrato di stimoli in tempo reale a cui questi agenti possono reagire. Lo stesso vale per l’IoT industriale, dove milioni di dispositivi generano eventi che devono essere gestiti e orchestrati in modo efficiente. L’Eda agisce come uno strato di coordinamento decentralizzato, in grado di scalare dinamicamente, abilitando nuovi livelli di automazione e efficienza. Le architetture event-driven sono inoltre centrali per creare ambienti IT sostenibili. In particolare, la capacità di attivare risorse – come compute, storage o networking – solo in risposta a eventi specifici permette di ridurre i consumi e migliorare l’efficienza energetica. In ottica Esg, questo paradigma può quindi supportare le aziende nel percorso verso una carbon neutrality IT, contribuendo all’ottimizzazione delle risorse.

Nonostante i vantaggi, la transizione verso un’architettura Eda non è priva di ostacoli. Uno dei principali è la complessità progettuale: progettare un sistema interamente basato su eventi richiede un cambiamento di mentalità, l’adozione di strumenti specifici (come broker di eventi, schemi asincroni, pattern pub/sub) e una governance rigorosa per evitare caos architetturale. Inoltre, la mancanza di standard universalmente adottati per la definizione degli eventi rappresenta un problema per l’interoperabilità tra sistemi. Intendiamoci, non mancano “standard” emergenti come CloudEvents (promosso da Cncf) da capire se e quando sarà possibile colmare del tutto il gap.

Un’altra sfida riguarda la visibilità e il debugging. In sistemi fortemente asincroni, tracciare il flusso degli eventi e diagnosticare anomalie può risultare più complesso rispetto ad architetture sincrone. Per questo, l’adozione dell’Eda deve essere accompagnata da strumenti avanzati di observability e tracing distribuiti e unificati. Di fatto nel grande “affresco” della trasformazione digitale, l’Eda si colloca come un layer infrastrutturale oggi ancora solo quasi invisibile ma cruciale. Non è semplicemente una tecnologia emergente nel senso classico, quanto piuttosto un paradigma maturo che – applicato in modo sistemico – può portare l’automazione IT a un livello superiore. E le diverse applicazioni considerate mostrano come l’Eda non sia soltanto un’opportunità tecnica, ma una leva strategica per costruire un’IT reattiva, efficiente e sostenibile. Decentralizzazione e autonomia operativa, poi, con l’AI agentica sono ineluttabili per chi vuole costruire sistemi pronti al futuro.

© RIPRODUZIONE RISERVATA