Sono i giorni di Snowflake Summit 2025, a San Francisco, per il vendor occasione per ribadire la sua visione strategica anche alla luce degli annunci tecnologici che convergono nel definire l’evoluzione della Data Cloud platform di riferimento per la valorizzazione dei dati utilizzando Gen AI e AI agentica. Alla luce del claim Build the Future of AI and Apps, l’evento mostra come Snowflake stia evolvendo da una proposta squisitamente analitica a piattaforma unificata per dati, applicazioni e agenti intelligenti. Una trasformazione orientata quindi a ridurre la complessità che caratterizza le architetture dati tradizionali e a favorire un’esperienza d’uso più semplice, connessa e affidabile. Le aziende sono chiamate a generare valore da dati distribuiti, in formati eterogenei, con volumi crescenti e con vincoli stringenti di sicurezza e governance. Il modello di Snowflake vuole rispondere a queste sfide con una piattaforma gestita che automatizza i task operativi, scala in modo dinamico, semplifica il deployment e porta l’intelligenza artificiale direttamente dove risiedono i dati.

E’ lo stesso Ceo, Sridhar Ramaswamy, a mettere a fuoco la strategia, offrendo una riflessione sull’evoluzione dell’AI in ambito enterprise: “L’intelligenza artificiale rappresenta un momento di svolta, simile all’arrivo di Internet o della telefonia mobile. Non parliamo più solo di efficienza, ma di un modo completamente nuovo di concepire le funzioni aziendali”. Snowflake si propone allora come “piattaforma abilitante lungo tutto il ciclo di vita dei dati: dall’ingestion e normalizzazione fino alla governance e all’analisi avanzata”, con una crescente attenzione alla fruibilità anche per utenti non tecnici. “Vogliamo aiutare i nostri clienti a valorizzare i dati fin dal momento della loro nascita – quando si accede a un’applicazione o si utilizza un sensore – e a trasformarli in insight attivabili”, spiega il Ceo che insiste sull’importanza di garantire semplicità d’uso – “è possibile scrivere una query di due righe per elaborare petabyte di dati” – e sulla fiducia come fondamento dei servizi AI – “Le risposte dell’AI devono essere verificabili, perché per un Cfo sapere con esattezza il fatturato del trimestre non è un’opinione”. Ramaswamy richiama inoltre il valore democratizzante della piattaforma: “Oggi ogni impresa può creare prototipi AI in poche ore e con costi contenuti. È questa accessibilità a rendere reale la trasformazione”. Con oltre 5.000 clienti già attivi su soluzioni AI, Snowflake si posiziona allora come un ecosistema AI-native pensato per “fare di più con i dati”.

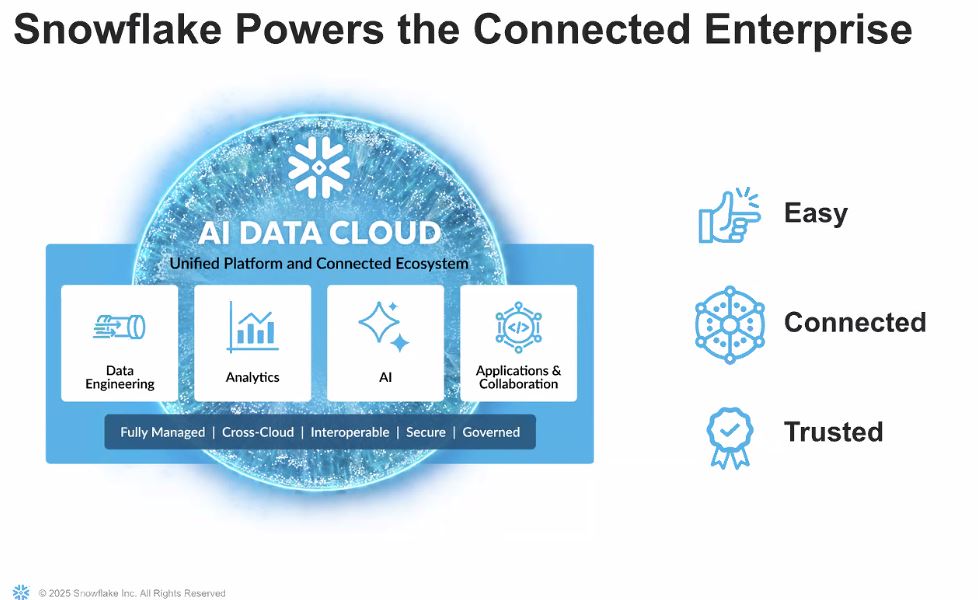

Tre allora i pilastri che orientano lo sviluppo della proposta: semplicità d’uso, connettività dei/tra i dati sia all’interno di un’organizzazione che tra diverse aziende e affidabilità “serve garantire che solo le persone autorizzate abbiano accesso ai dati sensibili. Pilastri che si integrano nel mandato fondativo di Snowflake: “Vogliamo abilitare ogni impresa sul pianeta a realizzare il proprio pieno potenziale attraverso dati e AI”, conclude il Ceo.

Snowflake AI Data Cloud Platform

L’architrave della proposta Snowflake è AI Data Cloud proposta come piattaforma unificata e completamente gestita che consente a organizzazioni di qualsiasi dimensione di archiviare dati in modo scalabile e sicuro, eseguire workload analitici, applicativi e di intelligenza artificiale, condividere dati e applicazioni tra team, aziende e settori e fare questo in modo cloud-agnostico, ossia su Aws, Azure come su Google Cloud Platform, con performance coerenti e governance centralizzata.

All’interno di questa architettura, la computazione (cioè l’uso delle risorse per eseguire operazioni) è separata dallo storage: questo consente a Snowflake di scalare dinamicamente ed eseguire in parallelo molteplici workload.

Ecco che nell’ambito di questa proposta l’introduzione della Standard Warehouse Generation 2, ora in general availability – grazie a un upgrade dell’hardware sottostante e a ottimizzazioni software, garantisce prestazioni analitiche migliorate sensibilmente rispetto alla generazione precedente.

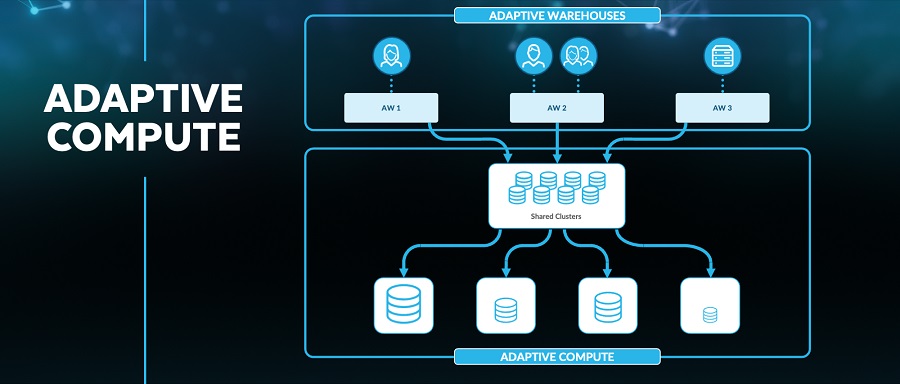

Ne parla Christian Kleinerman, Evp of Product: “Per i clienti significa tempi di risposta più rapidi, maggiore fluidità nella gestione dei carichi e una migliore esperienza utente, senza costi aggiuntivi”. All’interno della Data Cloud, la Standard Warehouse Gen2 apre la possibilità di “equilibrare potenza, costi e flessibilità, ed è pensata per workload ad-hoc e interattivi, operazioni BI intensive, supporto alle pipeline Etl gestite manualmente o con orchestratori esterni e per i task operativi ricorrenti in ambienti enterprise”. Per esigenze più avanzate in termini di dinamicità, auto-scaling e ottimizzazione automatica, Snowflake propone “in parallelo” le Adaptive Warehouses, basate su Adaptive Compute, ma sempre erogate all’interno dello stesso ambiente.

Adaptive Compute, in private preview, inaugura una nuova era nella gestione delle risorse di calcolo. “Si tratta di un servizio capace di dimensionare automaticamente i cluster, selezionare la configurazione più efficiente e sospendere o riprendere l’esecuzione in modo intelligente”. Le Adaptive Warehouses che ne derivano riducono la necessità di tuning manuale, permettendo di concentrare l’effort su innovazione e sviluppo applicativo. Tra le aziende operative in questa direzione, per esempio c’è Pfizer che ha già sperimentato l’approccio in ambienti critici per la ricerca biofarmaceutica, rilevando miglioramenti significativi in termini di produttività e time-to-insight. Il valore di questo approccio si moltiplica poi grazie alle nuove funzionalità FinOps-native: dal Cost-Based Anomaly Detection, ora integrato nell’interfaccia di gestione e accessibile anche da ruoli non amministrativi, come anche ai Tag-Based Budgets che consentono una governance granulare della spesa cloud. Snowflake, lo ricordiamo, si è unita come Premier Enterprise Member alla FinOps Foundation, contribuendo a definire gli standard di gestione economica per le architetture SaaS e PaaS.

Governance unificata e AI-driven

Un ulteriore asse di evoluzione riguarda la data governance, ambito sempre più centrale nella gestione di piattaforme enterprise multi-cloud. Con il rilascio di Horizon Catalog, Snowflake introduce una soluzione federata che unifica visibilità, sicurezza e discoverability, anche su dati esterni e tabelle Apache Iceberg. “Gli amministratori possono agire su asset distribuiti come se operassero in un unico repository, mantenendo la coerenza di policy e controlli”, dettaglia ancora Kleinerman. Elemento distintivo è l’integrazione dell’intelligenza artificiale nei flussi di discovery e gestione tramite Copilot for Horizon Catalog, un assistente conversazionale in linguaggio naturale (in preview) che riduce la complessità delle attività di data stewardship. Con un caso semplice ne spieghiamo una possibilità d’uso tipica: un data steward può interrogare il sistema chiedendo “quali dataset contengono dati personali in Francia” oppure “quali oggetti sono stati modificati negli ultimi 30 giorni da utenti esterni”. Il Copilot restituisce le risposte precise attese, attingendo ai metadati e alle policy di accesso. Il potenziamento poi di Trust Center include anche funzionalità di leaked password protection, protezione da IP compromessi, e Workload Identity Federation, che elimina la necessità di gestire credenziali statiche. In ottica compliance, Snowflake introduce quindi la disponibilità di snapshots immutabili per garantire la resilienza dei dati contro ransomware e incidenti, con possibilità di failover semplificato via UI.

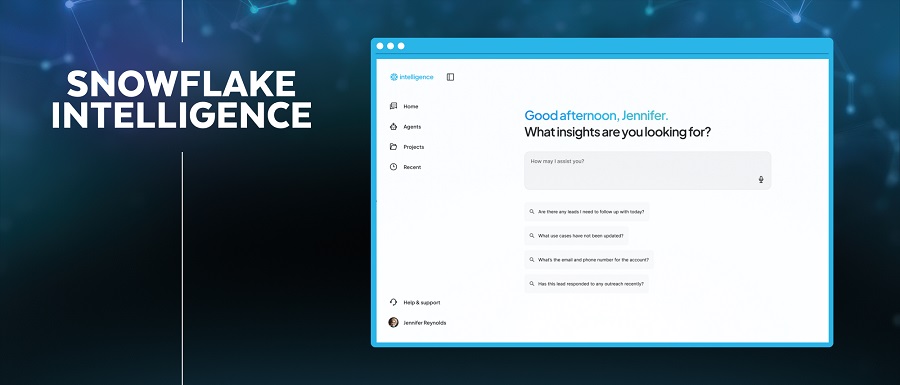

Snowflake Intelligence e Data Science Agent, democratizzare l’AI

Con il lancio di Snowflake Intelligence (presto in public preview), l’azienda intende rendere l’analisi conversazionale una capability di base accessibile a tutti i profili aziendali. Alimentato da modelli Llm di OpenAI e Anthropic, Intelligence permette di interrogare con linguaggio naturale dati strutturati e non, provenienti anche da fonti esterne come Google Drive, Workday, Box, Zendesk. L’agente AI interpreta la domanda, accede ai dati tramite Openflow, restituisce visualizzazioni e insight.

E, grazie alle Cortex Knowledge Extensions, le risposte possono essere arricchite con contenuti contestuali provenienti da Stack Overflow (ma anche fonti esterne come The Associated Press, Usa Today, per esempio) garantendo affidabilità e attribuzione. “Parliamo quindi di estensioni delle capacità di intelligenza artificiale della piattaforma, che permettono di integrare le risposte degli agenti AI con contenuti informativi esterni e proprietari, in modo sicuro, tracciabile e conforme alle logiche di licenza”, spiega Kleinerman. In parallelo, il Data Science Agent (in private preview) supporta i team ML automatizzando fasi cruciali del ciclo di vita di un modello: analisi, preprocessing, feature engineering, training e debugging. In ambito retail, ad esempio, è possibile generare pipeline per la previsione della domanda stagionale combinando dati storici, feedback da chatbot e sentiment da recensioni online.

L’interoperabilità per l’ingegneria dei dati

A sostegno di questa visione, Snowflake rilascia Openflow, motore di integrazione dati multi-modale costruito su Apache NiFi, capace di gestire batch e streaming, dati strutturati e non. Spieghiamo: Apache NiFi, lo ricordiamo, è un progetto open source della Apache Software Foundation pensato per automatizzare il flusso di dati tra sistemi diversi e opera come piattaforma di data integration e data movement, che consente di progettare, monitorare e gestire pipeline di dati in tempo reale o in modalità batch. Ecco che con il modello Bring-Your-Own-Cloud è possibile ora eseguire Openflow su Aws, con centinaia di connettori pronti all’uso per sistemi come Proofpoint, Google Ads, ServiceNow. L’integrazione con Snowpipe Streaming consente ingestion in tempo reale con latenza di pochi secondi, mentre il supporto per dbt Projects e un nuovo ambiente di sviluppo file-based integrato (Snowflake Workspaces) permettono di sviluppare pipeline complesse con assistenza AI, git nativo e confronto visuale delle versioni.

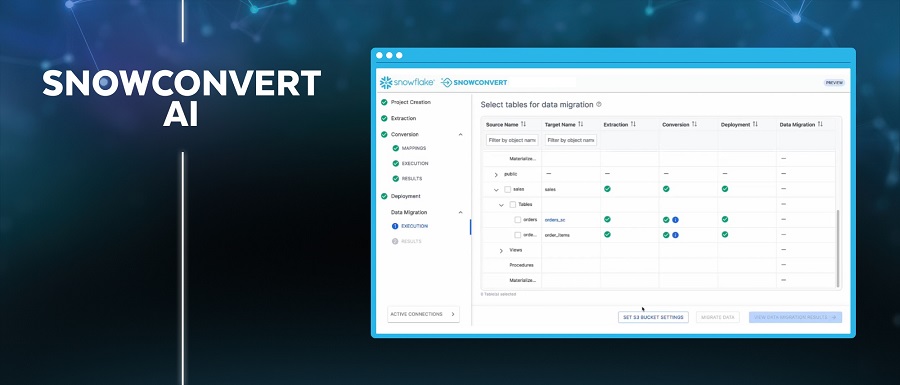

Analytics ripensati in chiave AI-native

In ambito analytics, il rilascio di Cortex AISql in public preview estende il linguaggio Sql con funzionalità AI-powered, permettendo di interagire con dati non strutturati come documenti, immagini, testi e audio. “Questo consente a un analista di estrarre insight da trascrizioni o classificare immagini direttamente da una query Sql, senza scrivere codice Python o usare strumenti esterni”. Le ottimizzazioni in preview promettono miglioramenti prestazionali del 30-70% e un risparmio fino al 60% sui costi di query complesse. In ambito finance, clienti come TS Imagine stanno utilizzando AiSql per analizzare documenti di mercato e generare strategie algoritmiche. Invece grazie all’utilizzo di SnowConvert AI, la migrazione da piattaforme legacy viene automatizzata attraverso agenti intelligenti che analizzano e convertono codice, workflow Etl e report BI in modo affidabile. Il tool riduce i tempi di conversione di 2-3 volte, abbattendo i costi e i rischi di modernizzazione.

Marketplace e dati pronti per l’AI

Nel declinare la proposizione perché sia fruibile, Snowflake porta a San Francisco anche un rinnovato Snowflake Marketplace che ospita oggi oltre 3mila asset e introduce le Agentic Native Apps, applicazioni agentiche interoperabili che possono essere installate e utilizzate nativamente senza muovere i dati. Grazie alla condivisione dei modelli semantici, ora è possibile integrare nei propri agenti AI definizioni standardizzate di dati strutturati, condivise tra i fornitori. Le imprese possono così interrogare i dati usando linguaggio naturale con risultati coerenti e allineati a modelli condivisi. Un ulteriore vantaggio è legato al fatto che i contenuti delle Cortex Knowledge Extensions sono accessibili solo via retrieval-augmented generation (Rag), garantendo la possibilità di revoca dei diritti da parte dei fornitori in qualsiasi momento e tutelando la proprietà intellettuale.

L’insieme delle novità e degli annunci presentate in occasione di Snowflake Summit 2025 delinea di fatto uno scenario per cui la piattaforma non è più soltanto un motore di analytics ma un ecosistema AI-native, capace di orchestrare dati, applicazioni e agenti in modo sicuro, efficiente e scalabile. L’obiettivo è chiaro: abilitare le imprese a costruire più rapidamente applicazioni intelligenti, partendo da una base dati unificata, governata e pronta per l’AI all’interno di una visione che rende attuale e già concreto il futuro dell’”enterprise AI”.

© RIPRODUZIONE RISERVATA