Minority Report, famoso film di Spielberg del 1999, presentava il protagonista Tom Cruise districarsi tra video, grafici e presentazioni di dati, utilizzando uno schermo 3D, dei guanti speciali e semplici gesti delle mani. Come spesso accade, ciò che prima appare in un film di fantascienza diventa realtà… e non servono nemmeno i guanti.

Le Natural User Interface costituiscono un’evoluzione dell’interazione uomo-macchina, successiva alle GUI (Graphic User interface). Se nel caso delle interfacce grafiche, l’utilizzo di “metafore” del mondo reale come desktop, cestino o menu hanno consentito agli utenti di non dover memorizzare particolari comandi da tastiera, le interfacce naturali consentono di superare proprio questo tipo di metafore astratte e avvicinarsi ad interazioni ancora più umane.

Infatti, progettare una NUI significa sfruttare competenze già esistenti, come i meccanismi di comunicazione caratteristici degli esseri umani. Queste si riferiscono a gesti e azioni che la maggior parte delle persone compie quotidianamente, come il linguaggio conversazionale, il tatto o la gestualità.

Sensi umani all’opera

Le principali tipologie di interfacce utenti naturali sfruttano il principio di alcuni dei principali sensi umani:

- Tatto: touch screen e gestualità multi-touch, come lo schermo di smartphone e tablet, ma anche sistemi di interazione touchless basati soltanto sulla rilevazione della gestualità umana tramite sensori

- Suono: sistemi di riconoscimento vocale, come attualmente presenti nei principali assistenti vocali/digitali di smartphone e computer, e in interfacce conversazionali come Amazon Echo

- Vista: utilizzo della fotocamera per consentire a computer e dispositivi di “vedere” e “leggere” l’ambiente circostante. Funzionalità di questo tipo sono presenti in Google Translator e consentono di tradurre direttamente sullo schermo il testo inquadrato in un altro linguaggio; l’utilizzo della fotocamera come uno scanner con funzionalità come l’OCR (Optical Character Recognition) o situazioni di Realtà Aumentata, dove informazioni addizionali sono mostrate nell’inquadratura della telecamera in aggiunta alla realtà circostante.

Natural User Interface: i primi casi d’uso

Un primo esempio di NUI è costituito dal lavoro di Jefferson Han nel 2006, Perceptive Pixel. Durante una dimostrazione al TED, Han mostrò diverse modalità d’interazione direttamente con il contenuto dello schermo, tramite manipolazioni diretta e gesti. Per esempio, per modificare la forma di una massa gelatinosa sullo schermo, Jeff letteralmente “pizzicava” la materia informe direttamente utilizzando le proprie dita.

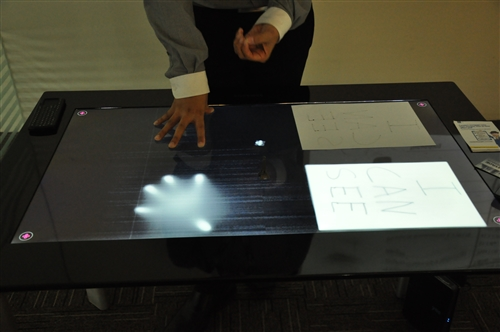

Microsoft PixelSense, i cui primi sviluppi risalgono al lontano 2001, ma la cui versione attuale è entrata in commercio nel 2008, include anche un dispositivo ottico in grado di riconoscere gli oggetti posti sopra di esso. PixelSense è infatti una vera e propria superfice multitouch che, oltre a essere un tavolo, è ad esempio in grado di riconoscere un piatto o un bicchiere di vino come tale e di visualizzare i contenuti associati a quel bicchiere. I clienti di PixelSense comprendono principalmente ristoranti, hotel e luoghi d’intrattenimento pubblico, ma anche studi di telegiornali che utilizzano ormai da alcuni anni questo strumento per mostrare la rassegna stampa al pubblico.

Alcuni scenari applicativi

Le NUI, proprio per la loro semplicità d’utilizzo, sono particolarmente indicate in contesti dove si vuole favorire una maggiore customer engagement, come nel caso di console di videogame, o totem e camerini virtuali in ambito in-store, grazie alla combinazione di sensori di movimento avanzati, telecamere e microfoni in ambiente 3D.

Lungi comunque dall’avere solo una funzione di mero intrattenimento, le NUI favoriscono una migliore user experience anche in contesti dove l’utilizzo non solo di periferiche esterne (come mouse e tastiera), ma in alcuni casi anche di touchscreen, risulta impossibile. Ad esempio, contesti rumorosi come negozi, centri commerciali o anche stabilimenti: innovazioni come il Progetto Pirelli di TeoLab nascono infatti dalla necessità di favorire l’interazione degli operai con strumenti informatici senza togliere i guanti da lavoro.

Il futuro? Computer sempre più “percettivi” grazie all’Intelligenza Artificiale.

Grazie agli avanzamenti in ambito computer vision e audio processing, che rientrano nella vasta gamma di applicazione dell’Intelligenza Artificiale, i computer sono via via sempre più in grado di percepire il mondo intorno a loro, acquisendo e processando immagini, suoni e conversazioni. Ad esempio, grazie alla capacità dei computer di vedere e riconoscere anche elementi peculiari della realtà circostante, strumenti di riconoscimento facciali stanno diventando la nuova normalità come strumento di sicurezza per sbloccare gli smartphone o abilitare pagamenti.

L’IA non è solo costituita da sofisticati algoritmi produttivi o da robot operai che potrebbero sconvolgere il mercato del lavoro, ma anche, e forse soprattutto, da dispositivi con cui gli esseri umani potranno interagire in maniera via via sempre più naturale, permettendo ad una fascia sempre più ampia della popolazione di avere accesso alla tecnologia, ed ai servizi avanzati che essa può offrire, con un grado di formazione minimo o inesistente. Grazie alle natural user interface.

“What’s next?” quando si parla di futuro.

Non perdere tutti gli approfondimenti della Rubrica WhatsNext

© RIPRODUZIONE RISERVATA