La lezione che si porta a casa ripercorrendo keynote e annunci di Microsoft in occasione di Build 2019 è l’importanza di pensare ed essere “cloud-native” nel senso più esteso del termine.

L’atteggiamento va ben oltre il semplice sviluppo applicativo, che in una Build resta ovviamente tema base, e che quest’anno si lega con rigore ad AI e machine learning. Intorno a questo messaggio è possibile far ruotare tutta una serie di annunci, oltre la semplificazione fin troppo comoda di “Linux che entra in Windows”, e anche oltre l’idea semplicistica per cui Microsoft è “Windows+Office+Cloud”.

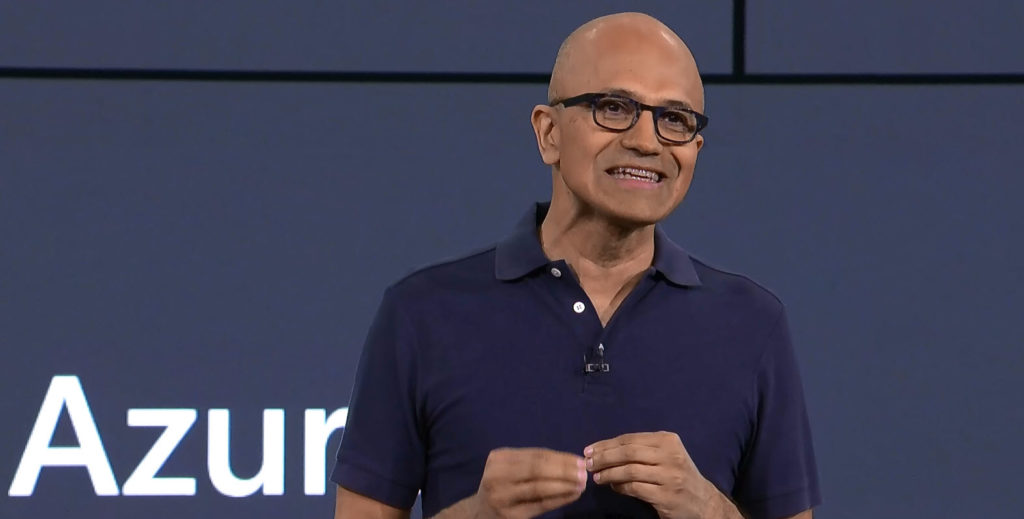

Satya Nadella documenta con le scelte sul campo, cosa significhi essere “cloud-native“: sposare le soluzioni che portano prima al risultato in cloud.

Il Ceo di Microsoft dal 2014 ha spostato il baricentro dell’azienda dal pc al cloud e ha cancellato ogni anatema nei confronti dell’open source.

Quest’anno partecipa in prima persona a Red Hat Summit e avvia un programma congiunto Azure/OpenShift per cui i clienti possono integrare le applicazioni containerizzate gestite con Kubernetes nei workflow Azure.

Oggi Nadella riconosce anche che, se Kubernetes è un servizio di orchestrazione migliore di quello sviluppato in casa, tanto vale automatizzare la distribuzione delle applicazioni containerizzate con Kubernetes piuttosto che ostinarsi con Azure Container Service. Obiettivo: prendere il meglio sia di ciò che è stato fatto in casa, sia di quello che ha fatto la community.

Microsoft aderisce anche alla Cloud Native Computing Foundation (dal 2017) e nelle sue fila conta oggi Burns, ex Google, che di Kubernetes vanta la paternità.

Anche la partnership con Docker è strategica perché semplifica lo sviluppo e il testing applicativo. Insomma, conta davvero il risultato. Ed è palpabile con mano, nella community, che le svolte di Nadella piacciono in primis proprio agli sviluppatori che hanno “mano libera” nello scegliere quello che serve, per fare bene.

Accelerare lo sviluppo

L’intuizione di Nadella non è un’eccezione. L’accelerazione sullo sviluppo cloud native e l’apertura in questo senso per “fare presto” appena quattro settimane fa è stato il mantra anche in occasione di Google Cloud, con tutte le evoluzioni di Cloud Code. Allora Pali Bhat, Google Cloud vice president product and design disse: “E’ come beneficiare di una turbocarica nello sviluppo delle app”.

Andiamo oltre. Cloud native computing ed edge computing oggi rappresentano due indirizzi chiari di sviluppo. Nel primo caso si può parlare di una sorta di cloud di seconda generazione, quello in grado di offrire un ritorno degli investimenti superiore, perché beneficia anche della filiera applicativa nativa, mentre l’edge computing prevede la possibilità di portare computing intelligente ed autonomo in periferia, vicino agli oggetti.

AI e machine learning nel codice

E a Build 2019 emerge bene l’idea per cui le potenzialità di AI e machine learning, collaudate in cloud, arriveranno per inferenza at the edge. Appunto, l’Intelligent edge. Microsoft ha annunciato un nuovo linguaggio di modellizzazione aperto per connettere i dispositivi IoT al cloud come risposta a una specifica richiesta degli sviluppatori, che desiderano applicare le proprie soluzioni IoT su vasta scala.

La centralità di AI e machine learning per lo sviluppo ritorna nelle novità presentate da Scott Guthrie, executive vice president di Microsoft Cloud, che chiama a raccolta gli sviluppatori per “sfruttare i servizi di Azure e integrare l’intelligenza artificiale nelle nuove applicazioni” (in Azure Cognitive Services entrano Decision e Personalizer che serve a prendere decisioni efficienti).

Mentre l’AI pervade Azure, che beneficia delle funzionalità di cognitive search per estrapolare nuovi insight da contenuti strutturati e non.

Infine, Microsoft propone in preview la possibilità di archiviare gli insight AI ottenuti dalla cognitive search, migliorando la creazione di esperienze grazie alle visualizzazioni Power BI o a modelli di machine learning. In ambito machine learning con l’integrazione delle funzionalità MlOps in Azure DevOps vengono offerte automazione, riproducibilità e possibilità di effettuare audit nel ciclo di vita ML end-to-end.

© RIPRODUZIONE RISERVATA