Sarà completato entro la prima metà di quest’anno il progetto ambizioso di Meta riguardo la realizzazione di un super computer dedicato per l’intelligenza artificiale e denominato AI Research Supercluster (Rsc). E’ l’azienda a darne l’annuncio sul suo blog in cui spiega le sfide nella realizzazione del progetto, ma anche le ambizioni e l’importanza dei supercomputer per il metaverso.

Rsc, ancora prima della conclusione del progetto, è già utilizzato dai ricercatori di Meta per l’addestramento sui modelli di elaborazione per il riconoscimento del linguaggio naturale (Nlp). Si parla di un addestramento che deve includere miliardi di miliardi di esempi nelle diverse lingue per essere effettivamente utile, e prevedere l’analisi senza soluzione di continuità di testi, immagini, video, per realizzare il sogno di rendere possibile la traduzione vocale in tempo reale, così da consentire effettivamente la collaborazione istantanea tra i team dei diversi progetti di ricerca di ogni parte del globo, senza bisogno di conoscere una lingua diversa da quella propria nativa. Uno dei tanti tasselli necessari per la realizzazione del metaverso in cui le applicazioni e i prodotti basati sull’AI svolgeranno un ruolo chiave.

Si tratterà infatti di riuscire a rendere comprensibili, a tutti, anche le conversazioni nei nuovi ambienti virtuali tra persone di vari idiomi, nei contesti più ampi e svariati, con un pieno controllo dei sistemi riguardo i rumori ambientali, di fondo, i suoni, etc., senza poi perdere di vista quello sui contenuti nei molteplici domini operativi in cui l’utilizzo di AI e robotica possono portare significativi vantaggi. Meta investe nel comparto dal 2013, data della creazione del laboratorio per l’AI di Facebook.

La prima generazione di un’infrastruttura di calcolo di questo tipo è stato progettata nel 2017, era in grado di sfruttare le risorse di ben 22mila Gpu Nvidia V100 Tensor Core, in un unico cluster; l’infrastruttura è stata di riferimento per i ricercatori di Meta anche nello sviluppo dei progetti successivi. L’azienda però, all’inizio del 2020, ha deciso di riprogettare una nuova infrastruttura di calcolo da zero per sfruttare effettivamente i passi in avanti compiuti dalle più recenti Graphic Processing Unit, per addestrare modelli in grado di valutare miliardi di miliardi di parametri su set di dati, ognuno nell’ordine degli exabyte di informazioni.

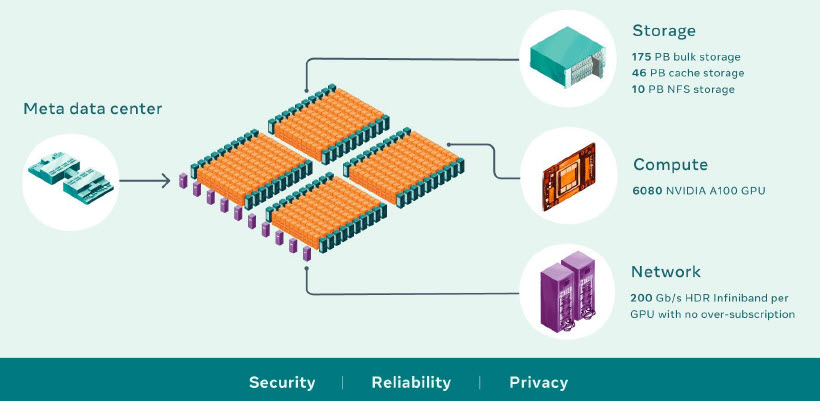

In particolare Meta AI Rsc oggi combina le capacità di 760 sistemi Nvidia Dgx A100 (nodi di elaborazione), per complessive 6.080 Gpu A100 (molto più potenti dei sistemi V100 utilizzati in precedenza), che comunicano su rete Nvidia Quantum Infiniband alla velocità di 200 Gbyte al secondo. Anche il layer di archiviazione deve essere all’altezza delle sfide ambiziose. In questo caso si parla di 175 petabyte di flash array Pure Storage, con 46 petabyte di memoria cache Penguin Computing Altus e 10 petabyte Flashblade Pure Storage. Più nello specifico, il sistema di archiviazione coniuga le esigenze di servire un sistema di archiviazione su scala exabyte in un ambiente con larghezza di banda misurabile nell’ordine dei terabyte.

Per soddisfare le crescenti esigenze di larghezza di banda e capacità della formazione AI, Meta AI Rsc utilizza un servizio di archiviazione AI Research Store (Airstore, sviluppato internamente) che pre-elabora il set di dati da utilizzare per l’addestramento per preparare i dati che saranno utilizzati per addestrare i modelli. Dopo aver eseguito la preparazione una volta, il set di dati così ottimizzato può essere utilizzato per più esecuzioni di addestramento. Airstore ottimizza infine i trasferimenti di dati in modo da ridurre al minimo il traffico.

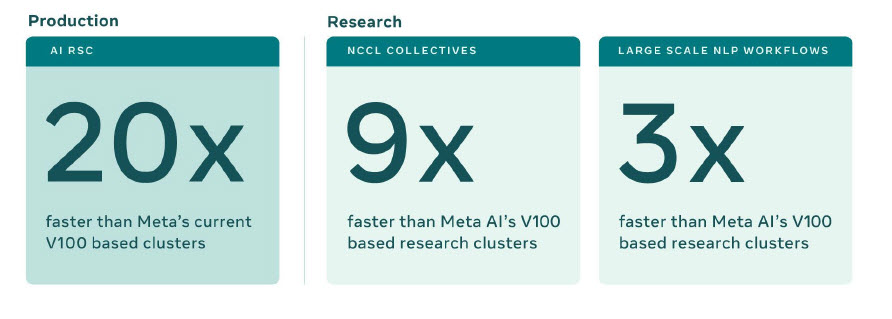

Risorse, architetture e sistemi così studiati consentono, secondo i benchmark, di completare l’addestramento di un modello con decine di miliardi di parametri in tre settimane, rispetto alle nove settimane necessarie prima. Scalare le prestazioni è tra le difficoltà maggiori per questa tipologia di sistemi. E’ previsto che, una volta completata l’implementazione, Meta Rsc potrà contare su un’infrastruttura di rete Infiniband in grado di collare 16mila Gpu come endpoint, rendendola di fatto una delle reti più grandi finora implementate. Questo con un sistema di memorizzazione nella cache e di archiviazione in grado di gestire 16 TB/s di dati di addestramento, scalabili fino a un exabyte. Facile immaginare anche tutte le sfide legate a sicurezza, affidabilità e privacy.

Sicurezza, affidabilità e privacy

In proposito, Meta specifica che mentre la precedente infrastruttura si basava solo su open source e set di dati aperti, Rsc permetterà analisi che includono esempi dal mondo reale catturate dai sistemi di produzione Meta, per formare i modelli, ed utilizzarli, per esempio, per l’identificazione di contenuti dannosi come per sviluppare ulteriormente la ricerca attraverso l’AI e migliorare l’esperienza degli utenti sulle piattaforme.

Ovviamente sotto la lente è il vero e proprio trattamento del dato. Rsc è stato progettato da zero tenendo conto dei problemi di privacy e sicurezza, in modo che i ricercatori di Meta possano addestrare i modelli utilizzando dati crittografati generati dagli utenti che non vengono decifrati fino all’istante prima dell’addestramento. Rsc è quindi isolato dalla rete Internet non prevede connessioni dirette in entrata o in uscita e il traffico può fluire solo dai data center di produzione di Meta.

Per soddisfare i requisiti di privacy e sicurezza, l’intero percorso dei dati dai sistemi di archiviazione alle Gpu è crittografato end-to-end, con i relativi sistemi di verifica. I dati vengono utilizzati con Rsc solo dopo rigorosi processi di revisione per verificare che effettivamente siano anonimizzati correttamente e crittografati con chiavi che vengono poi eliminate regolarmente, per essere certi che i dati meno recenti non restino accessibili e le operazioni di decrittografia vengono eseguite su un solo endpoint a salvaguardia di eventuali violazioni fisiche.

Non solo, Meta prevede che alcuni esperimenti potrebbero durare comunque diverse settimane e richiede l’impegno continuativo di migliaia di Gpu, evidente quindi come proprio il tema dell’affidabilità si riveli critico e sia stato indirizzato prima di tutto attraverso la scelta di partner storici con cui Meta ha già collaborato anche per il primo progetto (2017).

La realizzazione di Rsc ha superato inoltre tutte le sfide che possiamo immaginare legate al bisogno di riuscire a far collaborare i team in un momento critico come quello della pandemia, quindi un intenso utilizzo della collaborazione da remoto, ma anche i problemi legati al superamento delle diverse difficoltà di approvvigionamento e poi di trasporto in sicurezza dei componenti (come dei materiali, del cablaggio e poi dei rack ultimati) in un contesto difficile come quello attuale.

Le sfide per il futuro

Meta, con questa realizzazione, si aspetta non solo di offrire modelli di AI molto più accurati rispetto al passato, ma vuole ovviamente prepararsi ad abilitare esperienze utente nuove e più ricche nel metaverso. E Rsc è tra le tecnologie fondamentali che potranno alimentare la “voracità” di risorse del nuovo ambiente; un tema che sarebbe interessante capire come Meta intende affrontare e “coniugare” con quello della sostenibilità. Anche perché lo sviluppo di Rsc è ancora in corso. Una volta terminata l’opera, il sistema sarà capace di 5 exaflop di operazioni di calcolo al secondo, potrà contare su 16mila Gpu (ora sono 6.080) e la struttura Infiniband si espanderà ulteriormente, mentre il sistema storage potrà sfruttare ben 16 Tb/s di banda.

© RIPRODUZIONE RISERVATA