In Italia il business di Hpe è guidato da Claudio Bassoli, presidente e amministratore delegato di Hewlett Packard Enterprise, che declina la strategia impostata a livello mondiale, a partire dai due eventi annuali che dettano roadmap e intenzioni: Discover di Las Vegas a inizio estate e Discover di Barcellona in autunno, con annunci in ambito AI e hybrid cloud. “Due ambiti che vanno ad incidere sui business dei nostri clienti pubblici e privati, grandi e piccoli” esordisce Bassoli, incontrato in settimana a Milano, che declina entrambi le strategie.

Intelligenza artificiale e partnership

Partiamo dall’AI che ha visto procedere Hpe lungo tre direzioni: una più tecnologica di ampliamento dell’offerta in ambito infrastrutture e supercalcolo, attività partita più di 6 anni fa che sta avendo impatto rilevante sul mercato. Una più di natura realizzativa, legata alla capacità di mettere a terra progetti concreti di infrastrutture reali, come la realizzazione dei supercalcolatori di Eni per gestire potenza di calcolo, Llm e GenAI. Infine, la capacità di stringere relazioni con l’ecosistema in particolare grazie all’annuncio dell’alleanza industriale con Nvidia e Deloitte. “Sono alleanze in cui siamo tutti complementari: nel caso di Deloitte, noi offriamo la tecnologia, Deloitte studia gli impatti sui processi delle aziende delle Roi di AI, solo insieme possiamo aiutare le aziende a capire come modificare i processi per ottenere i miglior Kpi dall’introduzione dell’intelligenza artificiale. Deloitte fa un lavoro che non facciamo noi: guarda come impatta l’AI sui processi, è un approccio fondamentale grazie anche all’AI Act che detta le regole”.

Con Nvidia si sono definiti i pc AI, soluzioni di AI pacchettizzate, veicolate con l’offerta Greenlake, che permettono ai clienti di installare soluzioni chiavi in mano, abbattendo i costi di ingresso all’AI per le Pmi. “Mantenere le infrastrutture aggiornate è un must per ogni cliente di qualsiasi dimensione, per rimanere sul mercato – precisa Bassoli -. Continuiamo a fare annunci anche in ambito sicurezza e disaster recovery (Hpe Zerto) con funzionalità all’avanguardia”.

Cloud ibrido e Greenlake

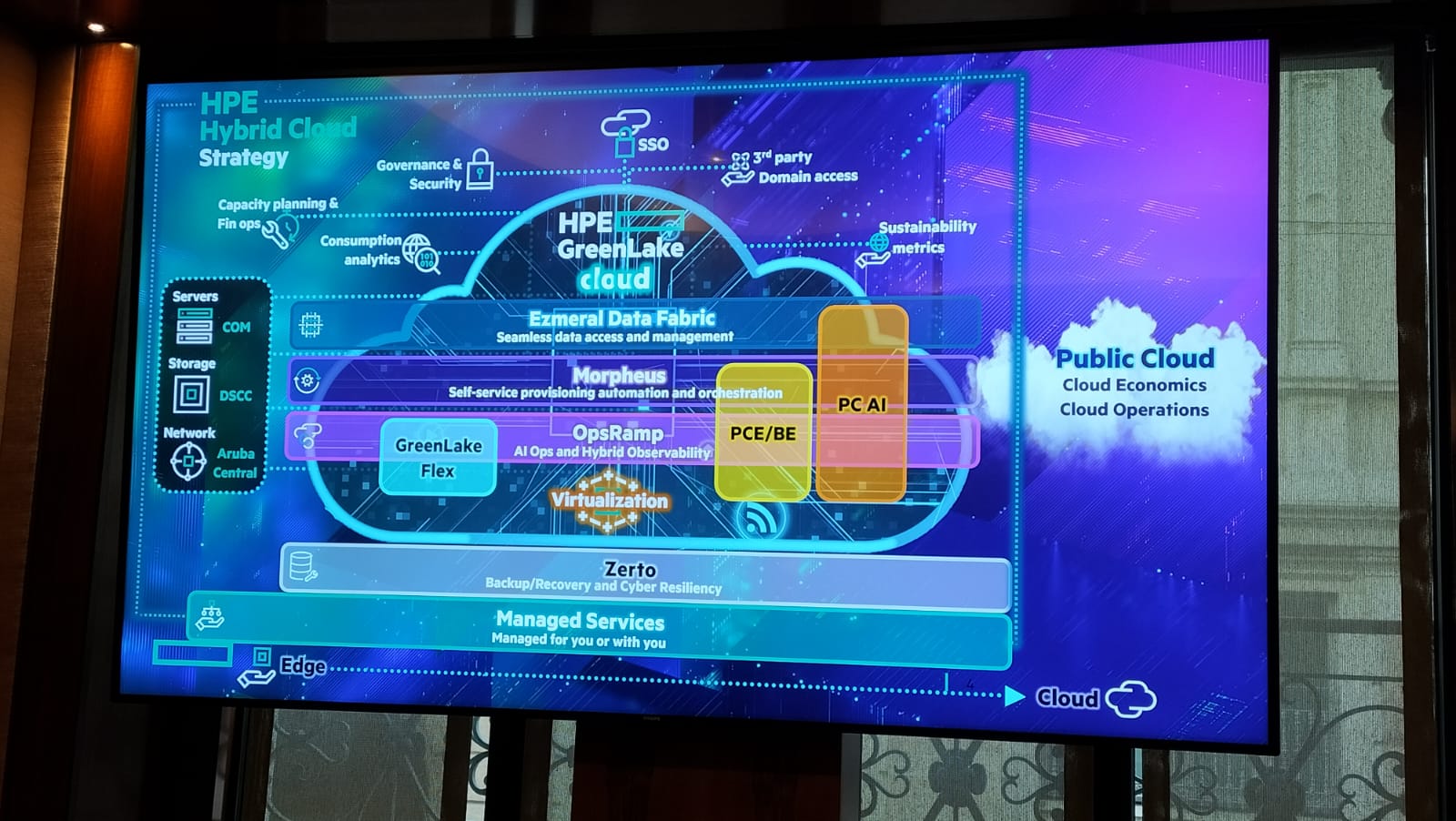

Il secondo stream di annunci è legato a hybrid cloud. “Anche in questo contesto le direttrici sono diverse: si parte sempre da una impronta tecnologia forte perché siamo un’azienda di ingegneria”, scherza Bassoli, spiegando che tra chi predilige tecnologie on-prem o le modalità di cloud pubblico, la terza via scelta da Hpe è quella del cloud ibrido che poggia sulla offerta Greenlake, che eroga in modalità as a service qualsiasi tipo di tecnologia. Una proposta cresciuta sia lato offerta sia lato quote di mercato anche con soluzioni in ambito storage ad alte prestazioni (Hpe Alletra), soluzioni per la sovranità dei dati (Hpe private cloud) e soluzioni di gestioni dei workload di virtualizzazione (Hpe VM Essentials).

“Quando è nata Hpe, 8 anni fa, avevamo come obiettivo la riduzione quasi a zero dei costi di gestione delle infrastrutture complesse e la scelta di adottare la virtualizzazione ci ha permesso di lavorare con architetture hybrid cloud e multicloud. Un approccio che permette alle nostre infrastrutture di gestire anche il time to market”, precisa Bassoli.

Le sfide aperte

“In ambito AI e cloud il tema della capacità della rete rimane strategico e la divisione Aruba Network è parte integrante delle nostre reti da tempo – precisa Mauro Colombo, Technology & Innovation Sales director di Hpe -. Guardando avanti, l’acquisizione di Juniper (al momento al vaglio ancora delle autorità competenti americane, Ndr.) va proprio in questa direzione, amplificherà-ulteriormente le soluzioni di AI applicate alle reti non solo su wifi e datacenter ma anche su rete di connettività geografica”.

E incalza: “L’AI sta portando a crescenti esigenze di elaborazione poiché le applicazioni e i carichi di lavoro ad alta intensità di dati stanno rapidamente superando la capacità dell’infrastruttura tradizionale. Siamo in una situazione in cui c’è una crescita enorme dell’uso dei dati, nella loro generazione ma anche nelle richieste dei clienti di estrazione del valore da dati stessi, una nuova sfida legata ai nuovi modelli Llm e ad algoritmi sempre più complessi che richiedono maggiore capacità di elaborazione dati. Questo richiede un aumento di efficienza e efficacia maggiori performance ma nello stesso tempo una elevata attenzione alla sostenibilità“.

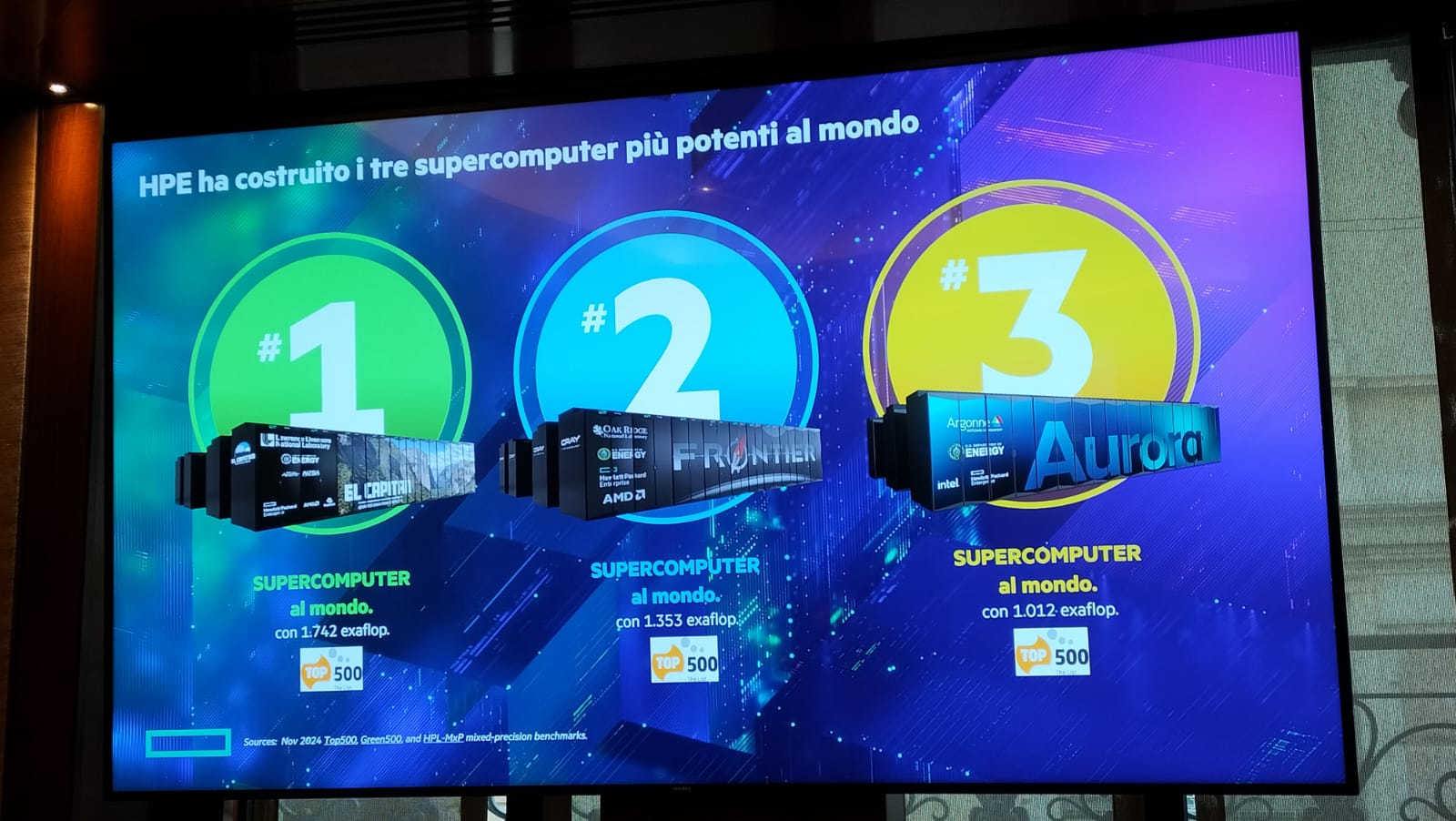

A inizio novembre, la nuova classifica dei supercalcolatori più potenti al mondo annoverava Hpe tra i fornitori delle prime tre strutture in Usa (El Capitan, Frontier, Aurora) ma anche dei super calcolatori europei. “Al quinto posto si colloca il supercalcolatore di Eni, progettato e realizzato in tre settimane dall’ordine, che è il primo supercalcolatore a livello europeo e primo di un’industria privata”, precisa Bassoli. Seguono, sempre con tecnologia Hpe, Alps (settimo supercomputer) e Lumi (ottavo).

“Per la prima volta, nei primi dieci supercomputer 4 sono europei e di questi 2 sono italiani, una riflessione che significa che l’Europa sta investendo per colmare il gap con Usa. I supercalcolatori sono parenti stretti dell’AI. Non ci sarebbe ChatGpt senza il supercalcolo, e non esisterebbero una serie di scoperte meteo, cyberspace, pharma, materiali senza queste infrastrutture, che oltre alla potenza guardano con molta attenzione all’efficienza energetica”.

Su questo tema il rilascio della prima architettura AI con raffreddamento a liquido diretto 100% fanless (frutto di 300 brevetti) che ha portato alla realizzazione del supercomputer El Capitan, che oltre ad essere tra i più veloci al mondo è anche tra i più efficienti dal punto di vista energetico.

Cosa chiedono le aziende

Ad oggi Hpe sta rispondendo alla richiesta di clienti riguardo alla introduzione dell’AI per la manutenzione predittiva, per poter riversare parte del budget verso nuovi investimenti e non sul mantenimento dell’esistenze, risolvendo problematiche legate a costi di gestione e fermi, anche nell’ambito delle reti. “Ma molta richiesta è legata anche all’ambito dello sviluppo dei software – precisa Bassoli -. Ormai non esiste sviluppo applicativo senza AI. Anche il nostro storage ha un cuore di AI che capisce come funzionano gli applicativi e permette di dare loro in pasto i dati senza spostarli (da acquisizione di 5 anni fa). C’è ormai pervasività dell’uso di AI in tutte le business unit, che viene vissuta come un tool a disposizione dei clienti, tecnicamente quasi banale da utilizzare ma che regala delle opportunità importanti”.

In Italia c’è un grande interesse verso l’AI da parte dei grandi clienti (le Big 500), che nella maggior parte dei casi stanno realizzando progetti in ambito d’ufficio per aumentare efficienza ed efficacia. “Tutti i clienti hanno un po’ sperimentato l’AI su cloud pubblico e pensato in quali ambiti adottarla. Tra i 500 grandi clienti, una trentina sta iniziando a testare l’AI nel cloud pubblico per valutare poi cosa sviluppare su una infrastrutture privata, dedicata. Abbiamo già alcuni clienti in ambito finanziario, aeroportuale, industriale, nell’ambito del controllo di qualità con immagini ad alta risoluzione che stanno valutando delle progettualità importanti per modificare i loro processi”.

Ma serve ancora una spinta decisiva perché il mondo delle imprese comprenda le opportunità, senza farci sopraffare dagli altri Paesi, con attenzione anche all’ambito PA. “Penso che una delle cose più “banali” da automatizzare sia la gestione dei dati della PA ora che con Data Act e AI Act si può accelerare. Abbiamo dei settori e delle aziende che sono leader nel mondo per una loro idea. La sfida è far si che questa competenza sia messa in un motore di AI per mantenere la leadership. L’Italia è da sempre fanalino di coda sul digitale come mostra l’indice Desi, per questo sull’AI c’è la necessità di correre più velocemente degli altri ma questo richiede maggiori investimenti. Rimane cruciale il tema della cultura perché se hai l’infrastruttura, ma non sai cosa farne, il problema rimane. Oltre all’infrastruttura bisogna far evolvere il mondo applicativo, per questo servono academy con tutte le aziende per fare corsi di formazioni alle imprese”.

“Stiamo facendo formazione sull’ AI anche ai nostri partner – incalza Paolo Delgrosso, Channel, Alliance, Oem & SP Sales director manager -. Abbiamo selezionato un numero ristrettissimo di partner per capire quali stream sviluppare con loro in ambito AI per poi inserirli nelle soluzioni. Finanziamo alcuni studi così come prima sponsorizzavamo la realizzazione di servizi Greelake di terze parti adesso ci siamo spostati sull’AI. Una media azienda ha bisogno di interlocutori preparati, perché è difficile per le realtà piccole accedere alle competenze di Deloitte. A queste aziende ci arriviamo grazie ai system integrator o a un numero ristretto di startup innovative che hanno soluzioni di AI per mercati specifici”.

Obiettivo 2025, per Bassoli, rimane crescere in market share nelle varie categorie di prodotti, rimanere partner dei grandi progetti italiani sia in abito supercomputer sia AI con infrastrutture importanti per il paese, ampliare le partnership con realtà territoriali e con quelle più innovative in ambito AI. Lontani i progetti sul quantum computing. “Sono ancora tecnologie da laboratorio, ancora instabili. Riteniamo che la tecnologia si stabilizzerà tra il 2030 e il 2040, oggi ha tassi di errore ancora molto elevati per pensare ad applicazioni commercializzabili, anche se ci sono molte realtà che stanno lavorando per stabilizzarlo. Tutto quello sviluppato per l’informatica non funziona sul quantum, per cui serve ri-sviluppare per fare porting delle applicazioni reali”.

© RIPRODUZIONE RISERVATA