In occasione di Dell Technologies World 2024, a Las Vegas, l’azienda tiene al centro dell’attenzione quelli che considera i principali passi in avanti compiuti nel campo dell’intelligenza artificiale per quanto riguarda l’integrazione del suo potenziale nei progetti a partire dal portfolio pc, nei data center, dall’edge al cloud – non solo risorse infrastrutturali, quindi, ma anche modalità di fruizione e servizi (nella declinazione Apex) -, per permettere alle aziende, ai professionisti ma anche agli utenti finali, ai semplici consumatori di computing, di apprezzare i benefici dell’AI. Ne parlano Sam Grocott, senior VP Product Marketing, con Varun Chhabra Svp Infrastructure Systems Group Marketing, e Shannon Champion, VP Product Marketing di Dell Technologies.

“Quando incontriamo i clienti – esordisce Grocott – semplicemente essi esprimono che con l’AI, in verità, non sanno da che parte cominciare: o mancano loro le competenze per realizzare soluzioni AI, o fanno fatica ad accedere ai dati rilevanti necessari per rendere l’AI davvero utile”. Oltre a questo sottolineano poi anche il tema dei “rischi, sia in termini di sovranità dei dati, sia per i timori legati alla perdita di proprietà intellettuale”, e ancora quello dei costi, “per cui non è per nulla scontato poi trovare casi d’uso con un reale ritorno degli investimenti”. Acquisire le risorse infrastrutturali necessarie, on-premise come in cloud, e le competenze per sostenere i progetti, preservando l’esposizione ai costi, è quindi tra i mantra alla base della Dell AI Factory, che possiamo definire come un approccio di ecosistema che comprende soluzioni a portafoglio dai pc, al data center, al cloud e all’edge. Grocott propone una simmetria interessante: “Come le fabbriche hanno alimentato la rivoluzione industriale, l’AI Factory contribuirà alla valorizzazione dell’AI”.

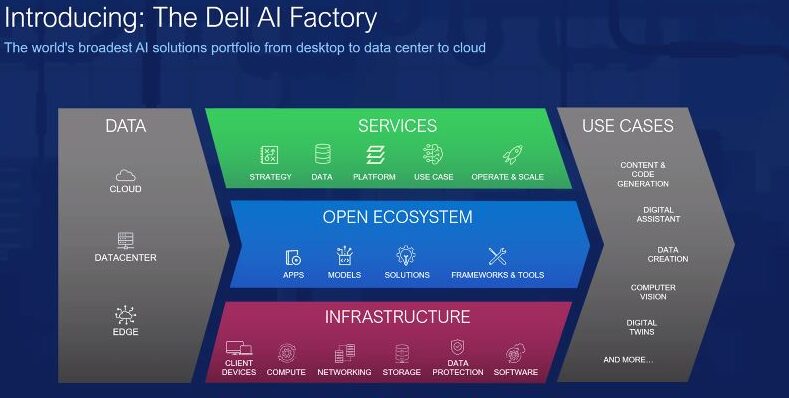

Cinque sono le componenti alla base di Dell AI Factory: i dati sono al centro, ovunque siano – in cloud, nei DC come all’edge – “e per questo l’AI deve essere il più vicino possibile ad essi”. La seconda componente, alla base di tre livelli (vedi foto sotto), è l’infrastruttura vera a propria – comprende client, server, workstation, storage, networking -. “Il livello appena sopra, ma fondamentale, è l’adozione di un ecosistema aperto“. Così come le fabbriche fisiche hanno bisogno di una solida supply chain, anche l’AI ha bisogno di un ecosistema dinamico costituito da modelli, soluzioni, framework e applicazioni. “Appena sopra vi sono i servizi, Dell Technologies con i partner porta la propria esperienza e le competenze per formulare strategie di implementazione efficaci, dimensionare correttamente le risorse, fornire assistenza, scalare all’occorrenza”.

Il risultato finale e ultimo componente strategico nella Dell AI Factory sono gli use case di riferimento, “quelli più ricercati dai clienti in difficoltà”, dettaglia Grocott. La possibilità di sfruttare le soluzioni end-to-end rappresenta un primo momento di semplificazione, così come lo spostamento dell’AI il più vicino possibile ai dati on-premise o all’edge che sia, “per consentire alle organizzazioni di conservare, controllare e proteggere realmente la propria proprietà intellettuale, a costi inferiori e controllati”. Dell lascia poi alle aziende la possibilità di scegliere come interpretare l’idea della ‘propria’ AI Factory anche per quanto riguarda la varietà di modelli di consumo (non solo l’acquisto, quindi, ambito in cui il modello Dell Apex è di riferimento). “La proposta è piuttosto quella di un percorso, seguito dai team dei servizi professionali per trovare la propria via verso la valorizzazione dell’AI”.

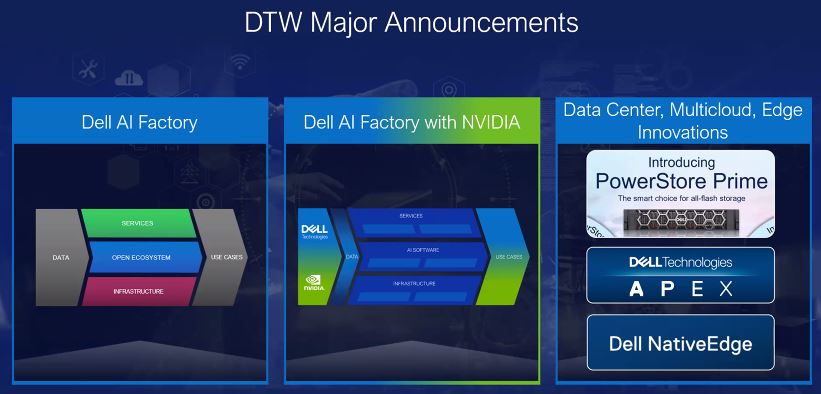

Tre i pilastri fondativi per quanto riguarda gli annunci: oltre alla declinazione concreta del modello AI Factory nelle risorse di computing, l’importanza della partnership con Nvidia, e le novità concrete nella proposizione per DC, multicloud, edge (Dell NativeEdge, ancora Apex, PowerStore Prime).

Intenzionalmente riassumiamo nei termini più sintetici possibili gli annunci relativi al mondo pc, illustrati da Kevin Terwilliger, VP, Commercial Notebooks. I pc Dell con l’AI ‘a bordo’ – in particolare il nuovo Dell Xps 13, il nuovo Inspiron 14, oltre a due modelli della linea Latitude (Latitude 7455 e 5455) – sono pensati per aiutare gli utenti a concentrarsi su ciò che conta e sulle attività concrete (e possono utilizzare un Llm anche on-premise) potendo contare su durata della batteria estesa e ottimizzazioni granulari possibili proprio grazie all’utilizzo dell’AI integrata in hardware grazie alle tecnologie Qualcomm Snapdragon X Series.

E’ però di Varun Chhabra, di fatto, il ‘piatto ricco’ che riguarda la proposizione infrastrutturale nel data center. Non si tratta di considerare tanto i prodotti quanto piuttosto leggere tra le righe l’approccio di Dell. “I carichi di lavoro con l’AI impattano su Gpu, networking e sì, anche le capacità storage” – spiega Chhabra. Ecco allora l’annuncio di Dell PowerScale F910, proposta Nas ad alta densità di archiviazione certificata Nvidia Dgx che concretizza Project Lightning (file system ‘parallelo’ per accesso ai dati non strutturati), mentre è sempre con Broadcom il potenziamento sulla componente networking che procede di pari passo con la maturazione di una proposta Dell specifica per la protezione dei dati comprensiva di backup e ripristino.

“L’ecosistema aperto permette di caricare sulle risorse infrastrutturali i workload AI. Alla base il valore delle partnership: da una parte con Nvidia e Meta, ma anche con Microsoft su Azure e con Hugging Faces, diventata di fatto il repository per modelli di intelligenza artificiale open source”. Dell Enterprise Hub è ospitato proprio su questo repository ed include containers e script dedicati personalizzati per aiutare gli utenti e gli sviluppatori a proteggere e distribuire facilmente i modelli AI open source – piuttosto che quelli già disponibili su Hugging Face – sull’infrastruttura Dell. Attraverso la partnership con Meta invece, “Dell consente di eseguire Llama 3 su infrastruttura Dell in modo da dimostrare di poter convalidare e pre-testare i modelli di Llama 3 sulla nostra infrastruttura, nonché i dati sulle prestazioni”.

Passi avanti anche con Dell Apex come proposta di sistemi chiavi in mano completamente integrati anche con il software dell’infrastruttura Dell e gli stack operativi cloud più popolari sul mercato. Quest’anno arriva un ulteriore miglioramento della piattaforma cloud Apex con Microsoft Azure, che consentirà ai clienti di portare le funzionalità AI di Microsoft Azure anche on-prem con le stesse Api usate in Azure. Chhabra: “Offre alle organizzazioni la flessibilità di avvicinare vari servizi di Azure AI, ai dati che si trovano in locale”.

Lato servizi: arrivano quattro nuovi servizi di implementazione AI con Microsoft Copilot, tra cui Copilot e Windows Copilot per la sicurezza, Copilot per le vendite e GitHub Copilot. Servono a mettere direttamente nelle mani degli utenti finali e dei team gli strumenti per i flussi di lavoro che i clienti già utilizzano ogni giorno. “Il nostro approccio per Copilot va ben oltre la disponibilità dell’ambiente tecnico e dell’implementazione. Le capacità di servizio aiutano i clienti a garantire che i dati siano al sicuro, così come ai knowledge worker di utilizzarli appieno”. Dell affianca gli utenti nella fase di implementazione, di configurazione, di test e l’onboarding finale degli utenti. “Infine, una volta implementato il progetto Copilot in produzione, possiamo aiutare i clienti a estendere le operazioni su larga scala conducendo sessioni di consulenza post-implementazione per ottimizzare l’utilizzo delle funzionalità Copilot per ottenere il miglior risultato”.

In sintesi, l’AI Factory Dell Technologies offre ampie funzionalità nell’intera infrastruttura e nel portafoglio di servizi e software Dell per supportare i clienti nelle loro attività di intelligenza artificiale. L’AI factory Dell declinata con Nvidia comprende infrastruttura, servizi e software Dell, servita sull’infrastruttura AI più avanzata grazie alla suite software di Nvidia; il tutto sostenuto dal tessuto della Nvidia ad alta velocità.

Poiché le Gpu di Nvidia stanno diventando sempre più potenti, Dell vuole aiutare i clienti a trarne il massimo vantaggio, per esempio attraverso PowerEdge XE9680L, progettato specificamente per il raffreddamento a liquido basato sulle Gpu Blackwell 200 di Nvidia, e con il raffreddamento a liquido diretto del chip. Ma Dell e Nvidia sfruttano le rispettive competenze nell’intelligenza artificiale su infrastrutture, software e servizi professionali, insieme, anche per aiutare a migliorare l’esperienza self-service dei loro utenti finali.

Dell Technology World è occasione per annunciare l’estensione della partnership strategica, sempre con Nvidia, per abilitare e accelerare le applicazioni AI all’edge. Questa partnership impatta Dell NativeEdge, – centralizza il deployment e la gestione dell’infrastruttura e delle applicazioni edge così da calare in sicurezza le operazioni edge utilizzando l’automazione, la progettazione aperta, i principi di sicurezza Zero Trust e la connettività multicloud – e Nvidia AI Enterprise. La collaborazione consente agli sviluppatori e agli operatori IT di sviluppare e distribuire soluzioni di inferenza AI all’edge sulle piattaforme edge native di Dell, nonché abilitare gli endpoint edge nativi Dell basati sull’accelerazione con le Gpu Nvidia e le più recenti soluzioni di intelligenza artificiale Nvidia per le aziende.

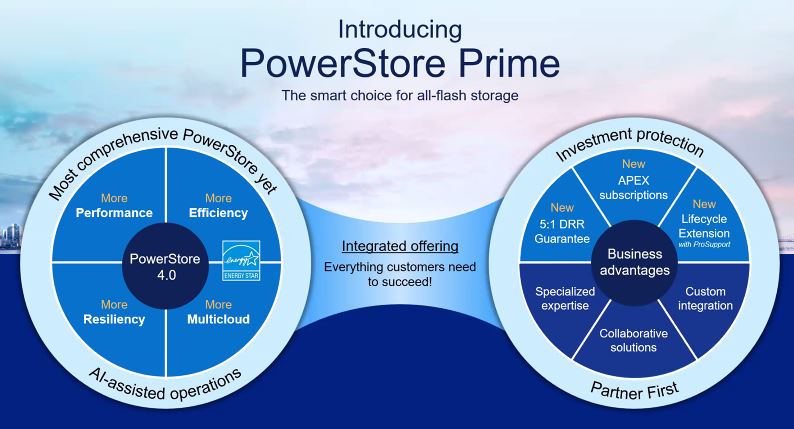

Shannon Champion introduce infine i vantaggi di Dell PowerStore Prime. E’ la proposta di punta all-flash storage, che vuole coniugare le performance tecnologiche con il Roi per i clienti, anche grazie all’ecosistema dei partner. Infatti, Dell PowerStore Prime è il primo lancio strategico per Dell Technologies dopo la presentazione delle strategie Partner First per lo storage.

Negli ultimi quattro anni, la famiglia Dell PowerStore ha registrato una crescita importante, è riconosciuta per la sua architettura scalabile e intelligente. Ora i miglioramenti impattano quattro ambiti chiave (come da illustrazione), tra cui l’efficienza energetica. I clienti Powerstore Prime, possono sfruttare il software Powerflex, migrare i dati in tempo reale da e verso storage a blocchi Dell Apex come in cloud e beneficiano di garanzia ulteriormente estesa a protezione del ciclo di vista degli investimenti.

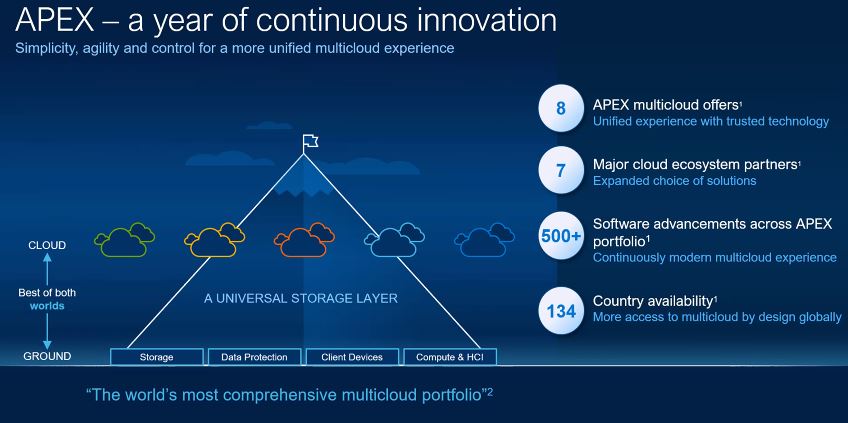

Dall’on-premise al multicloud, si arricchisce anche il portafoglio dell’offering Dell Apex che raccoglie end-to-end tutte le soluzioni fornite As-a-Service e in abbonamento, distribuite ovunque vi siano applicazioni e dati da valorizzare. Arrivano oltre 500 innovazioni software proprio su Dell Apex, la cui disponibilità è estesa a 134 Paesi. Quest’anno, Dell continuerà a sviluppare il portafoglio Apex per soddisfare le esigenze dei clienti in aree chiave come l’intelligenza artificiale e il multicloud. Lo fa portando semplicità nelle due aree. Apex Navigator, per esempio, si conferma software As a Service per gestire e semplificare DevOps e provisioning e la gestione del block storage nel cloud pubblico, nonché dello storage per Kubernetes. Automatizzando la configurazione e l’implementazione del rilevamento di queste risorse IT chiave, è possibile ridurre fino al 95% il tempo impiegato nella configurazione della propria infrastruttura cloud (è possibile valutare gratuitamente Apex Navigator per 90 giorni). Gli amministratori delle risorse storage non possono essere esperti in tutto, e con Apex Navigator per Kubernetes è disponibile una soluzione semplice per gestire l’archiviazione dei dati ‘containerizzati’. Gli amministratori possono facilmente eseguire l’onboarding di un cluster Kubernetes in soli cinque minuti o avviare un workload per spostare le applicazioni utilizzando un’interfaccia utente intuitiva su Dell Powerflex. E presto arriverà anche il supporto per la piattaforma cloud Apex per Red Hat Openshift.

Con Dell Apex AIOps sarà poi possibile semplificare le operations, e guadagnare controllo sull’infrastruttura e sulle applicazioni attraverso tre funzionalità integrate: la prima è l’osservabilità dell’infrastruttura – con l’obiettivo di risolvere i problemi relativi alle risorse multicloud, all’efficienza, alla sicurezza informatica e alla sostenibilità di Dell on-premise. La seconda è l’osservabilità dell’applicazione, per risolvere i problemi prestazionali specifici delle applicazioni fino al 70% più velocemente. La terza riguarda la gestione degli incident. Proprio con AIOps Assistant gli utenti possono sostanzialmente “parlare con la propria infrastruttura e ottenere risposte rapide, affidabili e semplici, impegnarsi in una conversazione naturale con l’assistente AIOps per porre domande di follow-up e comprendere i problemi in modo più dettagliato, proprio come si farebbe con qualsiasi altro modello linguistico di intelligenza artificiale”.

All’edge infine Dell è impegnata a migliorare l’integrazione dei dispositivi edge con i servizi Azure tramite la nuova automazione Azure Arc con Dell NativeEdge. In secondo luogo, grazie agli ultimi aggiornamenti software i container come Kubernetes possono essere eseguiti in modo nativo su endpoint edge nativi con il supporto anche per container bare-metal e ciò fornirà prestazioni, scalabilità e sicurezza migliori per le applicazioni.

Chiude Champion: “Abbiamo ampliato anche il supporto hardware dell’infrastruttura edge. Pertanto, con gli endpoint NativeEdge supportiamo diverse nuove workstation Precision Dell, oltre alla serie di server PowerEdge. Disponiamo inoltre di nuovi servizi NativeEdge che offrono guida esperta e supporto per la progettazione di applicazioni su misura mirati a massimizzare le prestazioni edge. NativeEdge pure è disponibile come abbonamento con Apex, per cui i clienti pagano un’unica tariffa mensile per l’intera proposta end-to-end”.

© RIPRODUZIONE RISERVATA