La comunità di Aws si è “trasferita” a Las Vegas dal 2 al 6 dicembre per Reinvent 2019, da sette anni appuntamento fisso che raduna sviluppatori clienti e partner da ogni parte del mondo. Quest’anno oltre 60mila sono i presenti all’evento che si apre “ufficialmente”, dopo la prima giornata di sessioni (molto affollate), con il keynote in notturna di Peter DeSantis, VP Global Infrastructure Aws.

“Il cloud rende possibile, potenzialmente a tutti, lavorare in ambienti di calcolo complessi, che altrimenti non sarebbero disponibili, ma che pochissimi hanno la capacità di realizzare – entra subito nel vivo DeSantis -. Per questo Aws lavora in modo particolare per migliorare l’offerta Hpc (High Performance Computing).

“Le applicazioni critiche, che richiedono elaborazione di grandi quantità di dati, in rapidità e con latenze basse – ammette il VP – sono le più difficili da indirizzare, richiedono risorse scalabili sia verso l’alto, sia verso il basso, in modo affidabile ed elastico. Nel tempo però abbiamo letto sul mercato come proprio su queste applicazioni si giochi una parte importante delle sfide dei clienti, in ambito industriale, come nelle scienze legate alla salute, alla biologia digitale e alla vita quotidiana)”. E per questo Aws, (vale oltre 36 miliardi di dollari il business in cloud di Amazon) prova a “re-inventare” l’esperienza Hpc.

Il supercomputing secondo Aws

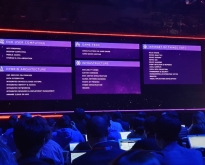

Lo fa lavorando su quattro punti: con un’infrastruttura di cluster server e performance a livello hardware e di rete “personalizzate in casa” (1), adottando le tecnologie già disponibili ma adattandole anche con sviluppi interni alle necessità, sfruttando per farlo le potenzialità offerte dalla virtualizzazione a tutti i livelli (2), quindi su chip e hardware in primis, come “sviluppando” hardware ottimizzato in modo da riuscire a bypassare lo stack networking a livello di kernel (3), integrando il più possibile la disponibilità di risorse Hpc con le librerie (software) e le applicazioni (4).

Un esempio: nel 2013 l’Hpc di Aws offriva capacità di elaborazione per 460 Tera al secondo e latenza di 12 millisecondi, nel 2019 sono migliorate di circa 20 volte queste capacità (con una latenza quasi dimezzata, a 7 millisecondi).

Tra chi beneficia degli ambienti Aws in cloud c’è il team di F1 della Williams. Ne parla Rob Smedley, head of vehicle performance per il team Williams Martini che sottolinea come “disporre di un ambiente per l’elaborazione dei dati in grado di scalare – ma anche di rimanere flessibili ed essere reattivi nei tempi di risposta porta a poter elaborare più ipotesi di progetto e di settaggio, fattori critici in un ambito competitivo come la formula uno”.

Tra le tecnologie distintive, DeSantis sottolinea in modo specifico le potenzialità di Nitro, la piattaforma sottostante alle istanze EC2 (Elastic Compute Cloud). Aws in questo caso ha ripensato la propria infrastruttura di virtualizzazione. E mentre gli hypervisor insistono solitamente su hardware, Bios, virtualizzano Cpu, storage e rete offrendo un set di funzioni condiviso per la loro gestione, con Nitro l’analisi delle funzioni citate è granulare e le singole funzionalità vengono “scaricate” su hardware e software dedicati, riducendo i costi ma fornendo migliori capacità.

Machine learning, un approccio “dedicato”

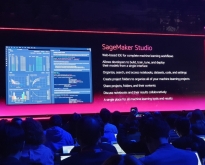

“L’approccio “dedicato”, continua DeSantis, caratterizza anche l’evoluzione dell’offerta in ambito machine learning“. Diverso è l’ambito in cui si gioca la partita, ma sostanzialmente uguale la strategia. I modelli di machine learning vivono di quattro fasi primarie: riconoscimento dei dati di training, la fase di training pura, l’elaborazione di un modello, l’approdo ad inferenze salienti e valide.

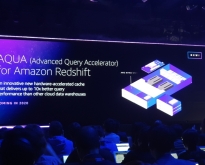

In questo caso Amazon ha lavorato ad un chip personalizzato, non ancora disponibile, conosciuto come Aws Inferentia. E’ in grado di supportare, tra gli altri, anche i framework di Tensorflow.

Fattore chiave per il ML di Amazon è l’idea di offrire un ambiente (Aws Elastic Inference) in cui l’accelerazione delle inferenze che sfruttano le Gpu sia certo sempre collegata alle istanze di Amazon EC2, ma in cui, in più, sia anche possibile disporre di una Gpu dedicata esclusivamente all’elaborazione dell’inferenza.

Alla base le nuove istanze (p3.dn.24xl di Amazon EC2) che sfruttano Gpu Nvidia Tesla V100 (8×32 Gbyte) su Intel Skylake 8175: un passo ancora avanti rispetto al precedente modello p3.16xl. L’offerta per il ML, tra l’altro, è un ambito in cui la concorrenza diretta più importante arriva da Google e per cui accelerare è per Amazon decisamente importante.

DeSantis in chiusura vuole raccogliere la sfida legata al problema della sostenibilità, sempre più ricorrente nei keynote dei top vendor e degli hyperscaler. Una sfida che sia per quanto riguarda l’High Performance Computing, sia per quanto riguarda lo sviluppo cloud è tutt’altro che risolta e che spesso si gioca su previsioni e buoni propositi non scontanti, al di là dei proclami.

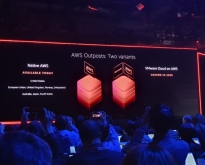

Aws oggi dispone di 22 region e ne ha annunciate altre 4 nuove, è attiva con 60 availability zone, conta 210 point of presence, e vanta 97 location in collegamento diretto ma soprattutto offre ai clienti traffico dati completamente criptato, per la sicurezza. L’azienda a Las Vegas si impegna al rispetto completo dell’Accordo di Parigi entro il 2050 e ha preso l’impegno addirittura di volerci arrivare dieci anni prima: alimenterà i data center con sole energie rinnovabili entro il 2030 (80% entro il 2024). Già nel 2019 aveva attivi 10 progetti in questa direzione in grado di generare 946 MW, e nel 2019 ha migliorato di quasi la metà questa capacità.

Per saperne di più leggi tutto il reportage Aws Reinvent 2019

© RIPRODUZIONE RISERVATA